Ядрове згладжування: відмінності між версіями

Створено шляхом перекладу сторінки «Kernel smoother» |

(Немає відмінностей)

|

Версія за 20:36, 5 квітня 2024

Ядрове згладжування або згладження (kernel smoother) — це статистичний метод оцінки дійснозначної функції як середньозважене значення сусідніх спостережених точок. Вага задається ядром, так щоб найближчі точки отримують найвищі ваги. Оцінювана функція є гладкою, а рівень гладкості задається єдиним параметром. Ядрове згладжування є типом зваженого рухомого середнього.

Означення

Нехай ядро, задане формулою

де:

- - евклідова норма

- - параметр (радіус ядра)

- D ( t ) зазвичай позитивна дійсна функція, значення якої зменшується (або не зростає) зі збільшенням відстані між X і X0 .

Популярні ядра, що використовуються для згладжування, включають параболічне (Епанечнікова), кубне та гауссове ядра.

Нехай - неперервною функцією від X. Для кожного , ядро-зважене середнє Надарая-Ватсона (згладжена оцінка Y(X)) визначається

де:

- N – кількість спостережуваних точок

- Y ( X i ) — спостереження в точках Xi .

Далі ми опишемо деякі окремі випадки ядрових згладжень.

Ядрове згладження Гауса

Ядро Гауса є одним із найпоширеніших ядер і виражається за допомогою рівняння

Тут b — масштаб довжини для вхідного простору.

Ядрове згладження найближчих точок

Ідея ядрового згладження найближчого сусіда полягає в наступному. Для кожної точки X0 беремо m найближчих сусідів і оцінюємо значення Y(X0) шляхом усереднення значень цих сусідів.

Формально, , де є m-м найближчим до X0 сусідом, і

Наприклад:

У цьому прикладі X є одновимірним. Для кожного X0, є середнім значенням 16 найближчих до X0 точок (позначено червоним кольором). Результат недостатньо гладкий.

Середньо ядрове згладження

Ідея середньо ядрового згладження полягає в наступному. Для кожної точки даних X0 виберемо стале значення відстані λ (радіус ядра або ширину вікна для p = 1 вимір) і обчислимо зважене середнє для всіх точок даних, які ближче ніж до X0 (чим ближче до X0 точки тим більшу вагу вони отримають).

Формально, а D(t) — одне з популярних ядер.

Наприклад:

Для кожного X0 ширина вікна стала, а вага кожної точки у вікні схематично позначена жовтою тінню на графіку. Видно, що оцінка плавна, але граничні точки зміщені. Причиною цього є неоднакова кількість точок (справа і зліва до X0 ) у вікні, коли X0 знаходиться досить близько до межі.

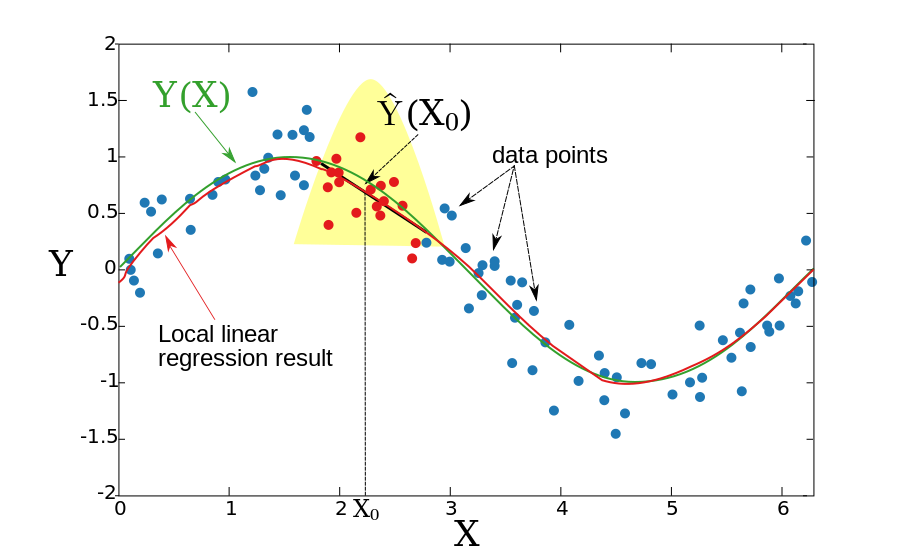

Локальна лінійна регресія

У двох попередніх розділах закладалось, що базова функція Y(X) локально константа, що давало змогу використовувати середньозважене значення оцінки. Ідея локальної лінійної регресії полягає в тому, що функція локально відповідає прямій лінії (чи гіперплощині у випадку вищих порядків), а не константі (горизонтальній лінії). Після підгонки лінії оцінка визначається значенням цієї лінії в точці X0. Повторюючи цю процедуру для кожного X0, можна отримати оцінку-функцію . Як і в розділі вище ширина вікна постійна Формально локальна лінійна регресія обчислюється шляхом оптимізації зваженої задачі найменшого квадрата.

У одновимірному випадку ( p = 1):

Розв'язок у вигляді формули:

де:

Наприклад:

Отримана функція є гладкою, і проблема зі зміщеними граничними точками не настільки кричуща.

Локальну лінійну регресію можна застосувати у будь-якому просторі, хоча питання про те, що таке локальне сусідство ускладнюється. Зазвичай використовують k найближчих тренувальних точок до тестової точки, щоб відповідати локальній лінійній регресії. Це може призвести до великої дисперсії встановленої функції. Щоб обмежити дисперсію, набір навчальних точок повинен містити тестову точку у своїй опуклій оболонці (див. посилання на Gupta et al.).

Локальна поліноміальна регресія

Замість підгонки локально лінійних функцій можна допасувати поліноміальні функції.

Для p=1 слід розв'язати задачу мінімізації:

з

У загальному випадку (p>1) слід мінімізувати:

Див. також

- Фільтр Савицького–Голея

- Методи ядра

- Оцінка щільності ядра

- Локальна регресія

- Ядерна регресія

Список літератури

- Li, Q. and J.S. Racine. Nonparametric Econometrics: Theory and Practice. Princeton University Press, 2007, ISBN 0-691-12161-3.

- T. Hastie, R. Tibshirani and J. Friedman, The Elements of Statistical Learning, Chapter 6, Springer, 2001. ISBN 0-387-95284-5ISBN 0-387-95284-5 (companion book site).

- M. Gupta, E. Garcia and E. Chin, "Adaptive Local Linear Regression with Application to Printer Color Management," IEEE Trans. Image Processing 2008.

![{\displaystyle h_{m}(X_{0})=\left\|X_{0}-X_{[m]}\right\|}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e649a2d186d0ff66a1aa6c00792a3f263293049d)

![{\displaystyle X_{[m]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c375afa1c3ce963071818546bfa67b2b846585ee)