Камера подій

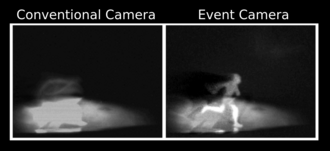

Камера подій, також відома як нейроморфна камера, [1] кремнієва сітківка [2] або датчик динамічного зору [3], є датчиком зображення, який реагує на локальні зміни яскравості. Камери для подій не знімають зображення за допомогою затвора, як це роблять звичайні (кадрові) камери. Натомість кожен піксель усередині камери подій працює незалежно й асинхронно, повідомляючи про зміну яскравості, лише коли вона відбувається.

Функціональний опис[ред. | ред. код]

Пікселі камери подій незалежно реагують на зміни яскравості, коли вони відбуваються. [4] Кожен піксель зберігає контрольний рівень яскравості та постійно порівнює його з поточним рівнем яскравості. Якщо різниця в яскравості перевищує порогове значення, цей піксель переписує свій контрольний рівень і генерує подію, яка містить адресу пікселя та мітку часу. Події також можуть містити полярність (збільшення або зменшення) зміни яскравості або миттєве вимірювання рівня освітленості. [5] Таким чином, камери подій видають асинхронний потік подій, викликаних зміною освітлення сцени.

Камери подій мають часову роздільну здатність порядку мікросекунд, динамічний діапазон 120 дБ, а також менше недо/перевитримку та розмиття руху, [4][6] ніж у кадрових камер. Це дозволяє їм точніше відстежувати рух об’єкта та камери (оптичний потік). Вони дають інформацію в градаціях сірого. Спочатку (2014) роздільна здатність була обмежена 100 пікселями. Пізніше роздільна здатність досягла 640x480 у 2019 році. Оскільки окремі пікселі спрацьовують незалежно, камери подій виглядають придатними для інтеграції з асинхронними обчислювальними архітектурами, такими як нейроморфні обчислення. Незалежність пікселів дозволяє цим камерам справлятися зі сценами з яскраво та слабко освітленими областями без необхідності їх усереднення. [7]

| Датчик | Динамічний діапазон (дБ) | Еквівалент частоти кадрів* (fps) | Просторова роздільна здатність (МП) | Енерго-споживання (мВт) |

|---|---|---|---|---|

| Людське око | 30–40 | 200-300 | - | 10 [8] |

| Камера DSLR високого класу ( Nikon D850 ) | 44,6 [9] | 120 | 2–8 | - |

| Надшвидкісна камера (Phantom v2640) [10] | 64 | 12 500 | 0,3–4 | - |

| Камера подій [11] | 120 | 1 000 000 | 0,1–0,2 | 30 |

*Вказує на часову роздільну здатність, оскільки очі людини та камери подій не виводять кадри.

Типи[ред. | ред. код]

Датчики часового контрасту (такі як DVS [4] (датчик динамічного бачення) або sDVS [12] (чутливий DVS)) генерують події, які вказують на полярність (збільшення або зменшення яскравості), тоді як датчики часового зображення [5] вказують миттєву інтенсивність світла кожної події. DAVIS [13] (Динамічний і активний піксельний датчик зору) містить глобальний датчик активного пікселя затвора (APS) на додаток до динамічного датчика зору (DVS), який використовує той самий масив фотодатчиків. Таким чином, він має можливість створювати кадри зображень разом із подіями. Багато камер подій додатково мають інерційний вимірювальний блок (IMU).

| Назва | Вивід події | Наявність кадрів | Колір | IMU | Виробник | Комерційна доступність | Роздільна здатність |

|---|---|---|---|---|---|---|---|

| DVS128[4] | Полярність | Ні | Ні | Ні | Inivation | Ні | 128x128 |

| sDVS128[12] | Полярність | Ні | Ні | Ні | CSIC | Ні | 128x128 |

| DAVIS240[13] | Полярність | Так | Ні | Так | Inivation | Так | 240x180 |

| DAVIS346[14] | Полярність | Так | Ні | Так | Inivation | Так | 346 x 260 |

| DVXplorer[15] | Полярність | Ні | Ні | Так | Inivation | Так | 640 x 480 |

| SEES[16] | Полярність | Так | Ні | Так | Insightness | Так | |

| Metavision Packaged Generation 3 Sensor[17] | Полярність | Ні | Ні | Ні | Prophesee | Так | 640x480 |

| SilkyEvCam camera (Prophesee Gen 3)[18] | Полярність | Ні | Ні | Ні | Century Arks / Prophesee | Так | 640×480 |

| VisionCamEB camera (Prophesee Gen 3) [19] | Полярність | Ні | Ні | Ні | Imago Technologies / Prophesee | Так | 640×480 |

| Samsung DVS[20] | Полярність | Ні | Ні | Так | Samsung | Так | 640×480 |

| Onboard[5] | Полярність | Ні | Ні | Так | Prophesee | Ні | 640×480 |

| Celex[21] | Інтенсивність | Так | Ні | Так | CelePixel | Так | 64x64 |

| IMX636[22] sensor | Полярність | Так | Ні | Ні | Sony / Prophesee | Так | 1280x720 |

| EVK3[23] camera (IMX636 ES/ Prophesee Gen 3.1) | Полярність | Ні | Ні | Ні | Prophesee | Так | 1280x720 / 640×480 |

| EVK4[24] camera (IMX636 ES) | Полярність | Ні | Ні | Ні | Prophesee | Так | 1280x720 |

| IMX637[25] sensor | Полярність | Так | Ні | Ні | Sony / Prophesee | Ні | 640x512 |

Ретиноморфні сенсори[ред. | ред. код]

Іншим класом датчиків подій є так звані ретиноморфні датчики. Хоча термін ретиноморфний використовувався для загального опису датчиків подій, [26][27] у 2020 році він був прийнятий як назва конкретної конструкції датчика на основі послідовного з’єднання резистора та фоточутливого конденсатора. [28] Ці конденсатори відрізняються від фотоконденсаторів, які використовуються для накопичення сонячної енергії [29], і натомість призначені для зміни ємності під час освітлення. Вони незначно заряджаються/розряджаються при зміні ємності, але в інших випадках залишаються в рівновазі. Коли світлочутливий конденсатор встановлюється послідовно з резистором і вхідна напруга прикладається до ланцюга, результатом є датчик, який видає напругу, коли інтенсивність світла змінюється, але в іншому випадку не змінюється.

На відміну від інших датчиків подій (як правило, фотодіода та деяких інших елементів схеми), ці датчики виробляють сигнал природньо. Тому їх можна вважати єдиним пристроєм, який дає такий самий результат, як невелика схема в інших камерах подій. Ретиноморфні сенсори на сьогоднішній день вивчалися лише в дослідницькому середовищі. [30] [31] [32] [33]

Алгоритми[ред. | ред. код]

Відновлення зображення[ред. | ред. код]

Відновлення зображення з подій має потенціал для створення зображень і відео з широким динамічним діапазоном, високою тимчасовою роздільною здатністю та зменшеним розмиттям руху. Відновлення зображення може бути досягнуте за допомогою часового згладжування, наприклад високочастотного або додаткового фільтра. [34] Альтернативні методи включають оптимізацію [35] та градієнтну оцінку [36] з подальшим інтегруванням Пуассона.

Просторові згортки[ред. | ред. код]

Концепція просторової згортки, керованої подіями, була представлена в 1999 році [37] (до DVS), але пізніше була узагальнена під час проекту ЄС CAVIAR [38] (під час якого було винайдено DVS) шляхом проектування довільного ядра згортки для кожної події навколо координати події в масиві пікселів інтегрування та запуску. [39] Розширення до багатоядерних згорток, керованих подіями [40] дозволяє створювати керовані подіями глибокі згорткові нейронні мережі. [41]

Виявлення та відстеження руху[ред. | ред. код]

Сегментація та виявлення рухомих об'єктів, які спостерігає камера подій, може здатися тривіальним завданням, оскільки це робить сенсор безпосередньо на мікросхемі. Однак ці задачі є складними, оскільки події несуть мало інформації [42] і не містять корисних візуальних функцій, таких як текстура та колір. [43] Ці завдання стають ще більш складними з огляду на рухому камеру [42], оскільки події запускаються всюди на площині зображення, спричинені рухомими об’єктами та статичною сценою (чий видимий рух викликаний рухом камери). Деякі з останніх підходів до вирішення цієї проблеми пропонують включення моделей компенсації руху [44] [45] і традиційних алгоритмів кластеризації. [46] [47] [43] [48]

Потенційні застосування[ред. | ред. код]

Типові сценарії, коли камери подій мають переваги перед традиційними камерами включають системи взаємодії в реальному часі, такі як автономні транспортні засоби, робототехніка [32], носима електроніка [49]. Камери подій також використовуються для розпізнавання об’єктів, спостереження і моніторингу [50] тощо . Збройні сили США розглядають інфрачервоні та інші камери подій через їхнє менше енергоспоживання та менше виділення тепла. [7]

Див. також[ред. | ред. код]

Література[ред. | ред. код]

- ↑ Li, Hongmin; Liu, Hanchao; Ji, Xiangyang; Li, Guoqi; Shi, Luping (2017). CIFAR10-DVS: An Event-Stream Dataset for Object Classification. Frontiers in Neuroscience (English) . 11: 309. doi:10.3389/fnins.2017.00309. ISSN 1662-453X. PMC 5447775. PMID 28611582.

- ↑ Sarmadi, Hamid; Muñoz-Salinas, Rafael; Olivares-Mendez, Miguel A.; Medina-Carnicer, Rafael (2021). Detection of Binary Square Fiducial Markers Using an Event Camera. IEEE Access. 9: 27813—27826. arXiv:2012.06516. doi:10.1109/ACCESS.2021.3058423. ISSN 2169-3536.

- ↑ Liu, Min; Delbruck, Tobi (May 2017). Block-matching optical flow for dynamic vision sensors: Algorithm and FPGA implementation. 2017 IEEE International Symposium on Circuits and Systems (ISCAS). с. 1—4. arXiv:1706.05415. doi:10.1109/ISCAS.2017.8050295. ISBN 978-1-4673-6853-7. Процитовано 27 червня 2021.

- ↑ а б в г Lichtsteiner, P.; Posch, C.; Delbruck, T. (February 2008). A 128×128 120 dB 15μs Latency Asynchronous Temporal Contrast Vision Sensor (PDF). IEEE Journal of Solid-State Circuits. 43 (2): 566—576. Bibcode:2008IJSSC..43..566L. doi:10.1109/JSSC.2007.914337. ISSN 0018-9200. Архів оригіналу (PDF) за 3 травня 2021. Процитовано 18 березня 2023.

- ↑ а б в Posch, C.; Matolin, D.; Wohlgenannt, R. (January 2011). A QVGA 143 dB Dynamic Range Frame-Free PWM Image Sensor With Lossless Pixel-Level Video Compression and Time-Domain CDS. IEEE Journal of Solid-State Circuits. 46 (1): 259—275. Bibcode:2011IJSSC..46..259P. doi:10.1109/JSSC.2010.2085952. ISSN 0018-9200.

- ↑ Longinotti, Luca. Product Specifications. iniVation. Архів оригіналу за 2 квітня 2019. Процитовано 21 квітня 2019.

- ↑ а б A new type of camera. The Economist. 29 січня 2022. ISSN 0013-0613. Процитовано 2 лютого 2022.

- ↑ Skorka, Orit (1 липня 2011). Toward a digital camera to rival the human eye. Journal of Electronic Imaging. 20 (3): 033009–033009–18. Bibcode:2011JEI....20c3009S. doi:10.1117/1.3611015. ISSN 1017-9909.

- ↑ DxO. Nikon D850 : Tests and Reviews | DxOMark. www.dxomark.com. Процитовано 22 квітня 2019.

- ↑ Phantom v2640. www.phantomhighspeed.com. Процитовано 22 квітня 2019.

- ↑ Longinotti, Luca. Product Specifications. iniVation. Архів оригіналу за 2 квітня 2019. Процитовано 22 квітня 2019.

- ↑ а б Serrano-Gotarredona, T.; Linares-Barranco, B. (March 2013). A 128x128 1.5% Contrast Sensitivity 0.9% FPN 3μs Latency 4mW Asynchronous Frame-Free Dynamic Vision Sensor Using Transimpedance Amplifiers (PDF). IEEE Journal of Solid-State Circuits. 48 (3): 827—838. Bibcode:2013IJSSC..48..827S. doi:10.1109/JSSC.2012.2230553. ISSN 0018-9200.

- ↑ а б Brandli, C.; Berner, R.; Yang, M.; Liu, S.; Delbruck, T. (October 2014). A 240 × 180 130 dB 3 µs Latency Global Shutter Spatiotemporal Vision Sensor. IEEE Journal of Solid-State Circuits. 49 (10): 2333—2341. Bibcode:2014IJSSC..49.2333B. doi:10.1109/JSSC.2014.2342715. ISSN 0018-9200.

- ↑ Taverni, Gemma; Paul Moeys, Diederik; Li, Chenghan; Cavaco, Celso; Motsnyi, Vasyl; San Segundo Bello, David; Delbruck, Tobi (May 2018). Front and Back Illuminated Dynamic and Active Pixel Vision Sensors Comparison (PDF). IEEE Transactions on Circuits and Systems II: Express Briefs. 65 (5): 677—681. doi:10.1109/TCSII.2018.2824899. ISSN 1549-7747.

- ↑ Inivation Specifications - Current models (PDF).

- ↑ Insightness – Sight for your device. Процитовано 22 квітня 2019.

- ↑ Metavision® Packaged Sensor. PROPHESEE (амер.). Процитовано 14 квітня 2022.

- ↑ Event Based Vision Camera - Century Arks. Процитовано 30 серпня 2021.

- ↑ IMAGO I PROPHESEE first industrial grade event-based vision system. PROPHESEE (амер.). 14 лютого 2019. Процитовано 14 квітня 2022.

- ↑ Son, Bongki; Suh, Yunjae; Kim, Sungho; Jung, Heejae; Kim, Jun-Seok; Shin, Changwoo; Park, Keunju; Lee, Kyoobin; Park, Jinman (February 2017). 4.1 A 640×480 dynamic vision sensor with a 9µm pixel and 300Meps address-event representation. 2017 IEEE International Solid-State Circuits Conference (ISSCC). San Francisco, CA, USA: IEEE. с. 66—67. doi:10.1109/ISSCC.2017.7870263. ISBN 9781509037582.

- ↑ Chen, Shoushun; Tang, Wei; Zhang, Xiangyu; Culurciello, Eugenio (December 2012). A 64 $\times$ 64 Pixels UWB Wireless Temporal-Difference Digital Image Sensor. IEEE Transactions on Very Large Scale Integration (VLSI) Systems. 20 (12): 2232—2240. doi:10.1109/TVLSI.2011.2172470. ISSN 1063-8210.

- ↑ Sony to Release Two Types of Stacked Event-Based Vision Sensors with the Industry's Smallest 4.86μm Pixel Size for Detecting Subject Changes Only Delivering High-Speed, High-Precision Data Acquisition to Improve Industrial Equipment Productivity|News Releases|Sony Semiconductor Solutions Group. Sony Semiconductor Solutions Group (яп.). Архів оригіналу за 24 жовтня 2021. Процитовано 28 жовтня 2021.

- ↑ Event-Based Evaluation Kit 3 - VGA / HD. PROPHESEE (амер.). Процитовано 14 квітня 2022.

- ↑ Staff, Embedded (13 квітня 2022). Eval kit for Sony sensor featuring Prophesee event-based vision tech. Embedded.com (амер.). Процитовано 14 квітня 2022.

- ↑ Sony® Launches the new IMX636 and IMX637 Event-Based Vision Sensors. FRAMOS (амер.). Процитовано 17 травня 2022.

- ↑ Boahen, K. (1996). Retinomorphic vision systems. Proceedings of Fifth International Conference on Microelectronics for Neural Networks: 2—14. doi:10.1109/MNNFS.1996.493766. ISBN 0-8186-7373-7.

- ↑ Posch, Christoph; Serrano-Gotarredona, Teresa; Linares-Barranco, Bernabe; Delbruck, Tobi (2014). Retinomorphic Event-Based Vision Sensors: Bioinspired Cameras With Spiking Output. Proceedings of the IEEE. 102 (10): 1470—1484. doi:10.1109/JPROC.2014.2346153. ISSN 1558-2256.

- ↑ Trujillo Herrera, Cinthya; Labram, John G. (7 грудня 2020). A perovskite retinomorphic sensor. Applied Physics Letters. 117 (23): 233501. Bibcode:2020ApPhL.117w3501T. doi:10.1063/5.0030097. ISSN 0003-6951.

- ↑ Miyasaka, Tsutomu; Murakami, Takurou N. (25 жовтня 2004). The photocapacitor: An efficient self-charging capacitor for direct storage of solar energy. Applied Physics Letters. 85 (17): 3932—3934. Bibcode:2004ApPhL..85.3932M. doi:10.1063/1.1810630. ISSN 0003-6951.

- ↑ Perovskite sensor sees more like the human eye. Physics World (брит.). 18 січня 2021. Процитовано 28 жовтня 2021.

- ↑ Simple Eyelike Sensors Could Make AI Systems More Efficient. Inside Science (англ.). Процитовано 28 жовтня 2021.

- ↑ а б Hambling, David. AI vision could be improved with sensors that mimic human eyes. New Scientist (амер.). Процитовано 28 жовтня 2021.

- ↑ An eye for an AI: Optic device mimics human retina. BBC Science Focus Magazine (англ.). Процитовано 28 жовтня 2021.

- ↑ а б Scheerlinck, Cedric; Barnes, Nick; Mahony, Robert (2019). Continuous-Time Intensity Estimation Using Event Cameras. Computer Vision – ACCV 2018. Lecture Notes in Computer Science (англ.). Springer International Publishing. 11365: 308—324. arXiv:1811.00386. doi:10.1007/978-3-030-20873-8_20. ISBN 9783030208738.

- ↑ Pan, Liyuan; Scheerlinck, Cedric; Yu, Xin; Hartley, Richard; Liu, Miaomiao; Dai, Yuchao (June 2019). Bringing a Blurry Frame Alive at High Frame-Rate With an Event Camera. 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach, CA, USA: IEEE. с. 6813—6822. arXiv:1811.10180. doi:10.1109/CVPR.2019.00698. ISBN 978-1-7281-3293-8.

- ↑ Scheerlinck, Cedric; Barnes, Nick; Mahony, Robert (April 2019). Asynchronous Spatial Image Convolutions for Event Cameras. IEEE Robotics and Automation Letters. 4 (2): 816—822. arXiv:1812.00438. doi:10.1109/LRA.2019.2893427. ISSN 2377-3766.

- ↑ Serrano-Gotarredona, T.; Andreou, A.; Linares-Barranco, B. (Sep 1999). AER Image Filtering Architecture for Vision Processing Systems. IEEE Transactions on Circuits and Systems I: Fundamental Theory and Applications. 46 (9): 1064—1071. doi:10.1109/81.788808. ISSN 1057-7122.

{{cite journal}}:|hdl-access=вимагає|hdl=(довідка) - ↑ Serrano-Gotarredona, R.; et, al (Sep 2009). CAVIAR: A 45k-Neuron, 5M-Synapse, 12G-connects/sec AER Hardware Sensory-Processing-Learning-Actuating System for High Speed Visual Object Recognition and Tracking. IEEE Transactions on Neural Networks. 20 (9): 1417—1438. doi:10.1109/TNN.2009.2023653. ISSN 1045-9227. PMID 19635693.

{{cite journal}}:|hdl-access=вимагає|hdl=(довідка) - ↑ Serrano-Gotarredona, R.; Serrano-Gotarredona, T.; Acosta-Jimenez, A.; Linares-Barranco, B. (Dec 2006). A Neuromorphic Cortical-Layer Microchip for Spike-Based Event Processing Vision Systems. IEEE Transactions on Circuits and Systems I: Regular Papers. 53 (12): 2548—2566. doi:10.1109/TCSI.2006.883843. ISSN 1549-8328.

{{cite journal}}:|hdl-access=вимагає|hdl=(довідка) - ↑ Camuñas-Mesa, L.; et, al (Feb 2012). An Event-Driven Multi-Kernel Convolution Processor Module for Event-Driven Vision Sensors. IEEE Journal of Solid-State Circuits. 47 (2): 504—517. Bibcode:2012IJSSC..47..504C. doi:10.1109/JSSC.2011.2167409. ISSN 0018-9200.

{{cite journal}}:|hdl-access=вимагає|hdl=(довідка) - ↑ Pérez-Carrasco, J.A.; Zhao, B.; Serrano, C.; Acha, B.; Serrano-Gotarredona, T.; Chen, S.; Linares-Barranco, B. (November 2013). Mapping from Frame-Driven to Frame-Free Event-Driven Vision Systems by Low-Rate Rate-Coding and Coincidence Processing. Application to Feed-Forward ConvNets. IEEE Transactions on Pattern Analysis and Machine Intelligence. 35 (11): 2706—2719. doi:10.1109/TPAMI.2013.71. ISSN 0162-8828. PMID 24051730.

- ↑ а б Gallego, Guillermo; Delbruck, Tobi; Orchard, Garrick Michael; Bartolozzi, Chiara; Taba, Brian; Censi, Andrea; Leutenegger, Stefan; Davison, Andrew; Conradt, Jorg (2020). Event-based Vision: A Survey. IEEE Transactions on Pattern Analysis and Machine Intelligence. PP (1): 154—180. arXiv:1904.08405. doi:10.1109/TPAMI.2020.3008413. ISSN 1939-3539. PMID 32750812.

- ↑ а б Mondal, Anindya; R, Shashant; Giraldo, Jhony H.; Bouwmans, Thierry; Chowdhury, Ananda S. (2021). Moving Object Detection for Event-Based Vision Using Graph Spectral Clustering. International Conference on Computer Vision (ICCV) Workshops (англ.): 876—884. arXiv:2109.14979. doi:10.1109/ICCVW54120.2021.00103. ISBN 978-1-6654-0191-3 — через IEEE Xplore.

- ↑ Mitrokhin, Anton; Fermuller, Cornelia; Parameshwara, Chethan; Aloimonos, Yiannis (October 2018). Event-Based Moving Object Detection and Tracking. 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Madrid: IEEE: 1—9. arXiv:1803.04523. doi:10.1109/IROS.2018.8593805. ISBN 978-1-5386-8094-0.

- ↑ Stoffregen, Timo; Gallego, Guillermo; Drummond, Tom; Kleeman, Lindsay; Scaramuzza, Davide (2019). Event-Based Motion Segmentation by Motion Compensation. 2019 IEEE/CVF International Conference on Computer Vision (ICCV). с. 7244—7253. arXiv:1904.01293. doi:10.1109/ICCV.2019.00734. ISBN 978-1-7281-4803-8.

- ↑ Piątkowska, Ewa; Belbachir, Ahmed Nabil; Schraml, Stephan; Gelautz, Margrit (June 2012). Spatiotemporal multiple persons tracking using Dynamic Vision Sensor. 2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops: 35—40. doi:10.1109/CVPRW.2012.6238892. ISBN 978-1-4673-1612-5.

- ↑ Chen, Guang; Cao, Hu; Aafaque, Muhammad; Chen, Jieneng; Ye, Canbo; Röhrbein, Florian; Conradt, Jörg; Chen, Kai; Bing, Zhenshan (2 грудня 2018). Neuromorphic Vision Based Multivehicle Detection and Tracking for Intelligent Transportation System. Journal of Advanced Transportation (англ.). 2018: e4815383. doi:10.1155/2018/4815383. ISSN 0197-6729.

- ↑ Mondal, Anindya; Das, Mayukhmali (8 листопада 2021). Moving Object Detection for Event-based Vision using k-means Clustering. 2021 IEEE 8th Uttar Pradesh Section International Conference on Electrical, Electronics and Computer Engineering (UPCON). с. 1—6. arXiv:2109.01879. doi:10.1109/UPCON52273.2021.9667636. ISBN 978-1-6654-0962-9.

- ↑ Delbruck, Tobi (2016-09). Neuromorophic vision sensing and processing. 2016 46th European Solid-State Device Research Conference (ESSDERC). IEEE. с. 7—14. doi:10.1109/ESSDERC.2016.7599576. ISBN 978-1-5090-2969-3. Процитовано 18 березня 2023.

- ↑ Litzenberger, M.; Kohn, B.; Belbachir, A.N.; Donath, N.; Gritsch, G.; Garn, H.; Posch, C.; Schraml, S. (2006-09). Estimation of Vehicle Speed Based on Asynchronous Data from a Silicon Retina Optical Sensor. 2006 IEEE Intelligent Transportation Systems Conference. с. 653—658. doi:10.1109/ITSC.2006.1706816. Процитовано 18 березня 2023.