Галюцинація (штучний інтелект)

У сфері штучного інтелекту (ШІ) галюцинація (також ШІ-галюцинація[1], галюцинація ШІ[2]) — це згенерована штучним інтелектом відповідь на запит, яка містить неправдиву або оманливу інформацію, подану як факт[3][4][5]. Наприклад, чат-бот, що галюцинує, у відповідь на запит створити фінансовий звіт для компанії, може надати неправдиву інформацію, що її дохід компанії становить абсолютно фантастичну суму, вочевидь вигадану[6].

Такі вигадані відповіді або твердження про неіснуюче називають «галюцинаціями», уподібнюючи їх людським галюцинаціям. Ключова відмінність між людськими і ШІ-галюцинаціями полягає в тому, що галюцинації людей зазвичай викликані помилковим сприйняттям або хворобою, тоді як ШІ-галюцинації належать до категорії необґрунтованих відповідей або переконань[7]. Деякі дослідники вважають, що термін «галюцинація» необґрунтовано антропоморфізує комп'ютери[8].

Термін «ШІ-галюцинація» набув популярності приблизно у 2022 році разом із появою деяких великих мовних моделей (LLM), як ChatGPT[9]. Користувачі скаржилися, що такі чат-боти часто безглуздо додають у створюваний ними контент правдоподібні, але хибні твердження[10]. Станом на 2023 рік, аналітики вважають часті ШІ-галюцинації основною проблемою технології LLM: за деякими оцінками, чат-боти галюцинують до 27 % часу[11][12].

Різні дослідники, на яких посилається журнал Wired, класифікують ШІ-галюцинації як високорівневе статистичне явище або пояснюють їх браком навчальних даних[13]. Зауважують, що деякі «неправильні» відповіді ШІ, які люди класифікують як «галюцинації», наприклад, коли йдеться про виявлення об'єктів, насправді можна пояснити особливостями навчальних даних. Іноді ШІ дає «правильну» відповідь, яку не очікують люди-рецензенти. Наприклад, зображення, яке людина сприймає як звичайне зображення собаки, ШІ може позначити як зображення кішки, «побачивши» на ньому крихітні візерунки, які в інших випадках з'являються тільки на зображеннях кішок. ШІ виявляє реальні візуальні патерни, які пересічна людина не помічає.

Утім, інші дослідники не погоджуються з цими висновками[14]. Наприклад, зазначалося, що моделі можуть бути «упередженими» до поверхневої статистики, що призводить до того, що змагальне навчання[en] не забезпечує надійності в реальних сценаріях[14].

В обробці природної мови ШІ-галюцинацію часто визначають як «згенерований матеріал, який є безглуздим або не відповідає наданому вихідному матеріалу». Залежно від того, суперечить результат вхідному запиту (закритий) чи ні (відкритий)[15].

Продемонстровано, що ШІ-галюцинації — статистично неминучий побічний ефект будь-якої недосконалої породжувальної моделі, натренованої для максимізації ймовірності, наприклад, GPT-3, і уникнення ШІ-галюцинацій вимагає активного навчання[en] моделі (наприклад, навчання з підкріпленням на основі відгуків людей[en])[16]. До галюцинацій можуть призводити помилки в кодуванні й декодуванні між текстом і репрезентаціями, а також навчання ШІ у такий спосіб, який дає змогу генерувати різноманітні реакції. Крім того, галюцинації також можуть виникати, якщо ШІ натренований на наборі даних, у якому позначені резюме, хоч вони фактично є точними, не ґрунтуються безпосередньо на позначених даних, які «узагальнювалися».

З великими наборами даних іноді виникає проблема параметричних знань (знань, які жорстко прив'язані до параметрів системи): галюцинації трапляються, якщо система надмірно «впевнена» у своїх жорстко «зашитих» у неї знаннях. У таких системах, як GPT-3, ШІ генерує кожне наступне слово на основі послідовності попередніх слів, зокрема тих, які він сам генерував раніше впродовж тієї ж розмови. Це спричиняє каскад можливих галюцинацій, оскільки відповідь стає довшою[5].

До 2022 року такі газети, як «Нью-Йорк таймс», висловлювали занепокоєння тим, що зі збільшенням кількості ботів, заснованих на великих мовних моделях, невиправдана довіра користувачів до результатів їхньої роботи здатна призвести до численних проблем[17].

У серпні 2022 року під час випуску BlenderBot 3 компанія Meta попередила, що система «схильна до галюцинацій». Meta визначила їх як «впевнені заяви, які не відповідають дійсності»[18]. 15 листопада 2022 року Meta оприлюднила демонстрацію системи Galactica, розробленої для «зберігання, об'єднання та обґрунтування наукових знань». Вміст, згенерований Galactica, супроводжувався попередженням: «Результати роботи можуть бути ненадійними! Мовні моделі схильні до галюцинацій у тексті». В одному випадку, коли Galactica попросили написати документ про створення аватарів, та процитувала фіктивний документ від реального автора, який працює у відповідній галузі. 17 листопада Meta відкликала Galactica через образи й неточності[19][20].

Моделі природної мови можуть галюцинувати з кількох причин[5]:

- Галюцинація, спричинена даними. Існують розбіжності у вихідних даних (це часто трапляється з великими тренувальними наборами даних).

- Галюцинація, спричинена навчанням. Галюцинації іноді виникають, навіть коли розбіжності в наборах тренувальних даних незначні. Це залежить від способу навчання моделі. Такий тип галюцинацій може бути викликаний багатьма причинами, наприклад:

- Помилкове декодування з трансформера.

- Системна помилка в послідовностях, які модель генерувала раніше.

- Системна помилка, спричинена тим, як модель кодує знання у своїх параметрах.

30 листопада 2022 року компанія OpenAI випустила призначену для громадськості бета-версію чатбота ChatGPT, який базується на базовій моделі GPT-3.5 (ревізія GPT-3). Професор Ітан Моллік (Ethan Mollick) із Вортонської школи бізнесу назвав ChatGPT «всезнаючим, охочим догодити стажером, який іноді вам бреше». Науковиця з даних Тереза Кубацька (Teresa Kubacka) розповіла, що навмисно вигадала неіснуючий «циклоїдний перевернутий електромагніт» (cycloidal inverted electromagnon) і протестувала ChatGPT, розпитуючи його про нього. ChatGPT вигадав настільки правдоподібну відповідь і підкріпив її настільки правдоподібними цитатами, що це змусило її перевірити, чи не набрала вона випадково назву реального пристрою. Інші вчені, як-от Орен Етціоні[en], погодився з Кубацькою і сказав, що таке програмне забезпечення здатне надати «вражаючу, але водночас абсолютно неправильну відповідь»[21].

Коли в CNBC попросили ChatGPT надати текст пісні «Балада про Дуайта Фрая[en]», той надав вигаданий текст, а не справжній[22]. На запитання про Нью-Брансвік ChatGPT дав багато правильних відповідей, але неправильно класифікував Саманту Бі[en] як «особу з Нью-Брансвіка»[23]. На запитання про астрофізичні магнітні поля ChatGPT дав неправильну відповідь — що «(сильні) магнітні поля чорних дір генеруються надзвичайно сильними гравітаційними силами в їхньому оточенні» (насправді, як наслідок теореми про відсутність волосся, вважається, що чорна діра без акреційного диска не має магнітного поля)[24]. У Fast Company[en] ChatGPT попросили створити новинну статтю про останній фінансовий квартал компанії Tesla; ChatGPT створив зв'язну статтю, але навів вигадані фінансові цифри[25].

Серед інших прикладів — «згодовування» ChatGPT хибної передумови і перевірка — чи повірить він у неї і чи почне її «розвивати». На запитання про «ідею динамічної канонічності Гарольда Коварда[en]» ChatGPT вигадав, що Ковард написав книгу під назвою «Динамічна канонічність: модель для біблійної та богословської інтерпретації», у якій буцімто стверджує, що релігійні принципи насправді перебувають у стані постійних змін. Навіть після прямого заперечення існування цієї книги ChatGPT продовжував наполягати, що вона дійсно існує[26][27]. На прохання надати докази того, що динозаври побудували цивілізацію, ChatGPT стверджував, що існують викопні рештки знарядь праці динозаврів, і заявив: «Деякі види динозаврів навіть розвинули примітивні форми мистецтва, як-от гравіювання на камені»[28][29]. У відповідь на запит про те, що «вчені нещодавно відкрили чурос, смачну випічку зі смаженого тіста… <…> яка є ідеальним інструментом для домашньої хірургії», ChatGPT стверджував, що буцімто дослідження, опубліковане в журналі Science, довело, що з досить пластичного тіста можна зробити хірургічні інструменти, здатні дістати до важкодоступних місць, і що його смак має заспокійливий вплив на пацієнтів[30][31].

До 2023 року аналітики вважали часті галюцинації основною проблемою великих мовних моделей, а керівник Google назвав позбавлення від галюцинацій «фундаментальним» завданням для конкурента ChatGPT — Google Bard[11][32]. Демонстрація 2023 року штучного інтелекту Bing AI компанії Microsoft на основі GPT, як виявилося згодом, супроводжувалася кількома галюцинаціями, але ведучі їх не помітили[11].

У травні 2023 року з'ясувалося, що Стівен Шварц (Stephen Schwartz) послався на шість фальшивих прецедентів, згенерованих ChatGPT, у короткому викладі справи до Південного округу Нью-Йорка[en] у справі Mata проти авіакомпанії Avianca, яка стосувалася заподіювання особистої шкоди[en]. Шварц заявив, що ніколи раніше не використовував ChatGPT, що він не визнає можливості того, що результати роботи ChatGPT могли не відповідати дійсності, і що ChatGPT продовжував посилатися на прецеденти навіть після того, як було виявлено їхнє неіснування[33]. У відповідь Брентлі Старр[en] з Північного округу Техасу заборонив подавати згенеровані штучним інтелектом матеріали справ, які не були переглянуті людиною, зазначивши[34][35]:

Платформи [генеративного штучного інтелекту] в їх нинішньому стані схильні до галюцинацій і систематичної упередженості. Галюцинуючи, вони вигадують неіснуюче — навіть посилання й цитати. Ще одне питання — надійність або упередженість. Адвокати дають присягу відкинути свої особисті забобони, упередження й переконання, щоб сумлінно дотримуватися закону і представляти своїх клієнтів, але генеративний штучний інтелект є продуктом програмування, розробленого людьми, які такої присяги не давали. А отже, ці системи не мають жодних зобов'язань перед клієнтом, верховенством права, законами і Конституцією Сполучених Штатів (і, як зазначалося вище, перед істиною). Не зв'язані жодним почуттям обов'язку, честі й справедливості, такі програми діють відповідно до комп'ютерного коду, а не переконань, на основі програмування, а не принципів.

23 червня 2023 року суддя Пітер Кевін Кастель[en] закрив справу Mata проти авіакомпанії Avianca і виписав штраф за несумлінну поведінку в розмірі 5000 доларів США Шварцу та іншому адвокатові, який продовжував відстоювати вигадані прецеденти, незважаючи на свої попередні заяви. Кастель вказав на численні помилки й невідповідності в резюме висновків, назвавши одну з процитованих думок «тарабарщиною», яка «межує з безглуздям»[36].

У червні 2023 року Марк Волтерс, активіст руху за право володіти зброєю і радіоведучий, подав до суду штату Джорджія позов проти компанії OpenAI після того, як ChatGPT охарактеризував юридичну скаргу[en] у такий спосіб, що вона стала виглядати як наклепництво на Волтерса. Скарга, про яку йдеться, була подана в травні 2023 року фондом Second Amendment Foundation[en] проти генерального прокурора Вашингтона Роберта Фергюсона[en] і звинувачувала того в порушенні свободи слова, тоді як у її резюме, згенерованому ChatGPT, не містилося нічого подібного, а натомість стверджувалося, що Уолтерса звинувачують у розтраті коштів і шахрайстві під час перебування на посаді у фонді Second Amendment Foundation, яку він у реальному житті ніколи не обіймав. За словами юридичного експерта з питань штучного інтелекту Євгена Волоха, якщо суд не встановить, що компанія OpenAI «матеріально сприяла» публікації наклепницького контенту, вона зможе захиститися від цього позову Статтею 230[en][37].

Через притаманні їм галюцинації моделі штучного інтелекту часом породжують проблеми у світі академічних і наукових досліджень. Зокрема, неодноразово зазначалося, що такі моделі, як ChatGPT, часто посилаються на джерела інформації, які або не відповідають дійсності, або взагалі не існують. Дослідження, проведене в журналі Cureus[en], виявило, що зі 178 джерел, на які посилається ChatGPT, 69 мають неправильний або неіснуючий ідентифікатор DOI, а ще 28 не мали відомого DOI або їх не вдавалося знайти за допомогою пошуку в Google[38].

Інший подібний випадок задокументував Джером Годдард[en] з Університету штату Міссісіпі[en]. Під час експерименту чатбот ChatGPT надав сумнівну інформацію про кліщів. Не будучи впевненими в достовірності відповіді, експериментатори поцікавилися звідки була отримана ця інформація. Виявилося, що галюцинацією був не тільки ідентифікатор DOI, а й імена авторів. З деякими авторами зв'язалися, і вони підтвердили, що не знали про існування цих статей[39]. Годдард висловив думку, що ці мовні моделі не готові для академічних досліджень, і що до їх використання слід підходити обережно:

…за нинішнього стану розвитку [ChatGPT] лікарям та біомедикам НЕ МОЖНА звертатися до ChatGPT за джерелами, посиланнями чи цитатами на певну тему, а якщо вони це роблять, вони мусять ретельно перевіряти точність усіх таких посилань"[39].

ChatGPT не тільки надає посилання на неправильні або неіснуючі довідкові матеріали, а й перекручує зміст існуючих. Дослідження, у рамках якого було проаналізовано загалом 115 посилань, наданих ChatGPT, задокументувало, що 47 % з них були фіктивними. Ще в 46 % цитувалися реальні джерела, але «витягнута» з них інформація була неправильною. Лише решта 7 % джерел були процитовані правильно і містили точну інформацію. Крім того, було помічено, що ChatGPT наполягає на правдивості наданої ним неправдивої інформаці: якщо вказати йому на помилку, іноді він намагається виправити себе, але найчастіше стверджує, що надана відповідь є правильною, і надає ще більше оманливої інформації[40]. Ці статті-галюцинації, створені мовними моделями, також породжують проблеми, оскільки важко сказати, ким була створена стаття — людиною чи штучним інтелектом. Щоб продемонструвати це, група дослідників з Північно-Західного університету Чикаго створила 50 авторефератів на основі існуючих звітів і проаналізувала їхню оригінальність. Детектори плагіату дали згенерованим статтям оцінку оригінальності 100 % — це означає, що подана інформація є повністю оригінальною. Інше програмне забезпечення, призначене для виявлення тексту, згенерованого ШІ, змогло правильно ідентифікувати ці статті з точністю до 66 %. Вчені-дослідники мали схожий показник людської помилки й ідентифікували ці анотації на рівні 68 %[41]. На основі цієї інформації автори дослідження зробили висновок, що

…етичні та прийнятні межі використання ChatGPT у науковому письмі залишаються незрозумілими, хоча деякі видавці починають розробляти відповідну політику[42].

Через здатність ШІ непомітно фабрикувати неіснуючі дослідження використання ШІ в науковій сфері ускладнить визначення оригінальності досліджень і вимагатиме нових методів, що регулюватимуть його використання в майбутньому, оскільки ці галюцинації часто залишаються невиявленими. Висока ймовірність генерування заздалегідь хибної інформації і посилань на неіснуючі матеріали потребує реакції наукового суспільства — наприклад, введення обмежень щодо цих мовних моделей. Існує думка, що ці події більше схожі не на галюцинації, а на вигадки й фальсифікації, і що використання цих мовних моделей становить ризик для цілісності галузі в цілому[43].

Статистик Гері Сміт (Gary N. Smith) з інтернет-видання Salon.com[en] стверджує, що великі мовні моделі «не розуміють, що означають слова», тому використовувати термін «галюцинація» некоректно, адже він необґрунтовано антропоморфізує машину[44]. Журналіст Бендж Едвардс (Benj Edwards) з інтернет-видання Ars Technica пише, що термін «галюцинація» є суперечливим, але тут необхідна певна форма метафори; Едвардс пропонує використовувати термін «конфабуляцію» — як аналогію для процесів, які передбачають «творче заповнення прогалин»[45].

Для терміна «галюцинація» в контексті великих мовних моделей вживають такі визначення й характеристики:

- «схильність вигадувати факти в моменти невизначеності» (OpenAI, травень 2023 р.)[46].

- «логічні помилки моделі» (OpenAI, травень 2023 року)[46]

- «повністю вигадана інформація, подана так, неначе це факт» (CNBC, травень 2023 року)[46].

- «вигадування інформації» (The Verge, лютий 2023 року)[47].

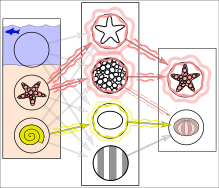

Поняття «галюцинація» застосовується не тільки у сфері обробки природної мови. Галюцинацією можна назвати будь-яку впевнену відповідь будь-якого ШІ, яка не обґрунтована навчальними даними[5]. У 2018 році журнал Wired зазначав, що, попри відсутність зафіксованих атак «у звичайних умовах» (тобто коли чатботами користуються звичайні користувачі, а не дослідники, які цілеспрямовано «атакують»[en] ШІ з метою перевірити його роботу), «мало хто сперечається», що в таких сферах, як-от споживчі гаджети або автоматизоване керування транспортними засобами, зловмисні атаки, які супроводжуються ШІ-галюцинаціями, здатні призвести до катастрофічних наслідків. Приклади таких атак: знак «Стоп», невидимий для комп'ютерного зору; короткий аудіозапис, розроблений так, щоб звучати нешкідливо для людей, але програмне забезпечення розшифрувало його як «evil dot com»[48]; і зображення двох чоловіків на лижах, яке Google Cloud Vision ідентифікував як «собаку» з ймовірністю 91 %[49].

Явище галюцинацій досі зрозуміле не до кінця[5], тому досі тривають дослідження, які намагаються подолати це явище[51]. Зокрема, було показано, що мовні моделі не лише викликають галюцинації, а й посилюють їх — навіть ті, які спеціально розроблені для пом'якшення цієї проблеми[52]. Дослідники запропонували низку заходів для пом'якшення наслідків — зокрема, змусити різних чатботів дискутувати один з одним, поки вони не досягнуть консенсусу щодо відповіді[53]. Ще один підхід — активно перевіряти правильність, що відповідає низькодостовірній генерації моделі, використовуючи результати вебпошуку[54]. Nvidia Guardrails, запущений у 2023 році, може бути налаштований на блокування відповідей LLM, які не пройшли перевірку фактів із боку іншої LLM[55].

- Безпека штучного інтелекту

- Генеративний штучний інтелект

- Гіперреальність

- Етика штучного інтелекту

- Ефект штучного інтелекту

- Ефект дезінформації

- Конструювання підказок

- Конфабуляція

- Моделювання свідомості

- Програмна модель переконань, бажань та намірів

- Самосвідомість

- Тест Тюрінга

- Філософський зомбі

- ↑ Крамаренко, Олеся (31 березня 2023). Що таке ШІ-галюцинація та як її виявити звичайному користувачеві. PaySpace Magazine (укр.). Процитовано 26 листопада 2023.

- ↑ Галюцинації ШІ: чому чатботи зі штучним інтелектом брешуть та фабрикують факти. UA.NEWS (ua) . 31 травня 2023. Процитовано 26 листопада 2023.

- ↑ Definition of HALLUCINATION. www.merriam-webster.com (англ.). 26 листопада 2023. Процитовано 26 листопада 2023.

- ↑ Maynez, Joshua; Narayan, Shashi; Bohnet, Bernd; McDonald, Ryan (2020-07). Jurafsky, Dan (ред.). On Faithfulness and Factuality in Abstractive Summarization. Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. Association for Computational Linguistics. с. 1906—1919. doi:10.18653/v1/2020.acl-main.173. Процитовано 26 листопада 2023.

- ↑ а б в г д Ji, Ziwei; Lee, Nayeon; Frieske, Rita; Yu, Tiezheng; Su, Dan; Xu, Yan; Ishii, Etsuko; Bang, Yejin; Dai, Wenliang (31 грудня 2023). Survey of Hallucination in Natural Language Generation. ACM Computing Surveys. Т. 55, № 12. с. 1—38. doi:10.1145/3571730. ISSN 0360-0300. Процитовано 26 листопада 2023.

- ↑ https://www.fastcompany.com/90819887/how-to-trick-openai-chat-gpt

- ↑ Ji, Ziwei; Lee, Nayeon; Frieske, Rita; Yu, Tiezheng; Su, Dan; Xu, Yan; Ishii, Etsuko; Bang, Yejin; Dai, Wenliang (31 грудня 2023). Survey of Hallucination in Natural Language Generation. ACM Computing Surveys. Т. 55, № 12. с. 1—38. doi:10.1145/3571730. ISSN 0360-0300. Процитовано 26 листопада 2023.

- ↑ Edwards, Benj (6 квітня 2023). Why ChatGPT and Bing Chat are so good at making things up. Ars Technica (амер.). Процитовано 26 листопада 2023.

- ↑ https://arxiv.org/abs/2301.12867

- ↑ Seife, Charles (13 грудня 2022). The Alarming Deceptions at the Heart of an Astounding New Chatbot. Slate (амер.). ISSN 1091-2339. Процитовано 26 листопада 2023.

- ↑ а б в Leswing, Kif (14 лютого 2023). Microsoft's Bing A.I. made several factual errors in last week's launch demo. CNBC (англ.). Процитовано 26 листопада 2023.

- ↑ Metz, Cade (6 листопада 2023). Chatbots May ‘Hallucinate’ More Often Than Many Realize. The New York Times (амер.). ISSN 0362-4331. Процитовано 26 листопада 2023.

- ↑ Matsakis, Louise. Artificial Intelligence May Not 'Hallucinate' After All. Wired (амер.). ISSN 1059-1028. Процитовано 26 листопада 2023.

- ↑ а б Gilmer, Justin; Hendrycks, Dan (6 серпня 2019). A Discussion of 'Adversarial Examples Are Not Bugs, They Are Features': Adversarial Example Researchers Need to Expand What is Meant by 'Robustness'. Distill (англ.). Т. 4, № 8. с. e00019.1. doi:10.23915/distill.00019.1. ISSN 2476-0757. Процитовано 26 листопада 2023.

- ↑ https://arxiv.org/abs/2303.08774

- ↑ Hanneke, Steve; Kalai, Adam Tauman; Kamath, Gautam; Tzamos, Christos (2018). Actively Avoiding Nonsense in Generative Models. Т. 75. Proceedings of Machine Learning Research (PMLR). с. 209—227.

- ↑ Metz, Cade (10 грудня 2022). The New Chatbots Could Change the World. Can You Trust Them?. The New York Times. Процитовано 30 грудня 2022.

- ↑ Tung, Liam (8 серпня 2022). Meta warns its new chatbot may forget that it's a bot. ZDNet (англ.). Red Ventures. Процитовано 30 грудня 2022.

- ↑ Edwards, Benj (18 листопада 2022). New Meta AI demo writes racist and inaccurate scientific literature, gets pulled. Ars Technica (амер.). Процитовано 30 грудня 2022.

- ↑ Michael Black [@Michael_J_Black] (17 листопада 2022). I asked #Galactica about some things I know about and I'm troubled. In all cases, it was wrong or biased but sounded right and authoritative (Твіт). Процитовано 30 грудня 2022 — через Твіттер.

- ↑ Bowman, Emma (19 грудня 2022). A new AI chatbot might do your homework for you. But it's still not an A+ student. NPR (англ.). Процитовано 29 грудня 2022.

- ↑ Pitt, Sofia (15 грудня 2022). Google vs. ChatGPT: Here's what happened when I swapped services for a day. CNBC (англ.). Процитовано 30 грудня 2022.

- ↑ Huizinga, Raechel (30 грудня 2022). We asked an AI questions about New Brunswick. Some of the answers may surprise you. CBC.ca. Процитовано 30 грудня 2022.

- ↑ Zastrow, Mark (30 грудня 2022). We Asked ChatGPT Your Questions About Astronomy. It Didn't Go so Well. Discover (англ.). Kalmbach Publishing Co. Процитовано 31 грудня 2022.

- ↑ Lin, Connie (5 грудня 2022). How to easily trick OpenAI's genius new ChatGPT. Fast Company. Процитовано 6 січня 2023.

- ↑ Edwards, Benj (1 грудня 2022). OpenAI invites everyone to test ChatGPT, a new AI-powered chatbot—with amusing results. Ars Technica (амер.). Процитовано 29 грудня 2022.

- ↑ Michael Nielsen [@michael_nielsen] (1 грудня 2022). OpenAI's new chatbot is amazing. It hallucinates some very interesting things (Твіт). Процитовано 29 грудня 2022 — через Твіттер.

- ↑ Mollick, Ethan (14 грудня 2022). ChatGPT Is a Tipping Point for AI. Harvard Business Review. Процитовано 29 грудня 2022.

- ↑ Ethan Mollick [@emollick] (2 грудня 2022). One of the big subtle problems in the new "creative AIs" is that they can seem completely certain, and getting them to switch from sane to hallucinatory is a difference of a couple words (Твіт). Процитовано 29 грудня 2022 — через Твіттер.

- ↑ Kantrowitz, Alex (2 грудня 2022). Finally, an A.I. Chatbot That Reliably Passes "the Nazi Test". Slate (англ.). Процитовано 29 грудня 2022.

- ↑ Marcus, Gary (2 грудня 2022). How come GPT can seem so brilliant one minute and so breathtakingly dumb the next?. The Road to AI We Can Trust (англ.). Substack. Процитовано 29 грудня 2022.

- ↑ Google cautions against 'hallucinating' chatbots, report says. Reuters (англ.). 11 лютого 2023. Процитовано 16 лютого 2023.

- ↑ Maruf, Ramishah (27 травня 2023). Lawyer apologizes for fake court citations from ChatGPT | CNN Business. CNN (англ.).

- ↑ Brodkin, Jon (31 травня 2023). Federal judge: No AI in my courtroom unless a human verifies its accuracy. Ars Technica (амер.).

- ↑ Judge Brantley Starr | Northern District of Texas | United States District Court. www.txnd.uscourts.gov. Процитовано 26 червня 2023.

- ↑ Brodkin, Jon (23 червня 2023). Lawyers have real bad day in court after citing fake cases made up by ChatGPT. Ars Technica (амер.).

- ↑ Belanger, Ashley (9 червня 2023). OpenAI faces defamation suit after ChatGPT completely fabricated another lawsuit. Ars Technica (амер.).

- ↑ Athaluri, Sai Anirudh; Manthena, Sandeep Varma; Kesapragada, V S R Krishna Manoj; Yarlagadda, Vineel; Dave, Tirth; Duddumpudi, Rama Tulasi Siri (11 квітня 2023). Exploring the Boundaries of Reality: Investigating the Phenomenon of Artificial Intelligence Hallucination in Scientific Writing Through ChatGPT References. Cureus (англ.). 15 (4): e37432. doi:10.7759/cureus.37432. ISSN 2168-8184. PMC 10173677. PMID 37182055.

{{cite journal}}: Обслуговування CS1: Сторінки із непозначеним DOI з безкоштовним доступом (посилання) - ↑ а б Goddard, Jerome (25 червня 2023). Hallucinations in ChatGPT: A Cautionary Tale for Biomedical Researchers. The American Journal of Medicine. 136 (11): 1059—1060. doi:10.1016/j.amjmed.2023.06.012. ISSN 0002-9343.

- ↑ Bhattacharyya, Mehul; Miller, Valerie M.; Bhattacharyya, Debjani; Miller, Larry E.; Bhattacharyya, Mehul; Miller, Valerie; Bhattacharyya, Debjani; Miller, Larry E. (19 травня 2023). High Rates of Fabricated and Inaccurate References in ChatGPT-Generated Medical Content. Cureus (англ.). 15 (5): e39238. doi:10.7759/cureus.39238. ISSN 2168-8184. PMC 10277170. PMID 37337480.

{{cite journal}}: Обслуговування CS1: Сторінки із непозначеним DOI з безкоштовним доступом (посилання) - ↑ Else, Holly (12 січня 2023). Abstracts written by ChatGPT fool scientists. Nature (англ.). 613 (7944): 423. doi:10.1038/d41586-023-00056-7.

- ↑ Gao, Catherine A.; Howard, Frederick M.; Markov, Nikolay S.; Dyer, Emma C.; Ramesh, Siddhi; Luo, Yuan; Pearson, Alexander T. (26 квітня 2023). Comparing scientific abstracts generated by ChatGPT to real abstracts with detectors and blinded human reviewers. npj Digital Medicine (англ.). 6 (1): 75. doi:10.1038/s41746-023-00819-6. ISSN 2398-6352. PMC 10133283. PMID 37100871.

- ↑ Emsley, Robin (19 серпня 2023). ChatGPT: these are not hallucinations – they're fabrications and falsifications. Schizophrenia (англ.). 9 (1): 52. doi:10.1038/s41537-023-00379-4. ISSN 2754-6993. PMC 10439949. PMID 37598184.

- ↑ An AI that can "write" is feeding delusions about how smart artificial intelligence really is. Salon (англ.). 2 січня 2023. Процитовано 11 червня 2023.

- ↑ Edwards, Benj (6 квітня 2023). Why ChatGPT and Bing Chat are so good at making things up. Ars Technica (амер.). Процитовано 11 червня 2023.

- ↑ а б в Field, Hayden (31 травня 2023). OpenAI is pursuing a new way to fight A.I. 'hallucinations'. CNBC (англ.). Процитовано 11 червня 2023.

- ↑ Vincent, James (8 лютого 2023). Google's AI chatbot Bard makes factual error in first demo. The Verge. Процитовано 11 червня 2023.

- ↑ Audio Adversarial Examples. nicholas.carlini.com. Процитовано 15 грудня 2023.

- ↑ Simonite, Tom (9 березня 2018). AI Has a Hallucination Problem That's Proving Tough to Fix. Wired. Condé Nast. Процитовано 29 грудня 2022.

- ↑ Ferrie, C., & Kaiser, S. (2019). Neural Networks for Babies. Sourcebooks. ISBN 978-1492671206.

- ↑ Nie, Feng; Yao, Jin-Ge; Wang, Jinpeng; Pan, Rong; Lin, Chin-Yew (July 2019). A Simple Recipe towards Reducing Hallucination in Neural Surface Realisation (PDF). Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Association for Computational Linguistics: 2673—2679. doi:10.18653/v1/P19-1256. S2CID 196183567. Процитовано 15 січня 2023.

- ↑ Dziri, Nouha; Milton, Sivan; Yu, Mo; Zaiane, Osmar; Reddy, Siva (July 2022). On the Origin of Hallucinations in Conversational Models: Is it the Datasets or the Models? (PDF). Proceedings of the 2022 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Association for Computational Linguistics. с. 5271—5285. doi:10.18653/v1/2022.naacl-main.387. S2CID 250242329. Процитовано 15 січня 2023.

- ↑ Vynck, Gerrit De (30 травня 2023). ChatGPT 'hallucinates.' Some researchers worry it isn't fixable. Washington Post. Процитовано 31 травня 2023.

- ↑ Varshney, Neeraj (2023). A Stitch in Time Saves Nine: Detecting and Mitigating Hallucinations of LLMs by Validating Low-Confidence Generation. arXiv:2307.03987 [cs.CL].

- ↑ Leswing, Kif (25 квітня 2023). Nvidia has a new way to prevent A.I. chatbots from 'hallucinating' wrong facts. CNBC (англ.). Процитовано 15 червня 2023.