Архівування вебсайтів

Архівува́ння вебса́йтів (вебархівува́ння, англ. web archiving) — процес збирання та «дублювання» вебсторінок та цілих сайтів з метою збереження інформації та доступу до неї у майбутньому, якщо джерело виявиться недоступним. Передумовами розвитку вебархівування стали проблеми вимирання посилань і потенційний наступ цифрових темних століть. 1996 року створено «Архів Інтернету» — першу некомерційну організацію, яка поставила собі за мету створити «знімки» всіх сторінок в інтернеті. 2001 року «Архів» запустив сервіс із архівування сайтів Wayback Machine, через який станом на 2021 рік було збережено понад 600 млрд вебсторінок.

Від початку 2000-их років практики збереження вебсайтів активно впроваджують у багатьох країнах, зокрема й на державному рівні. При цьому діють майданчики для розробки стандартів та загальних практик у сфері вебархівування, наприклад, Міжнародний семінар архівування інтернету (IWAW) (від 2001-го) та Міжнародний консорціум збереження інтернету[en] (від 2003-го).

Найчастіше інформацію зі статичних сайтів збирають за допомогою пошукових роботів (наприклад, Heritrix[en] , Webrecorder, HTTrack), які надсилають HTTP-запити на вебсервери і «захоплюють» передаваний контент зі всіма гіперпосиланнями з просканованих вебсторінок. Натомість, скрипти, шаблони та контент динамічних сайтів зберігаються на вебсерверах як окремі ресурси, тому архівувати такі портали значно складніше. Процес має два основні етапи — збереження файлових даних зі структури каталогів вебсайту та подальше архівування інформації з бази даних.

Визначення[ред. | ред. код]

Терміни вебархівування та вебзбереження (англ. web preservation) часто використовують як взаємозамінні, проте між ними існує важлива відмінність: перший визначає весь процес збереження інтернет-ресурсу, а другий лише один з етапів[1]. Міжнародний консорціум збереження інтернету[en] визначає вебархівування як:

| [...] процес збирання частин всесвітньої павутини, збереження колекцій в архівному форматі та подальше обслуговування архівів з метою надання до них доступу та використання. |

Передумови[ред. | ред. код]

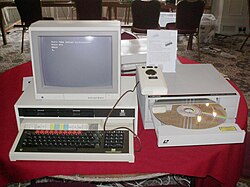

Від початку 1990-их років створення, зберігання та поширення інформації відбувається переважно в цифровому середовищі. Вже до середини 1990-их років почали старіти раніше популярні носії інформації, такі як магнітні стрічки, дискети, zip-накопичувачі та компакт-диски, а доступ до старих файлових форматів ускладнився[2][3]. Стали зникати багато великих баз даних, які не було скопійовано на інші носії чи продубльовано на папері[4]. Так, усі дані великомасштабного проєкту BBC Domesday Project, проведеного в 1980-ті роки за участю понад мільйон осіб, було записано на кілька дисків, які до початку 2000-их років або пошкодились, або були втрачені[5][6].

Повсюдна втрата даних призвела до того, що окремі дослідники почали обговорювати потенційне настання «цифрових темних століть» (англ. digital dark age) — періоду, що характеризується практично повною відсутністю писемних свідчень[7][8]. Деякі дослідники називають XXI століття «інформаційною чорною дірою» через побоювання, що програмне забезпечення та комп'ютери майбутнього не зможуть відтворити створених раніше даних[9]. 2003 року ЮНЕСКО випустила «Хартію про збереження цифрової спадщини»[10], яка визначає важливість резервації цифрових даних, втрата яких може призвести до «збіднення» людської спадщини[11][12]. 2015 року із заявою про те, що людство рухається до «цифрових темних століть», виступив американський учений і віце-президент Google Вінтон Серф[13][14][15][16].

Іншою передумовою для розвитку вебархівування є вимирання посилань — ситуація, коли сторінки стають недоступними за попередніми URL або змінюється їх зміст[17][18][19]. Аналіз, який провели 2017 року португальські дослідники, показав, що близько 80 % інтернет-сторінок недоступні в початковому вигляді вже через рік після опублікування, при цьому 13 % посилань у наукових статтях зникали в середньому через 27 місяців[11]. 2021 року вчені юридичного факультету Гарвардського університету разом із журналістами The New York Times (NYT) проаналізували життєздатність посилань у більш ніж 550 тисячах випущених NYT онлайн-публікаціях у період за 2000—2017 роки — близько чверті використаних URL-адрес «вимерли»[20][21][22][23]. Середня тривалість життя вебсторінки становить 44-100 днів, а на сайтах новин і в соціальних мережах інформація може зникати ще швидше[24][25].

Інформація в інтернеті може зникати і з інших причин. Так, 2015 року Державний департамент США і Агентство США з міжнародного розвитку ініціювали видалення матеріалів про війну в Афганістані з метою вберегти тих, хто співпрацював з американською владою, від переслідування з боку талібів[26]. Інший приклад — висунуті в грудні 2021 року вимоги Роскомнадзору видалити з низки російських ЗМІ матеріали про розслідування видання «Проєкт»[en], яке раніше визнано небажаною організацією[27][28].

Відбір джерел[ред. | ред. код]

Починаючи від 1980-их років, окремі архіви та бібліотеки почали зберігати електронні ресурси з метою задокументувати хроніку актуальних подій. Однак відправною точкою вебархівування вважають створення 1996 року «Архіву Інтернету» — некомерційної організації, що поставила амбітну мету зберегти всі веб-сторінки всього інтернету, яких на той момент було відносно небагато[29][1]. Наприкінці 1990-их — на початку 2000-их років уряди багатьох розвинених країн стали впроваджувати практики вебархівування, поклавши відповідальність за їх ведення на національні бібліотеки, які мають необхідний досвід та засоби для архівування[30][11][12]. До 2000 року національні вебархіви з'явилися в багатьох країнах, зокрема, у Великій Британії, Новій Зеландії, США та Чехії[31][32][19].

Відтоді кількість проєктів із вебархівування зростає[11]. 2011 року у світі діяло 42 програми, більшість із яких збирали регіональні вебджерела[12]. Дослідження 2020 року показало експонентне зростання кількості установ, що мають власні репозиторії, роботу яких підтримують найняті фахівці та спеціалізоване обладнання. Більшість таких репозиторіїв поповнюється за принципом самоархівування — автори самостійно розміщують там свої матеріали[33]. На 2019 рік вебархіви на національному рівні запроваджено практично у всіх країнах Європейського Союзу, найчастіше — у рамках роботи національних бібліотек[31][34].

Організації[ред. | ред. код]

«Архів Інтернету»[ред. | ред. код]

Першою найбільшою ініціативою з веб-архівування став «Архів Інтернету» — некомерційна організація, створена 1996 року для збереження всіх розміщених в інтернеті матеріалів[19]. Творцем став американський програміст Брюстер Кейл, який одночасно запустив «Архів» і комерційну систему вебархівування Alexa Internet . 1997 року він розробив браузерний плагін, через який Alexa Internet автоматично визначала і зберігала в «Архів» «цінні» веб-сторінки, ранжуючи їх за кількістю відвідувань, перехресних посилань і «клацань»[35]. Від 1998 року кількість сторінок для архівування зростала вдвічі кожні 3-6 місяців[36].

24 жовтня 2001 року «Архів Інтернету» запустив сервіс Wayback Machine, через який користувачі могли отримати доступ до більш ніж 10 млрд заархівованих веб-сторінок. Тоді дані зберігалися на серверах Hewlett Packard і uslab.com і керувалися через операційні системи FreeBSD і Linux[36].

На 2021 рік колекція «Архіву Інтернету» містила багато підколекцій архівованих веб-сайтів, оцифрованих книг, аудіо та відео файлів, ігор, програмного забезпечення[37]; при цьому кількість заархівованих вебсторінок склала понад 622 млрд[38].

WebCite[ред. | ред. код]

Сервіс WebCite, запущений 2003 року, став першим інструментом вебархівування, що дозволяє користувачам зберігати вебсайти за запитом. Він швидко набрав популярності і вже на 2005 рік близько 200 журналів просили авторів перед надсиланням рукописів архівувати використовувані вебсторінки через WebCite[39]. Сервіс не використовує пошукових роботів для «захоплення» сторінок, архівування відбувається безпосередньо за запитом користувача[39].

2013 року WebCite був під загрозою закриття через брак фінансування, проте завдяки публічній кампанії зі збору коштів творця Гюнтера Айзенбаха портал продовжував свою роботу ще шість років. Від 2019 року він став доступним лише для читання та припинив приймати запити на архівування[40][41].

Archive.today[ред. | ред. код]

Сервіс archive.today (спосатку - archive.is) запустила 2012 року однойменна некомерційна організація[42]. Проєкт фінансують приватні спонсори. Так само, як і WebCite, archive.today зберігає вебсторінки за запитами користувачів[43][44], розміщуючи у відкритому доступі робочу копію вебсторінки та знімок екрана зі статичною візуалізацією сторінки у форматі PNG[45]. Розмір заархівованої сторінки з усіма зображеннями не може перевищувати 50 МБ[42].

Творці archive.today також запустили розширення для браузера Mozilla Firefox, яке автоматично зберігає і викладає у спільний доступ копію кожної вебсторінки, яку користувач додав у закладки[45][46].

Національні бібліотеки[ред. | ред. код]

У більшості розвинених країн діють закони про обов'язковий примірник, які покладають юридичну відповідальність на національні бібліотеки зберігати один примірник кожного опублікованого в цій країні друкованого видання. З розвитком засобів електронної комунікації дію закону поширили і на веб-сайти[1][47]. Так, згідно із Законом про публічні записи 1967 року[en], Національні архіви Великої Британії[en] та Ірландії[en] зобов'язані зберігати всі важливі постанови уряду Великої Британії. Оскільки чиновники все частіше публікують свої звіти в інтернеті, вебархів щомісяця відвідують понад 100 млн. користувачів (станом на 2013 рік)[24].

1996 року Національна бібліотека Швеції ініціювала проект Kulturar, у рамках якого здійснювалося великомасштабне збереження всієї шведської мережі доменів[48]. На початку 2005 року зібрано понад 350 000 вебсайтів або близько 10 терабайт даних, завдяки чому вебархів став найбільшим на той момент у світі[19]. 1997 року створено спільну ініціативу національних бібліотек Данії, Фінляндії, Ісландії, Норвегії, Швеції під назвою Nordic Web Archive (NWA). В рамках NWA велася розробка інструментів та обговорювалися методи вебархівування для скандинавських країн. 2004 року NWA випустив програмний пакунок для доступу до архівованих вебдокументів, який згодом ліг в основу IIPC[en] Toolkit[19][49]. Цього ж року Національна бібліотека Австралії запустила Pandora[en] — проєкт збереження електронних ресурсів Австралії[50][51][19]. 2019 року колекція Pandora увійшла до Australian Web Archive[en] — одного з найбільших національних вебархівів у світі[52].

Колаборації[ред. | ред. код]

2001 року створено Міжнародний семінар архівування Інтернету (IWAW)[53] — майданчик для обміну дослідженнями та досвідом у сфері вебархівування[54], а 2003-го з ініціативи «Архіву Інтернету» засновано Міжнародний консорціум збереження Інтернету[en] (IIPC), у рамках якого розробляються стандарти та засоби вебархівування[36][55]. Крім «Архіву», до складу IIPC увійшли національні бібліотеки Франції, Австралії, Канади, Данії, Фінляндії, Ісландії, Італії, Норвегії, Швеції, Великої Британії, США. 2008 року в рамках IIPC розроблено Web ARChive[en] або WARC — формат файлів для архівування вебресурсів[12]. На 2021 рік у IIPC перебувало більше 50 членів[56].

Організації часто співпрацюють для створення об'єднаних веб-архівів. Так, від 2004 до 2018 року діяв Європейський цифровий архів (згодом перейменований на Internet Memory Foundation[en]), який збирає електронні документи в країнах Європейського Союзу[57][19][12]. Серед інших, до його складу входили Національні архіви Великої Британії, Товариство імені Макса Планка, Берлінський технічний університет, Саутгемптонський університет, Institut Mines-Télécom[en]. На початку 2000-их років департаменти китаєзнавства Гейдельберзького та Лейденського університетів спільно запустили вебархів DACHS, що містить електронні матеріали з синології[58][19]. Консорціуми NWA та UKWAC проводили програми спільного збору даних у партнерстві з іншими організаціями[59][19][60]. Наприкінці 1990-их років Європейська комісія профінансувала створення Networked European Deposit Library (NEDLIB) — проекту зі збирання, описування, зберігання та відкриття доступу до збережених європейських вебсайтів[61]. Випущений 2000 року NEDLIB Harvester став одним із перших пошукових роботів, спеціально створених для архівування даних. Згодом його використовували в низці проєктів, зокрема для збору даних із нідерландських, естонських та ісландських вебдоменів[19][62].

У липні 2011 року Національний архів Великої Британії спільно з Internet Memory Foundation запустили пілотний проєкт з вебархівування цифрових даних для місцевих органів влади. Проєкт діяв у семи архівах муніципальних утворень, що охоплюють понад 20 місцевих органів влади. Персонал пройшов безкоштовне навчання зі створення кураторського вебархіву для своєї галузі[63].

Університети розвинених країн також беруть участь у розвитку вебархівування. Наприклад, у Мічиганському, Індіанському, Каліфорнійському, Іллінойському та інших університетах пропонують курси з навчання архівуванню цифрових матеріалів[53], а кілька установ створили для дослідних цілей власні вебархіви — Stanford WebBase Archive (Стенфордський університет), Socio-Sense (Токійський університет), вебінформаційний центр (Пекінський університет) [12].

Відбір джерел[ред. | ред. код]

Перед початком архівування кожна організація визначає критерії відбору джерел. Таких критеріїв може бути один або декілька, залежно від розміру та цілей організації[19][64]. Деякі веб-архіви, такі як «Архів Інтернету», мають на меті зібрати всі можливі вебсторінки — такий підхід називають неселективним або широким скануванням. В його основі лежить принцип взаємопов'язаності всесвітнього павутиння, згідно з яким по-справжньому «зберегти» якусь тему можна лише зібравши всі наявні вебсторінки, оскільки вони пов'язані між собою. Крім цього, відбір вебсайтів є дорогим і трудомістким процесом, який також може призвести до суб'єктивної вибірки[19]. Однак підхід «Архіву» вважають нездійсненним на практиці — збереження всіх сторінок неможливе через обмеження, пов'язані з авторським правом, і навіть «Архів Інтернету» зберігає лише доступні громадськості матеріали[65].

Альтернативою неселективного підходу до відбору є вибірковий підхід або вибір ресурсів, ґрунтуючись на їх відповідності певним критеріям — домену (наприклад, .gov або .edu), темі, події, типу мультимедіа або жанру[19]. Вибірковий підхід часто поєднують із практиками широкого сканування, наприклад, якщо організація архівує всі портали з певним доменним ім'ям. Так, Національна бібліотека Швеції від 1996 року збирає всі вебсайтів з доменом «.se»[19][66], а Національна бібліотека Великої Британії архівує веб-сайти з доменами «.gov.uk», «.org.uk» та «.co.uk». Бібліотека НАСА Центру космічних польотів Ґоддарда зберігає всі вебсторінки з доменним ім'ям Центру[19]. Головною перевагою вибіркового архівування є те, що такий підхід дозволяє створити більш керовані за розміром колекції пов'язаних ресурсів[19].

Вибірковий підхід застосовують для створення тематичних колекцій. Наприклад, DACHS збирає соціальні та культурні ресурси зі синології, а Бібліотека Конгресу, спільно з Архівом Інтернету, скомпілювала вебархіви про президентські вибори в США та події 11 вересня 2001 року. Британська бібліотека спеціалізується на вебсайтах, що становлять цінність для національної культури[66]. Такий підхід застосовує і проєкт Pandora Національної бібліотеки Австралії[19][53]. 2006 року «Архів Інтернету» запустив сервіс Archive It зі створення тематичних вебколекцій[67], яким часто користуються окремі організації, наприклад Національний музей жіночого мистецтва[en][68].

Деякі організації архівують ресурси, зважаючи на тип джерел. Так, бібліотека Центру космічних польотів Годдарда уникає сканування великих відеофайлів та програмних продуктів. Навпаки, інші проєкти вебархівують відео на Youtube або збирають блоги, віртуальні газети, наприклад, Національна бібліотека Франції створила окрему вебколекцію для Живих Журналів[53].

Збір даних[ред. | ред. код]

Статичні сайти[ред. | ред. код]

Що простіший і статичніший сайт, то легше його архівувати[69] — копії даних завантажуються з вебсервера у вигляді файлів, які згодом можна перетворити на інші формати[70][71][72].

Процес автоматичного збирання вебсторінок через пошукові роботи називають «скануванням» (англ. web harvesting). Роботу передають список URL-адрес, за якими він надсилає HTTP-запити на вебсервери і «захоплює» переданий контент і всі гіперпосилання з просканованих вебсторінок[72]. Потім автоматизоване ПЗ перетворює інформацію у формат WARC, і результатом є файл, який можна відтворити, наприклад, за допомогою Wayback Machine[73]. Приклади пошукових роботів — розроблений «Архівом Інтернету» 2004 року Heritrix[en][74], а також HTTrack[75] і Wget[76]. Мережа «сканерів» дозволяє організаціям зберігати копії вибраних сайтів з деякою періодичністю, наприклад, щодня або щорічно[73]. Для більш точкового архівування використовують інструменти меншого масштабу, наприклад HTTrack, який дозволяє завантажувати копії вебсайтів на локальний комп'ютер[73].

Динамічні сайти[ред. | ред. код]

Архівувати динамічні сайти значно складніше, ніж статичні, оскільки контент, скрипти та шаблони зберігаються на вебсервері як окремі ресурси. а вигляд та вміст сторінки формується залежно від браузера клієнта та налаштувань сервера. На відміну від статичних веб-сайтів, автоматичного оброблення HTTP-запиту недостатньо, оскільки з боку сервера сайт генерує контент, використовуючи базу даних[70]. Тому збереження таких ресурсів відбувається у два етапи — збереження файлових даних, що знаходяться в структурі каталогів веб-сайту, та архівування інформації бази даних[70]. Для динамічних сайтів використання пошукових роботів має обмеження[19]. До інструментів веб-архівування динамічного контенту відносять програмне забезпечення Software Independent Archiving of Relational Databases (SIARD), розроблене Швейцарським федеральним архівом, та DeepArc Національної бібліотеки Франції. SIARD автоматично аналізує та відображає структуру початкової бази даних. Потім він експортує структуру в текстовий файл, що містить визначення даних, описане з використанням SQL — міжнародного стандарту для опису реляційних баз даних. Згодом вміст експортується як звичайний текстовий файл, а метадані зберігаються як XML-документ[19].

Архівування соціальних мереж[ред. | ред. код]

Перші проєкти з архівування соціальних мереж почали з'являтися від 2008 року як систематичне широке сканування платформ. Так, Національна бібліотека Нової Зеландії[en] розпочала роботу зі створення архіву повідомлень, опублікованих у Твіттері, а Національна бібліотека Франції сканувала Facebook. Однак через великий обсяг контенту, відсутність технічних стандартів зі збору та зберігання інформації, а також постійні зміни технічних деталей роботи порталів, згодом організації почали застосовувати вибірковий підхід до вебархівування соціальних мереж та зберігати повідомлення лише про конкретні події або надзвичайні ситуації. Окремі організації, наприклад, Національна бібліотека Франції або Національна бібліотека Канади, запустили безперервне автоматизоване збирання новин та контенту соціальних мереж, щоб не упустити реакцію людей на непередбачені події. Вибірка здійснюється за заданими хештегами або ключовими словами, за певний період або на конкретній платформі[77][78].

Інструменти[ред. | ред. код]

Для збирання вебсайтів використовують різні інструменти вебархівування. Найчастіше зустрічається пошуковий робот Heritrix — доступний за ліцензією вільного програмного забезпечення вебсканер загального призначення, розроблений з урахуванням завдань вебархівування. Heritrix зберігає файли у форматі WARC і добре підходить для великомасштабних операцій сканування, однак меншою мірою захоплює динамічні сайти або сторінки в соціальних мережах. Розроблений на основі Heritrix NetarchiveSuite має додаткові функції щодо довгострокового зберігання та доступу до матеріалів[1].

Webrecorder використовує для збирання вмісту вебсайтів браузер, тим самим вирішуючи часті проблеми інших пошукових роботів — захоплення динамічного контенту, Adobe Flash, мультимедіа. Програма записує вебсторінки під час їх перегляду, тому добре підходить для вибіркового сканування. Вміст також зберігається у форматі WARC[1]. Інший пошуковий робот, Brozzler[79], використовує для збору сторінок браузер Google Chrome і пропонує ті ж переваги, що й Webrecorder, але під час сканування не потребує взаємодії з користувачем[1].

HTTrack дозволяє завантажувати копії вебсайтів на локальний комп'ютер, і згодом користувач може переглянути їх у браузері[80]. Wget та аналогічний інструмент Wpull — універсальні інструменти командного рядка, які мають вбудовані функції сканування вебсторінок, подібні до функцій HTTrack. Wpull найкраще підходить для масштабного архівування[1].

Через динамічну структуру сайтів соціальних мереж для їх архівації потрібні спеціалізовані інструменти. Зазвичай вебархівування виконується за допомогою інтерфейсів прикладного програмування (API), які надають розробники. F(b)arc — інструмент командного рядка, який можна використати для архівування даних за допомогою Facebook Graph. Twarc — інструмент та бібліотека командного рядка, які спрощують використання API-інтерфейсів Twitter. Social Feed Manager дозволяє збирати дані з Twitter, Tumblr, Flickr та Sina Weibo[1].

Найчастіше для архівування використовують формати ARC та WARC. Більшість ініціатив використовують для підтримки повнотекстового пошуку рішення на основі Lucene, зокрема, NutchWAX або Solr, а для підтримки пошуку URL та відображення заархівованого контенту — Wayback Machine[11]. Для читання та вилучення метаданих із файлів WARC використовують інструменти JWAT, node-warc, WARCAT, warcio та warctools[1].

Дозвіл[ред. | ред. код]

Чи підпорядковуватиметься організація стандарту винятків для роботів і чи запитуватиме дозвіл на архівування у власників сайту, залежить від багатьох факторів — виду контенту, масштабів вебархівування, правового середовища[53][1]. Однак навіть при зверненні по дозвіл лише близько 30—50 % власників сайтів відгукуються на прохання[81].

Як правило, урядові організації, наділені законним правом зберігати публічні записи (наприклад, Національне управління архівів та документації (США) і національні архіви Великої Британії), не потребують дозволу на сканування. Згідно зі французьким законом Про авторське право[en] від 2006 року, Національна бібліотека Франції може під час скануванні сайтів із національними доменами нехтувати robots.txt[53][1]. Інші організації, такі як «Архів Інтернету», використовують принцип відмови — дані видаляються з колекції на прохання правовласників, які можуть довести авторські права, надавши опис матеріалу, контактні дані заявника і підписану заяву[82][53][24].

Метадані[ред. | ред. код]

Вебархіви зазвичай мають ієрархічну структуру — сеанс сканування захоплює багато сайтів, кожен з яких веде на окрему вебсторінку, яка містить відео, текст та файли зображень. Для кожного з «рівнів» генеруються метадані[53][19].

Підхід до створення метаданих залежить від масштабу та ресурсів, якими володіє організація. Так, великі вебархіви часто покладаються на автоматичне створення метаданих. Деякі метадані, зокрема час збору, код стану (наприклад, помилка 404 для не знайденого або 303 для перенаправлення), розмір у байтах, URI або тип MIME (наприклад, text/ HTML) пошукові роботи захоплюють автоматично. Інформацію також можна добути з метатегів HTML-сторінок[53][19].

Для невеликих вебархівів метадані можуть створюватися вручну. Літературний архів Каліфорнійського університету в Лос-Анджелесі використовує для генерування метаданих докладні нотатки, які створює персонал у процесі збирання та аналізу веб-сторінок[53][83]. У вебархіві Національного університету Тайваню діє трирівнева ієрархічна класифікація. Метадані можуть також бути створені за допомогою користувацьких тегів, коментарів або оцінок[53][83][84].

Проблеми[ред. | ред. код]

Користувачі звертаються до вебархівів з різних причин — для досліджень, компіляції власної бази даних або перегляду старих версій окремих вебресурсів. Однак найчастіше доступ до таких колекцій ускладнений відсутністю загального пошуку в доступних базах даних і незручним інтерфейсом. Для доступу та обробки збереженої інформації часто потрібні технічні навички роботи зі спеціалізованими форматами файлів[85][60][86]. Окремі дослідники вважають, що саме з цих причин посилання на вебархіви, як і раніше, рідко зустрічаються в наукових працях, а колекції — не вивчаються[87][88].

Колекція вебархіву може виявитися неповною або упередженою через неможливість заархівувати «закриті» сайти та/або непрофесійну розробку стратегій архівування — наприклад, коли архівують лише англомовні портали великих західних країн. Попри те, що частина архівів має юридичне право нехтувати стандарт винятків для роботів, колекції інших організацій суттєво обмежені через дотримання стандарту[69][89][69].

Автоматичне вебархівування через пошукові роботи дозволяє «захопити» багато інформації[33], проте деякі інтерактивні елементи JavaScript зберегти неможливо і архівна версія втрачає функціональність[69][90].

Примітки[ред. | ред. код]

- ↑ а б в г д е ж и к л м Chambers, 2019, с. 85—111.

- ↑ Veronique Greenwood (June 2020). The digital Dark Ages (англ.). Yale Alumni Magazine. Архів оригіналу за 15 жовтня 2021. Процитовано 9 грудня 2021.

- ↑ Dan Greene (21 квітня 2021). The erosion of personal ownership (англ.). Vox. Архів оригіналу за 26 вересня 2021. Процитовано 9 грудня 2021.

- ↑ Digital Domesday Book lasts 15 years not 1000 (англ.). The Guardian. 3 березня 2002. Архів оригіналу за 20 січня 2013. Процитовано 11 грудня 2021.

- ↑ Veronique Greenwood (06-2020). The digital Dark Ages (англ.). Yale Alumni Magazine. Архів оригіналу за 15 жовтня 2021. Процитовано 27 вересня 2021.

- ↑ Lamont Wood (26 серпня 2010). Fending off the digital dark ages: The archival storage issue (англ.). ComputerWorld. Архів оригіналу за 26 січня 2021. Процитовано 11 грудня 2021.

- ↑ Giaretta, 2011.

- ↑ Panos, 2003.

- ↑ Adam Wernick (1 січня 2018). Scientists warn we may be creating a 'digital dark age' (англ.). The World. Архів оригіналу за 16 серпня 2021. Процитовано 10 грудня 2021.

- ↑ Хартия о сохранении цифрового наследия (англ.). ООН. Архів оригіналу за 23 серпня 2021. Процитовано 12 грудня 2021.

- ↑ а б в г д Costa, 2017, с. 191—205.

- ↑ а б в г д е Toyoda, 2012, с. 1441—1443.

- ↑ To avoid a digital dark age, all stakeholders must put their heads together (англ.). The Times of India. 17 вересня 2020. Архів оригіналу за 8 вересня 2021. Процитовано 27 вересня 2021.

- ↑ Lauren Maffeo (29 травня 2015). Google's Vint Cerf on how to prevent a digital dark age (англ.). The Guardian. Архів оригіналу за 19 листопада 2021. Процитовано 27 листопада 2021.

- ↑ Dave Smith (20 лютого 2015). Father of the internet: 'If we don’t move now, we risk losing all the data we’ve created in the 21st century' (англ.). Business Insider. Архів оригіналу за 19 листопада 2021. Процитовано 28 листопада 2021.

- ↑ Николай Удинцев (13 лютого 2015). Цитата дня: почему может начаться «цифровой Тёмный век» (англ.). Look at Me. Архів оригіналу за 19 листопада 2021. Процитовано 28 листопада 2021.

- ↑ Adoghe, 2013, с. 598—603.

- ↑ Perkel, 2015, с. 111—112.

- ↑ а б в г д е ж и к л м н п р с т у ф х ц ш Brown, 2006, с. 1—256.

- ↑ Rhodes, 2010, с. 581—597.

- ↑ White, 2019, с. 29—43.

- ↑ Bowers, 2021.

- ↑ Mitchell Clark (21 травня 2021). New research shows how many important links on the web get lost to time (англ.). The Verge. Архів оригіналу за 20 червня 2021. Процитовано 10 жовтня 2021.

- ↑ а б в Pennock, 2013.

- ↑ Nick Bilton (7 вересня 2011). The Lifespan of a Link (англ.). The New York Times. Архів оригіналу за 28 вересня 2021. Процитовано 10 грудня 2021.

- ↑ Matthew Gault (17 липня 2015). The US Is Removing Records of Its War in Afghanistan From the Internet (англ.). Vice. Процитовано 11 грудня 2021.

- ↑ Роскомнадзор потребовал от СМИ удалить публикации о расследованиях "Проекта", признанного нежелательной организацией (рос.). BBC. 18 грудня 2021. Архів оригіналу за 18 грудня 2021. Процитовано 20 грудня 2021.

- ↑ Тася Елфимова (18 грудня 2021). Роскомнадзор потребовал от The Village, «Медузы» и «Дождя» удалить десятки новостей по расследованиям «Проекта» (рос.). The Village. Архів оригіналу за 18 грудня 2021. Процитовано 19 грудня 2021.

- ↑ Patel, 2020, с. 1—10.

- ↑ Балацкая, 2021, с. 12—16.

- ↑ а б Pretoro, 2013, с. 63—67.

- ↑ Single Sites Web Archive - Minerva - Library of Congress Web Archive (англ.). European History Primary Sources. Архів оригіналу за 6 травня 2021. Процитовано 13 грудня 2021.

- ↑ а б Rockwell, 2020, с. 1—17.

- ↑ Mark Pesce (29 жовтня 2021). Archiving the World Wide Web (англ.). Cosmos. Архів оригіналу за 25 листопада 2021. Процитовано 11 грудня 2021.

- ↑ Kimpton, 2006.

- ↑ а б в Masanes, 1998, с. 201—212.

- ↑ Rory Carroll (26 квітня 2013). Brewster's trillions: Internet Archive strives to keep web history alive (англ.). The Guardian. Архів оригіналу за 15 грудня 2021. Процитовано 11 грудня 2021.

- ↑ Wayback Machine (англ.). Wayback Machine. Процитовано 7 червня 2021.

- ↑ а б Trudel, 2005.

- ↑ Fund WebCite (http://www.webcitation.org) (англ.). FundRz. Процитовано 18 грудня 2021.

- ↑ Archive Now (archivenow) (англ.). GitHub. Архів оригіналу за 20 грудня 2021. Процитовано 20 грудня 2021.

- ↑ а б FAQ (англ.). archive.ph. Архів оригіналу за 27 жовтня 2021. Процитовано 10 грудня 2021.

- ↑ Salman Ravoof (3 листопада 2021). How to Archive a Website: Our Mammoth Guide to Saving Your Site (англ.). Kinsta. Архів оригіналу за 5 листопада 2021. Процитовано 7 грудня 2021.

- ↑ Jason Koebler (29 жовтня 2014). Dear GamerGate: Please Stop Stealing Our Shit (англ.). Vice. Архів оригіналу за 27 листопада 2021. Процитовано 7 грудня 2021.

- ↑ а б Martin Brinkmann (22 квітня 2015). Create publicly available web page archives with Archive.is (англ.). G Hacks. Архів оригіналу за 12 квітня 2019. Процитовано 12 грудня 2021.

- ↑ Comparison of web archiving services (англ.). Web Page Archiving. Архів оригіналу за 22 вересня 2013. Процитовано 10 грудня 2021.

- ↑ Система электронного обязательного экземпляра в Великобритании (англ.). Информационно-аналитический журнал Университетская Книга. 21 вересня 2013. Архів оригіналу за 24 жовтня 2020. Процитовано 18 грудня 2021.

- ↑ The Kulturarw3 Project (англ.). Jeremy Norman's History of Information. Процитовано 10 грудня 2021.

- ↑ NWA Toolset 1.1RC10 released (англ.). NWA. Архів оригіналу за 26 квітня 2018. Процитовано 11 грудня 2021.

- ↑ History (англ.). Pandora. Архів оригіналу за 4 червня 2020. Процитовано 11 грудня 2021.

- ↑ Webb, 2000, с. 154—172.

- ↑ George Nott (11 березня 2019). National Library launches 'enormous' archive of Australia's Internet (англ.). Computer World. Архів оригіналу за 24 листопада 2021. Процитовано 10 грудня 2021.

- ↑ а б в г д е ж и к л м Niu, 2012.

- ↑ IWAW 2010 : The 10th Intl Web Archiving Workshop (англ.). WikiCfP. Архів оригіналу за 27 квітня 2021. Процитовано 15 грудня 2021.

- ↑ International Internet Preservation Consortium (англ.). International Internet Preservation Consortium. Архів оригіналу за 14 грудня 2021. Процитовано 14 грудня 2021.

- ↑ IIPC members (англ.). International Internet Preservation Consortium. Архів оригіналу за 16 грудня 2021. Процитовано 13 грудня 2021.

- ↑ European archive (англ.). Library of Congress. Процитовано 13 грудня 2021.

- ↑ About DACHS (англ.). Bereichbibliother Ostaasien. Архів оригіналу за 17 жовтня 2021. Процитовано 13 грудня 2021.

- ↑ Steve Bailey, Dave Thompson (2006). Building the UK's First Public Web Archive (англ.). D-lib Magazine. Архів оригіналу за 23 листопада 2021. Процитовано 18 грудня 2021.

- ↑ а б Dooley, 2017, с. 1—15.

- ↑ Johan Steenbakkers. Presentations (англ.). European Library Automation Group. Архів оригіналу за 29 грудня 2021. Процитовано 13 грудня 2021.

- ↑ Hakala, 2001, с. 211—216.

- ↑ Duncan Jefferies (9 березня 2012). Using web archives to preserve the past. The Guardian. Архів оригіналу за 10 червня 2021. Процитовано 11 грудня 2021.

- ↑ Alam, 2020, с. 1—251.

- ↑ Broussard, 2021, с. 276.

- ↑ а б Chambers, 2019.

- ↑ Поврозник, 2020.

- ↑ Slania, 2013, с. 112—126.

- ↑ а б в г João Miranda. Web Harvesting and Archiving (англ.). Web Ist UTL. Архів оригіналу за 29 грудня 2021. Процитовано 17 грудня 2021.

- ↑ а б в Rumianek, 2013.

- ↑ Brunelle, 2012.

- ↑ а б Pretoro, 2013.

- ↑ а б в Preserving the Web (англ.). Digital Preservation Online. Архів оригіналу за 14 вересня 2021. Процитовано 17 грудня 2021.

- ↑ Mohr, 2004, с. 1—15.

- ↑ Justin Kulesza. How to Archive a Website (англ.). Atomic Object. Архів оригіналу за 23 червня 2016. Процитовано 14 грудня 2021.

- ↑ The command I use to archive a single website (англ.). GitHub. Архів оригіналу за 23 грудня 2021. Процитовано 15 грудня 2021.

- ↑ Michel, 2021, с. 107—128.

- ↑ Редькина, 2019, с. 52.

- ↑ internetarchive/brozzler (англ.). GitHub. Архів оригіналу за 10 грудня 2021. Процитовано 16 грудня 2021.

- ↑ Путеводитель по offline-браузерам. Часть 2. IXBT.com. Архів оригіналу за 2 серпня 2019. Процитовано 17 грудня 2021.

- ↑ Legal issues (англ.). International Internet Preservation Consortium. Архів оригіналу за 16 грудня 2021. Процитовано 16 грудня 2021.

- ↑ Berčič, 2005, с. 17—24.

- ↑ а б Brown, 2006.

- ↑ Olson, 2009, с. 181—196.

- ↑ Ayala, 2021, с. 89—106.

- ↑ Brügger, 2017, с. 45—61.

- ↑ Rogers, 2019, с. 49.

- ↑ Niels, 2021, с. 145—168.

- ↑ Kalev Leetaru (7 травня 2019). Why Web Archives Need To Engage With Researchers (англ.). Forbes. Архів оригіналу за 29 грудня 2021. Процитовано 11 грудня 2021.

- ↑ Kalev Leetaru (24 лютого 2017). Are Web Archives Failing The Modern Web: Video, Social Media, Dynamic Pages and The Mobile Web. Forbes. Архів оригіналу за 29 грудня 2021. Процитовано 11 грудня 2021.

Література[ред. | ред. код]

- Adoghe A., Onasoga K., Dike D., Ajayi O. Web-Archiving: techniques, challenges, and solutions : [англ.]. — 2013. — Vol. 5, no. 3. — С. 598—603.

- Alam S. Mementomap: a web archive profiling framework for efficient memento routing : [англ.]. — 2020.

- Ayala B. When expectations meet reality: common misconceptions about web archives and challenges for scholars : [англ.] // International Journal of Digital Humanities. — 2021. — No. 2. — С. 89—106.

- Berčič B. Protection of Personal Data and Copyrighted Material on the Web: The Cases of Google and Internet Archive : [англ.] // Communications Technology Law. — 2005. — Vol. 14, no. 1. — С. 17—24. — DOI:10.1080/1360083042000325283.

- Brown A. Archiving websites a practical guide for information management professionals : [англ.]. — Facet publishing. — 2006. — 256 с. — ISBN 978-1-85604-553-7.

- Brügger N., Schroeder R. Live versus archive: Comparing a web archive to a population of web pages : [англ.]. — 2017. — С. 45—61. — DOI:10.2307/j.ctt1mtz55k.8.

- Brügger N. Digital humanities and web archives: Possible new paths for combining datasets : [англ.] // International Journal of Digital Humanities. — 2021. — No. 2. — С. 145—168.

- Broussard M. Archiving Data Journalism : [англ.] // Yhe Data Journalism Handbook. — 2021. — С. 274—278. — DOI:10.2307/j.ctv1qr6smr.40.

- Brunelle J., Nelson M. Evaluating the SiteStory Transactional Web Archive With the ApacheBench Tool : [англ.] // ArXiv.org. — 2012.

- Costa M., Gomes D., Silva M. The evolution of web archiving : [англ.] // Int J Digit Libr. — 2017. — No. 18. — С. 191—205. — DOI:10.1007/s00799-016-0171-9.

- Dooley J.M., Farrell K., Kim T., Venlet J. Developing Web Archiving Metadata Best Practices to Meet User Needs : [англ.] // Journal of Western Archives. — 2017. — Vol. 8, no. 2.

- Hakala J. The NEWLIB harvester : [англ.] // Zeitschrift für Bibliothekswesen und Bibliographie. — 2001. — Vol. 48, no. 3. — С. 211—216.

- Giaretta D. Avoiding a Digital Dark Age for data: why publishers shoudl care about digital preservation : [англ.] // Learned Publishing. — 2011. — С. 1—18.

- Kimpton M., Ubois J. Year-by-Year: From an Archive of the Internet to an Archive on the Internet // Web Archiving. — 2006. — С. 201—212.

- Masanes J. Web Archiving : [англ.]. — Springer. — 1998. — С. 1—234. — ISBN 3-540-23338-5.

- Mohr G., Stack M., Ranitovic I., Avery D., Kimpton M. An Introduction to Heritrix. An open source archival quality web crawler // 4th International Web Archiving Workshop. — 2004. — С. 1—15.

- Niu J. An Overview of Web Archiving : [англ.] // School of Information Faculty Publications. — 2012. — С. 1—13. — DOI:10.1045/march2012‐niu1.

- Ogden J., Maemura E. ‘Go fish’: Conceptualising the challenges of engaging national web archives for digital research : [англ.] // International Journal of Digital Humanities. — No. 2. — С. 43—63. — DOI:10.1007/s42803-021-00032-5.

- Olson J. Chapter 14 - The Archive Data Store : [англ.] // Database Archive. — 2009. — С. 181—196. — DOI:10.1016/B978-0-12-374720-4.00014-5.

- Panos P. The Internet Archive: An End to the Digital Dark Age : [англ.] // Journal of Social Work Education. — 2003. — Vol. 39, no. 2. — С. 343—347. — DOI:10.1080/10437797.2003.10779139.

- Patel K., Phillips M., Caragea C., Fox N. Identifying Documents In-Scope of a Collection from Web Archives : [англ.] // arXiv. — 2020.

- Pennock M. Web-Archiving : [англ.]. — DPC Technology Watch Report 13-01 March 2013. — 2013. — DOI:10.7207/twr13-01.

- Perkel, J. The trouble with reference rot. : [англ.] // Nature. — 2015. — No. 521. — С. 111—112. — DOI:10.1038/521111a.

- Pretoro E., Geeraert F., Soyez S. Behind the scenes of web archiving metadata of harvested websites : [англ.] // Trust and Understanding: the value of metadata in a digitally joined-up world. — 2013. — С. 63—74.

- Rhodes S. Breaking Down Link Rot: The Chesapeake Project Legal Information Archive's Examination of URL Stability : [англ.] // Law Library Journal. — 2010. — Vol. 102, no. 4. — С. 581—597.

- Rockwell G., Tchoh B. Archiving Database Driven Websites for Future Digital Archaeologists: The Archiving of TAPoR : [англ.] // CSDH-SCHN 2020. — 2020. — DOI:10.17613/v412-8896.)

- Rogers R. Periodizing Web Archiving: Biographical, Event-Based, National and Autobiographical Traditions : [англ.] // The SAGE Handbook of Web History. — 2019. — С. 42—57.

- Rumianek M. Archiving and Recovering Database-driven Websites : [англ.] // D-Lib Magazine. — 2013. — Vol. 19, no. 1/2. — DOI:10.1045/january2013-rumianek.

- Slania H. Online Art Ephemera: Web Archiving at the National Museum of Women in the Arts : [англ.] // Art Documentation: Journal of the Art Libraries Society of North America. — 2013. — Vol. 32, no. 1. — С. 112—126.

- Toyoda M., Kitsuregawa M. The History of Web Archiving : [англ.] // Invited Paper. — 2012. — DOI:10.1109/JPROC.2012.2189920.

- Eysenbach G., Trudel M. Going, Going, Still There: Using the WebCite Service to Permanently Archive Cited Web Pages // J Med Internet Resources. — 2005. — DOI:10.2196/jmir.7.5.e60.

- Zittrain J., Bowers J., Stanton C. The Paper of Record Meets an Ephemeral Web: An Examination of Linkrot and Content Drift within The New York Times : [англ.] // Library Innovation Lab. — 2021.

- Webb C. Because It Belongs to All of Us: National Arrangements for Digital Preservation in Australian Libraries : [англ.] // Australian Academic & Research Libraries. — 2000. — С. 154—172. — DOI:10.1080/00048623.2000.10755132.

- Vlassenroot E., Chambers S., Mechant P. Web archives as a data resource for digital scholars : [англ.] // International Journal of Digital Humanities. — 2019. — Vol. 1, no. 85. — С. 85—111. — DOI:10.1007/s42803-019-00007-7.

- Vlassenroot E.,Chambers S., Lieber S., Michel A., Geeraert F., Pranger J., Birkholz J. Web-archiving and social media: an exploratory analysis : [англ.] // International Journal of Digital Humanities. — 2021. — Vol. 2. — С. 107—128.

- White J. Link Rot, Reference Rot, and Link Resolves : [англ.] // New Top Technologies Every Librarian Needs to Know. — 2019. — С. 29—43.

- Балацкая Н.М., Мартиросова М.Б. Веб-архивирование как задача национальной и краеведческой библиографии : [рос.] // Библиосфера. — 2021. — № 3. — С. 12—17.

- Поврозник Г.Г. Веб-архивы в реконструкции истории виртуальных музеев: потенциал и ограничения : [рос.] // Вестник Пермского Университета. — 2020. — Т. 51, вып. 4. — С. 95—102.

- Редькина Н.С. Мировые тенденции развития библиотек. Оптимизм vs пессимизм (по материалам зарубежной литературы) : [рос.] // Библиосфера. — 2019. — Вып. 1. — С. 49—58.