Глибоке навчання: відмінності між версіями

| [перевірена версія] | [перевірена версія] |

→Додаткова література: вікіфікація |

актуалізовано переклад «Deep learning» |

||

| Рядок 1: | Рядок 1: | ||

{{Short description|Галузь машинного навчання}} |

{{Short description|Галузь машинного навчання}} |

||

| ⚫ | |||

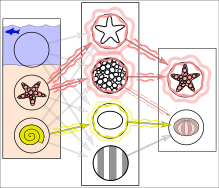

[[Файл:Deep_Learning.jpg|альт=Подання зображень на кількох шарах абстракції в глибокому навчанні|міні|Подання зображень на кількох шарах абстракції в глибокому навчанні<ref>{{Cite journal|last1=Schulz|first1=Hannes|last2=Behnke|first2=Sven|date=1 листопада 2012|title=Deep Learning|journal=KI - Künstliche Intelligenz|language=en|volume=26|issue=4|pages=357–363|doi=10.1007/s13218-012-0198-z|s2cid=220523562|issn=1610-1987|url=https://www.semanticscholar.org/paper/51a80649d16a38d41dbd20472deb3bc9b61b59a0}}</ref>]] |

[[Файл:Deep_Learning.jpg|альт=Подання зображень на кількох шарах абстракції в глибокому навчанні|міні|Подання зображень на кількох шарах абстракції в глибокому навчанні<ref>{{Cite journal|last1=Schulz|first1=Hannes|last2=Behnke|first2=Sven|date=1 листопада 2012|title=Deep Learning|journal=KI - Künstliche Intelligenz|language=en|volume=26|issue=4|pages=357–363|doi=10.1007/s13218-012-0198-z|s2cid=220523562|issn=1610-1987|url=https://www.semanticscholar.org/paper/51a80649d16a38d41dbd20472deb3bc9b61b59a0}}</ref>]] |

||

| ⚫ | |||

'''Глибо́ке навча́ння'''<ref |

'''Глибо́ке навча́ння'''<ref name="ХомаБенч2019" /><ref name="ДорошЦаплюк2021" /><ref name="БродкевичРемесло2018" /> ({{lang-en|deep learning}}, також іноді '''глиби́нне навча́ння''') — це підмножина методів [[Машинне навчання|машинного навчання]] на основі [[Штучна нейронна мережа|штучних нейронних мережах]] із [[Навчання подань|навчанням подань]]. Прикметник «глибоке» ({{lang-en|"deep"}}) стосується використання декількох шарів у мережі. Використовувані методи можуть бути [[Кероване навчання|керованими]], [[Напівкероване навчання|напівкерованими]], та [[Некероване навчання|некерованими]].<ref name="NatureBengio">{{cite journal |last1=LeCun |first1= Yann|last2=Bengio |first2=Yoshua | last3=Hinton | first3= Geoffrey|s2cid=3074096 |year=2015 |title=Deep Learning |journal=Nature |volume=521 |issue=7553 |pages=436–444 |doi=10.1038/nature14539 |pmid=26017442|bibcode=2015Natur.521..436L|language=en }}</ref> |

||

Архітектури глибокого навчання, такі як [[#Глибокі нейронні мережі|глибокі нейронні мережі]], [[Глибока мережа переконань|глибокі мережі переконань]] |

Архітектури глибокого навчання, такі як [[#Глибокі нейронні мережі|глибокі нейронні мережі]], [[Глибока мережа переконань|глибокі мережі переконань]], [[рекурентні нейронні мережі]], [[згорткові нейронні мережі]] та [[Трансформер (модель машинного навчання)|трансформери]], застосовували в таких галузях як [[комп'ютерне бачення]], [[розпізнавання мовлення]], [[обробка природної мови]], [[машинний переклад]], [[біоінформатика]], [[конструювання ліків]], {{нп|аналіз медичних зображень|||Medical image analysis}}, [[кліматологія]], перевірка матеріалів і програми [[Ігри на спеціальній дошці|настільних ігор]], де вони дали результати, порівнянні, а в деяких випадках і кращі за продуктивність експертів — людей.<ref name=":9">{{Cite book |doi=10.1109/cvpr.2012.6248110 |isbn=978-1-4673-1228-8|arxiv=1202.2745|chapter=Multi-column deep neural networks for image classification|title=2012 IEEE Conference on Computer Vision and Pattern Recognition|pages=3642–3649|year=2012|last1=Ciresan|first1=D.|last2=Meier|first2=U.|last3=Schmidhuber|first3=J.|s2cid=2161592|language=en}}</ref><ref name="krizhevsky2012">{{cite journal|last1=Krizhevsky|first1=Alex|last2=Sutskever|first2=Ilya|last3=Hinton|first3=Geoffrey|date=2012|title=ImageNet Classification with Deep Convolutional Neural Networks|url=https://www.cs.toronto.edu/~kriz/imagenet_classification_with_deep_convolutional.pdf|journal=NIPS 2012: Neural Information Processing Systems, Lake Tahoe, Nevada|access-date=2017-05-24|archive-date=2017-01-10|archive-url=https://web.archive.org/web/20170110123024/http://www.cs.toronto.edu/~kriz/imagenet_classification_with_deep_convolutional.pdf|url-status=live|language=en}}</ref><ref>{{cite web |title=Google's AlphaGo AI wins three-match series against the world's best Go player |url=https://techcrunch.com/2017/05/24/alphago-beats-planets-best-human-go-player-ke-jie/amp/ |website=TechCrunch |date=25 травня 2017 |access-date=17 червня 2018 |archive-date=17 червня 2018 |archive-url=https://web.archive.org/web/20180617065807/https://techcrunch.com/2017/05/24/alphago-beats-planets-best-human-go-player-ke-jie/amp/ |url-status=live |language=en }}</ref> |

||

[[Штучна нейронна мережа|Штучні нейронні мережі]] (ШНМ) було натхненно обробкою інформації та розподіленими комунікаційними вузлами в [[Біологічна система|біологічних системах]]. ШНМ мають різноманітні відмінності від біологічного |

[[Штучна нейронна мережа|Штучні нейронні мережі]] (ШНМ) було натхненно обробкою інформації та розподіленими комунікаційними вузлами в [[Біологічна система|біологічних системах]]. ШНМ мають різноманітні відмінності від біологічного мозку. Зокрема, штучні нейронні мережі мають тенденцію бути статичними та символьними, тоді як біологічний мозок більшості живих організмів динамічний (пластичний) та аналоговий.<ref>{{Cite journal|last1=Marblestone|first1=Adam H.|last2=Wayne|first2=Greg|last3=Kording|first3=Konrad P.|s2cid=1994856|date=2016|title=Toward an Integration of Deep Learning and Neuroscience |journal=Frontiers in Computational Neuroscience |volume=10|pages=94|doi=10.3389/fncom.2016.00094 |pmc=5021692|pmid=27683554|bibcode=2016arXiv160603813M|arxiv=1606.03813|doi-access=free|language=en}}</ref><ref>{{cite arXiv|last1=Bengio|first1=Yoshua|last2=Lee|first2=Dong-Hyun|last3=Bornschein|first3=Jorg|last4=Mesnard|first4=Thomas|last5=Lin|first5=Zhouhan|date=13 лютого 2015|title=Towards Biologically Plausible Deep Learning|eprint=1502.04156|class=cs.LG|language=en}}</ref> ШНМ загалом розглядають як низькоякісні моделі функціювання мозку.<ref>{{Cite web |date=2 листопада 2022 |title=Study urges caution when comparing neural networks to the brain |url=https://news.mit.edu/2022/neural-networks-brain-function-1102 |access-date=6 грудня 2023 |website=MIT News {{!}} Massachusetts Institute of Technology |language=en}}</ref> |

||

{{TOC limit|3}} |

{{TOC limit|3}} |

||

| Рядок 15: | Рядок 15: | ||

Глибоке навчання — це клас [[алгоритм]]ів [[Машинне навчання|машинного навчання]], який<ref name="BOOK2014">{{cite journal|last2=Yu|first2=D.|year=2014|title=Deep Learning: Methods and Applications|url=http://research.microsoft.com/pubs/209355/DeepLearning-NowPublishing-Vol7-SIG-039.pdf|journal=Foundations and Trends in Signal Processing|volume=7|issue=3–4|pages=1–199|doi=10.1561/2000000039|last1=Deng|first1=L.|access-date=2014-10-18|archive-date=2016-03-14|archive-url=https://web.archive.org/web/20160314152112/http://research.microsoft.com/pubs/209355/DeepLearning-NowPublishing-Vol7-SIG-039.pdf|url-status=live|language=en}}</ref>{{rp|page=199–200 }} використовує декілька шарів для поступового виділяння з сирого входу ознак усе вищих рівнів. Наприклад, при [[Цифрова обробка зображень|обробці зображень]] нижчі шари можуть встановлювати контури, тоді як вищі шари можуть встановлювати поняття, доречні для людини, такі як цифри, літери чи обличчя. |

Глибоке навчання — це клас [[алгоритм]]ів [[Машинне навчання|машинного навчання]], який<ref name="BOOK2014">{{cite journal|last2=Yu|first2=D.|year=2014|title=Deep Learning: Methods and Applications|url=http://research.microsoft.com/pubs/209355/DeepLearning-NowPublishing-Vol7-SIG-039.pdf|journal=Foundations and Trends in Signal Processing|volume=7|issue=3–4|pages=1–199|doi=10.1561/2000000039|last1=Deng|first1=L.|access-date=2014-10-18|archive-date=2016-03-14|archive-url=https://web.archive.org/web/20160314152112/http://research.microsoft.com/pubs/209355/DeepLearning-NowPublishing-Vol7-SIG-039.pdf|url-status=live|language=en}}</ref>{{rp|page=199–200 }} використовує декілька шарів для поступового виділяння з сирого входу ознак усе вищих рівнів. Наприклад, при [[Цифрова обробка зображень|обробці зображень]] нижчі шари можуть встановлювати контури, тоді як вищі шари можуть встановлювати поняття, доречні для людини, такі як цифри, літери чи обличчя. |

||

Якщо поглянути на глибоке навчання під іншим кутом, то глибоке навчання позначує «комп'ютерне моделювання» або «автоматизацію» процесів навчання людиною від джерела (наприклад, зображення собак) до об'єкта навчання (собак). Тому мають сенс поняття, сформульовані як «глибше» ({{lang-en| |

Якщо поглянути на глибоке навчання під іншим кутом, то глибоке навчання позначує «комп'ютерне моделювання» або «автоматизацію» процесів навчання людиною від джерела (наприклад, зображення собак) до об'єкта навчання (собак). Тому мають сенс поняття, сформульовані як «глибше» ({{lang-en|"deeper"}}) та «найглибше» ({{lang-en|"deepest"}}) навчання.<ref>{{cite book |last1=Zhang |first1=W. J. |last2=Yang |first2=G. |last3=Ji |first3=C. |last4=Gupta |first4=M. M. |title=2018 World Automation Congress (WAC) |chapter=On Definition of Deep Learning |date=2018 |pages=1–5 |doi=10.23919/WAC.2018.8430387 |isbn=978-1-5323-7791-4 |s2cid=51971897 |language=en }}</ref> Найглибше навчання позначує повністю автоматичне навчання від джерела до кінцевого об'єкта навчання. Глибше навчання відтак позначує змішаний процес навчання: процес навчання людиною від джерела до навченого напівоб'єкта, за яким слідує комп'ютерний процес навчання від навченого людиною напівоб'єкта до кінцевого об'єкта навчання. |

||

== Огляд == |

== Огляд == |

||

| Рядок 21: | Рядок 21: | ||

Більшість сучасних моделей глибокого навчання ґрунтуються на багатошарових [[Штучна нейронна мережа|штучних нейронних мережах]], таких як [[згорткові нейронні мережі]] та [[Трансформер (модель машинного навчання)|трансформери]], хоча до них також можуть належати {{нп|Пропозиційна формула|пропозиційні формули||Propositional formula}} та латентні змінні, організовані пошарово в глибоких [[Породжувальна модель|породжувальних моделях]], такі як вузли в [[Глибока мережа переконань|глибоких мережах переконань]] чи глибоких [[Машина Больцмана|машинах Больцмана]].<ref name="BENGIODEEP">{{cite journal|last=Bengio|first=Yoshua|year=2009|title=Learning Deep Architectures for AI|url=http://sanghv.com/download/soft/machine%20learning,%20artificial%20intelligence,%20mathematics%20ebooks/ML/learning%20deep%20architectures%20for%20AI%20%282009%29.pdf|journal=Foundations and Trends in Machine Learning|volume=2|issue=1|pages=1–127|doi=10.1561/2200000006|citeseerx=10.1.1.701.9550|s2cid=207178999 |access-date=3 вересня 2015|archive-url=https://web.archive.org/web/20160304084250/http://sanghv.com/download/soft/machine%20learning,%20artificial%20intelligence,%20mathematics%20ebooks/ML/learning%20deep%20architectures%20for%20AI%20(2009).pdf|archive-date=4 березня 2016|url-status=dead|language=en}}</ref> |

Більшість сучасних моделей глибокого навчання ґрунтуються на багатошарових [[Штучна нейронна мережа|штучних нейронних мережах]], таких як [[згорткові нейронні мережі]] та [[Трансформер (модель машинного навчання)|трансформери]], хоча до них також можуть належати {{нп|Пропозиційна формула|пропозиційні формули||Propositional formula}} та латентні змінні, організовані пошарово в глибоких [[Породжувальна модель|породжувальних моделях]], такі як вузли в [[Глибока мережа переконань|глибоких мережах переконань]] чи глибоких [[Машина Больцмана|машинах Больцмана]].<ref name="BENGIODEEP">{{cite journal|last=Bengio|first=Yoshua|year=2009|title=Learning Deep Architectures for AI|url=http://sanghv.com/download/soft/machine%20learning,%20artificial%20intelligence,%20mathematics%20ebooks/ML/learning%20deep%20architectures%20for%20AI%20%282009%29.pdf|journal=Foundations and Trends in Machine Learning|volume=2|issue=1|pages=1–127|doi=10.1561/2200000006|citeseerx=10.1.1.701.9550|s2cid=207178999 |access-date=3 вересня 2015|archive-url=https://web.archive.org/web/20160304084250/http://sanghv.com/download/soft/machine%20learning,%20artificial%20intelligence,%20mathematics%20ebooks/ML/learning%20deep%20architectures%20for%20AI%20(2009).pdf|archive-date=4 березня 2016|url-status=dead|language=en}}</ref> |

||

У глибокому навчанні кожен рівень вчиться перетворювати свої вхідні дані на дещо абстрактніше й складніше подання. У застосунку для розпізнавання зображень сирий вхід може бути [[Матриця (математика)|матрицею]] пікселів; перший шар подання може абстрагуватися від пікселів і кодувати контури; другий шар може складати та кодувати розташування контурів; третій шар може кодувати ніс та очі; а четвертий шар може розпізнавати, що зображення містить обличчя. Важливо, що процес глибокого навчання може ''самостійно'' вчитися, які ознаки оптимально розмістити на якому рівні. Це не звільняє від необхідності ручного |

У глибокому навчанні кожен рівень вчиться перетворювати свої вхідні дані на дещо абстрактніше й складніше подання. У застосунку для розпізнавання зображень сирий вхід може бути [[Матриця (математика)|матрицею]] пікселів; перший шар подання може абстрагуватися від пікселів і кодувати контури; другий шар може складати та кодувати розташування контурів; третій шар може кодувати ніс та очі; а четвертий шар може розпізнавати, що зображення містить обличчя. Важливо, що процес глибокого навчання може ''самостійно'' вчитися, які ознаки оптимально розмістити на якому рівні. Це не звільняє від необхідності ручного настроювання; наприклад, різна кількість та розміри шарів можуть забезпечувати різні ступені абстракції.<ref name="BENGIO2012">{{cite journal|last2=Courville|first2=A.|last3=Vincent|first3=P.|year=2013|title=Representation Learning: A Review and New Perspectives|journal=IEEE Transactions on Pattern Analysis and Machine Intelligence|volume=35|issue=8|pages=1798–1828|arxiv=1206.5538|doi=10.1109/tpami.2013.50|pmid=23787338|last1=Bengio|first1=Y.|s2cid=393948|language=en}}</ref><ref>{{cite journal|last1=LeCun|first1=Yann|last2=Bengio|first2=Yoshua|last3=Hinton|first3=Geoffrey|s2cid=3074096|title=Deep learning|journal=Nature|date=28 травня 2015|volume=521|issue=7553|pages=436–444|doi=10.1038/nature14539|pmid=26017442|bibcode=2015Natur.521..436L|language=en}}</ref> |

||

Слово «глибоке» у «глибокому навчанні» позначує кількість шарів, крізь які перетворюються дані. Точніше, системи глибокого навчання мають значну глибину ''шляху розподілу внеску'' (ШРВ, {{lang-en|credit assignment path, CAP}}). ШРВ — це ланцюг перетворень від входу до виходу. ШРВ описують потенційно причинно-наслідкові зв'язки між входом та виходом. Для [[Нейронна мережа прямого поширення|нейронної мережі прямого поширення]] глибина ШРВ дорівнює глибині мережі |

Слово «глибоке» у «глибокому навчанні» позначує кількість шарів, крізь які перетворюються дані. Точніше, системи глибокого навчання мають значну глибину ''шляху розподілу внеску'' (ШРВ, {{lang-en|credit assignment path, CAP}}). ШРВ — це ланцюг перетворень від входу до виходу. ШРВ описують потенційно причинно-наслідкові зв'язки між входом та виходом. Для [[Нейронна мережа прямого поширення|нейронної мережі прямого поширення]] глибина ШРВ дорівнює глибині мережі й є кількістю прихованих шарів плюс один (оскільки шар виходу також параметризовано). Для [[Рекурентна нейронна мережа|рекурентних нейронних мереж]], у яких сигнал може поширюватися крізь шар понад один раз, глибина ШРВ потенційно необмежена.<ref name="SCHIDHUB" /> Немає універсально узгодженого порогу глибини, який відділяє неглибоке навчання ({{lang-en|shallow learning}}) від глибокого, але більшість дослідників сходяться на думці, що глибоке навчання використовує глибину ШРВ вище 2. Було показано, що ШРВ глибини 2 це універсальний наближувач у тому сенсі, що він може моделювати будь-яку функцію.<ref>{{Cite book|url=https://books.google.com/books?id=9CqQDwAAQBAJ&pg=PA15|title=Human Behavior and Another Kind in Consciousness: Emerging Research and Opportunities: Emerging Research and Opportunities|last=Shigeki|first=Sugiyama|date=12 квітня 2019|publisher=IGI Global|isbn=978-1-5225-8218-2|language=en}}</ref> Поза цим, більше шарів не додають нічого до здатності мережі наближувати функції. Глибокі моделі (ШРВ > 2) здатні виділяти кращі ознаки, ніж неглибокі моделі, й отже, додаткові шари допомагають ефективно навчатися ознак. |

||

Архітектури глибокого навчання можливо конструювати пошарово [[Жадібний алгоритм|жадібним]] методом.<ref name="BENGIO2007">{{cite conference | first1=Yoshua | last1=Bengio | first2=Pascal | last2=Lamblin | first3=Dan | last3=Popovici | first4=Hugo | last4=Larochelle | title=Greedy layer-wise training of deep networks | year=2007 | url=http://papers.nips.cc/paper/3048-greedy-layer-wise-training-of-deep-networks.pdf | conference=Advances in neural information processing systems | pages=153–160 | access-date=2019-10-06 | archive-date=2019-10-20 | archive-url=https://web.archive.org/web/20191020195638/http://papers.nips.cc/paper/3048-greedy-layer-wise-training-of-deep-networks.pdf | url-status=live | language=en }}</ref> Глибоке навчання допомагає розплутувати ці абстракції й обирати, які ознаки покращують продуктивність.<ref name="BENGIO2012" /> |

Архітектури глибокого навчання можливо конструювати пошарово [[Жадібний алгоритм|жадібним]] методом.<ref name="BENGIO2007">{{cite conference | first1=Yoshua | last1=Bengio | first2=Pascal | last2=Lamblin | first3=Dan | last3=Popovici | first4=Hugo | last4=Larochelle | title=Greedy layer-wise training of deep networks | year=2007 | url=http://papers.nips.cc/paper/3048-greedy-layer-wise-training-of-deep-networks.pdf | conference=Advances in neural information processing systems | pages=153–160 | access-date=2019-10-06 | archive-date=2019-10-20 | archive-url=https://web.archive.org/web/20191020195638/http://papers.nips.cc/paper/3048-greedy-layer-wise-training-of-deep-networks.pdf | url-status=live | language=en }}</ref> Глибоке навчання допомагає розплутувати ці абстракції й обирати, які ознаки покращують продуктивність.<ref name="BENGIO2012" /> |

||

Для завдань [[Кероване навчання|керованого навчання]] методи глибокого навчання |

Для завдань [[Кероване навчання|керованого навчання]] методи глибокого навчання уможливлюють усування [[конструювання ознак]], переводячи дані до компактних проміжних подань, подібних до [[Метод головних компонент|головних компонент]], і виводять багатошарові структури, які усувають надмірність у поданні. |

||

Алгоритми глибокого навчання можливо застосовувати до завдань некерованого навчання. Це важлива перевага, оскільки немічені дані численніші за мічені. Прикладами глибоких структур, які можливо тренувати некерованим чином, є [[Глибока мережа переконань|глибокі мережі переконань]].<ref name="BENGIO2012" /><ref name="SCHOLARDBNS">{{cite journal | last1 = Hinton | first1 = G.E. | year = 2009| title = Deep belief networks | journal = Scholarpedia | volume = 4 | issue = 5| page = 5947 | doi=10.4249/scholarpedia.5947| bibcode = 2009SchpJ...4.5947H| doi-access = free| language = en }}</ref> |

Алгоритми глибокого навчання можливо застосовувати до завдань некерованого навчання. Це важлива перевага, оскільки немічені дані численніші за мічені. Прикладами глибоких структур, які можливо тренувати некерованим чином, є [[Глибока мережа переконань|глибокі мережі переконань]].<ref name="BENGIO2012" /><ref name="SCHOLARDBNS">{{cite journal | last1 = Hinton | first1 = G.E. | year = 2009| title = Deep belief networks | journal = Scholarpedia | volume = 4 | issue = 5| page = 5947 | doi=10.4249/scholarpedia.5947| bibcode = 2009SchpJ...4.5947H| doi-access = free| language = en }}</ref> |

||

Моделі машинного навчання тепер вправні у виявлянні складних шаблонів у даних фінансових ринків. Завдяки перевагам штучного інтелекту інвестори все частіше використовують методики глибокого навчання для прогнозування та аналізу тенденцій на фондових та валютних ринках.<ref>{{Cite journal |last1=Sahu |first1=Santosh Kumar |last2=Mokhade |first2=Anil |last3=Bokde |first3=Neeraj Dhanraj |date=січень 2023 |title=An Overview of Machine Learning, Deep Learning, and Reinforcement Learning-Based Techniques in Quantitative Finance: Recent Progress and Challenges |journal=Applied Sciences |language=en |volume=13 |issue=3 |pages=1956 |doi=10.3390/app13031956 |issn=2076-3417 |doi-access=free }}</ref> |

|||

== Інтерпретації == |

== Інтерпретації == |

||

| Рядок 37: | Рядок 39: | ||

Класична теорема про універсальне наближення стосується здатності [[Нейронна мережа прямого поширення|нейронної мережі прямого поширення]] з одним прихованим шаром скінченного розміру наближувати [[Неперервна функція|неперервні функції]].<ref name="cyb" /><ref name="horn" /><ref name="Haykin, Simon 1998" /><ref name="Hassoun, M. 1995 p. 48" /> 1989 року [[Джордж Цибенко]] опублікував перше її доведення для [[Сигмоїда|сигмоїдних]] передавальних функцій,<ref name="cyb" /> а 1991 року {{нп|Курт Горнік|3=de|4=Kurt Hornik}} узагальнив його для багатошарових архітектур прямого поширення.<ref name="horn" /> Нещодавня робота також показала, що універсальне наближення також виконується для необмежених передавальних функцій, таких як [[випрямлений лінійний вузол]] ({{lang-en|rectified linear unit}}) {{нп|Куніхіко Фукусіма|Куніхіко Фукусіми||Kunihiko Fukushima}}.<ref name="Fukushima1969" /><ref name="sonoda17">{{cite journal | last1 = Sonoda | first1 = Sho | last2=Murata | first2=Noboru | s2cid = 12149203 | year = 2017 | title = Neural network with unbounded activation functions is universal approximator | journal = Applied and Computational Harmonic Analysis | volume = 43 | issue = 2 | pages = 233–268 | doi = 10.1016/j.acha.2015.12.005| arxiv = 1505.03654| language = en }}</ref> |

Класична теорема про універсальне наближення стосується здатності [[Нейронна мережа прямого поширення|нейронної мережі прямого поширення]] з одним прихованим шаром скінченного розміру наближувати [[Неперервна функція|неперервні функції]].<ref name="cyb" /><ref name="horn" /><ref name="Haykin, Simon 1998" /><ref name="Hassoun, M. 1995 p. 48" /> 1989 року [[Джордж Цибенко]] опублікував перше її доведення для [[Сигмоїда|сигмоїдних]] передавальних функцій,<ref name="cyb" /> а 1991 року {{нп|Курт Горнік|3=de|4=Kurt Hornik}} узагальнив його для багатошарових архітектур прямого поширення.<ref name="horn" /> Нещодавня робота також показала, що універсальне наближення також виконується для необмежених передавальних функцій, таких як [[випрямлений лінійний вузол]] ({{lang-en|rectified linear unit}}) {{нп|Куніхіко Фукусіма|Куніхіко Фукусіми||Kunihiko Fukushima}}.<ref name="Fukushima1969" /><ref name="sonoda17">{{cite journal | last1 = Sonoda | first1 = Sho | last2=Murata | first2=Noboru | s2cid = 12149203 | year = 2017 | title = Neural network with unbounded activation functions is universal approximator | journal = Applied and Computational Harmonic Analysis | volume = 43 | issue = 2 | pages = 233–268 | doi = 10.1016/j.acha.2015.12.005| arxiv = 1505.03654| language = en }}</ref> |

||

Теорема про універсальне наближення для [[Глибока нейронна мережа|глибоких нейронних мереж]] розглядає пропускну спроможність мереж з обмеженою шириною, дозволяючи зростати глибині. Лу зі співавт.<ref name="ZhouLu" /> довели, що якщо ширина [[Глибока нейронна мережа|глибокої нейронної мережі]] з передавальною функцією ''[[ReLU]]'' строго більша за розмірність входу, то ця мережа може наближувати будь-яку [[Інтегровна за Лебегом функція|функцію, інтегровну за Лебегом]]; |

Теорема про універсальне наближення для [[Глибока нейронна мережа|глибоких нейронних мереж]] розглядає пропускну спроможність мереж з обмеженою шириною, дозволяючи зростати глибині. Лу зі співавт.<ref name="ZhouLu" /> довели, що якщо ширина [[Глибока нейронна мережа|глибокої нейронної мережі]] з передавальною функцією ''[[ReLU]]'' строго більша за розмірність входу, то ця мережа може наближувати будь-яку [[Інтегровна за Лебегом функція|функцію, інтегровну за Лебегом]]; якщо її ширина менша або дорівнює розмірності входу, то [[глибока нейронна мережа]] не є універсальним наближувачем. |

||

[[Імовірність|Імовірнісна]] інтерпретація<ref name="MURPHY" /> походить з галузі [[Машинне навчання|машинного навчання]]. Вона відводить провідне місце висновуванню,<ref name="BOOK2014" /><ref name="BENGIODEEP" /><ref name="BENGIO2012" /><ref name="SCHIDHUB" /><ref name="SCHOLARDBNS"/><ref name="MURPHY" /> а також таким поняттям [[Оптимізація (математика)|оптимізації]] як [[тренування]] та [[Іспит|випробування]], пов'язаним із допасовуванням та [[Узагальнення|узагальнюванням]] відповідно. Конкретніше, ймовірнісна інтерпретація розглядає нелінійність передавальної функції як [[Кумулятивна функція розподілу ймовірності|кумулятивну функцію розподілу]].<ref name="MURPHY" /> Імовірнісна інтерпретація призвела до запровадження [[Виключення (нейронні мережі)|виключення]] ({{lang-en|dropout}}) як [[Регуляризація (математика)|регуляризатора]] в нейронних мережах. Імовірнісну інтерпретацію було запроваджено дослідниками включно з [[Джон Гопфілд|Гопфілдом]], {{нп|Бернард Уїдроу|Уїдроу||Bernard Widrow}} та {{нп|Кумпаті Нарендра|Нарендрою||Kumpati S. Narendra}}, й популяризовано в оглядах, таких як від {{нп|Крістофер Бішоп|Бішопа||Christopher Bishop}}.<ref name="prml">{{cite book|title=Pattern Recognition and Machine Learning|author=Bishop, Christopher M.|year=2006|publisher=Springer|url=http://users.isr.ist.utl.pt/~wurmd/Livros/school/Bishop%20-%20Pattern%20Recognition%20And%20Machine%20Learning%20-%20Springer%20%202006.pdf|isbn=978-0-387-31073-2|access-date=2017-08-06|archive-date=2017-01-11|archive-url=https://web.archive.org/web/20170111005101/http://users.isr.ist.utl.pt/~wurmd/Livros/school/Bishop%20-%20Pattern%20Recognition%20And%20Machine%20Learning%20-%20Springer%20%202006.pdf|url-status=live|language=en}}</ref> |

[[Імовірність|Імовірнісна]] інтерпретація<ref name="MURPHY" /> походить з галузі [[Машинне навчання|машинного навчання]]. Вона відводить провідне місце висновуванню,<ref name="BOOK2014" /><ref name="BENGIODEEP" /><ref name="BENGIO2012" /><ref name="SCHIDHUB" /><ref name="SCHOLARDBNS"/><ref name="MURPHY" /> а також таким поняттям [[Оптимізація (математика)|оптимізації]] як [[тренування]] та [[Іспит|випробування]], пов'язаним із допасовуванням та [[Узагальнення|узагальнюванням]] відповідно. Конкретніше, ймовірнісна інтерпретація розглядає нелінійність передавальної функції як [[Кумулятивна функція розподілу ймовірності|кумулятивну функцію розподілу]].<ref name="MURPHY" /> Імовірнісна інтерпретація призвела до запровадження [[Виключення (нейронні мережі)|виключення]] ({{lang-en|dropout}}) як [[Регуляризація (математика)|регуляризатора]] в нейронних мережах. Імовірнісну інтерпретацію було запроваджено дослідниками включно з [[Джон Гопфілд|Гопфілдом]], {{нп|Бернард Уїдроу|Уїдроу||Bernard Widrow}} та {{нп|Кумпаті Нарендра|Нарендрою||Kumpati S. Narendra}}, й популяризовано в оглядах, таких як від {{нп|Крістофер Бішоп|Бішопа||Christopher Bishop}}.<ref name="prml">{{cite book|title=Pattern Recognition and Machine Learning|author=Bishop, Christopher M.|year=2006|publisher=Springer|url=http://users.isr.ist.utl.pt/~wurmd/Livros/school/Bishop%20-%20Pattern%20Recognition%20And%20Machine%20Learning%20-%20Springer%20%202006.pdf|isbn=978-0-387-31073-2|access-date=2017-08-06|archive-date=2017-01-11|archive-url=https://web.archive.org/web/20170111005101/http://users.isr.ist.utl.pt/~wurmd/Livros/school/Bishop%20-%20Pattern%20Recognition%20And%20Machine%20Learning%20-%20Springer%20%202006.pdf|url-status=live|language=en}}</ref> |

||

| Рядок 43: | Рядок 45: | ||

== Історія == |

== Історія == |

||

Існує два типи нейронних мереж: [[Нейронна мережа прямого поширення|нейронні мережі прямого поширення]] (НМПП, {{lang-en|feedforward neural network, FNN}}) та [[Рекурентна нейронна мережа|рекурентні нейронні мережі]] (РНМ, {{lang-en|recurrent neural network, RNN}}). РНМ мають цикли у структурі зв'язності, а НМПП — ні. У 1920-х роках {{нп|Вільгельм Ленц|||Wilhelm Lenz}} та {{нп|Ернст Ізінг|||Ernst Ising}} створили та проаналізували [[модель Ізінга]],<ref name="brush67">{{cite journal |doi=10.1103/RevModPhys.39.883|title=History of the Lenz-Ising Model|year=1967|last1=Brush|first1=Stephen G.|journal=Reviews of Modern Physics|volume=39|issue=4|pages=883–893|bibcode=1967RvMP...39..883B|language=en}}</ref> яка, по суті, є архітектурою РНМ, що не навчається, і складається з нейроноподібних порогових елементів. 1972 року {{нп|Шунічі Амарі|||Shun'ichi Amari}} зробив цю архітектуру адаптивною.<ref name="Amari1972">{{cite journal |last1=Amari |first1=Shun-Ichi |title=Learning patterns and pattern sequences by self-organizing nets of threshold elements|journal= IEEE Transactions |date=1972 |volume=C |issue=21 |pages=1197–1206 |language=en }}</ref><ref name="DLhistory" /> Його навчання РНМ популяризував [[Джон Гопфілд]] 1982 року.<ref name="Hopfield1982">{{cite journal |last1=Hopfield |first1=J. J. |title=Neural networks and physical systems with emergent collective computational abilities |journal= Proceedings of the National Academy of Sciences|date=1982 |volume=79 |issue=8 |pages=2554–2558 |doi=10.1073/pnas.79.8.2554 |pmid=6953413 |pmc=346238 |bibcode=1982PNAS...79.2554H |doi-access=free |language=en }}</ref> РНМ стали центральними для [[розпізнавання мовлення]] та {{нп|Обробка мови|обробки мови||Language processing}}. |

Існує два типи нейронних мереж: [[Нейронна мережа прямого поширення|нейронні мережі прямого поширення]] (НМПП, {{lang-en|feedforward neural network, FNN}}) та [[Рекурентна нейронна мережа|рекурентні нейронні мережі]] (РНМ, {{lang-en|recurrent neural network, RNN}}). РНМ мають цикли у структурі зв'язності, а НМПП — ні. У 1920-х роках {{нп|Вільгельм Ленц|||Wilhelm Lenz}} та {{нп|Ернст Ізінг|||Ernst Ising}} створили та проаналізували [[модель Ізінга]],<ref name="brush67">{{cite journal |doi=10.1103/RevModPhys.39.883|title=History of the Lenz-Ising Model|year=1967|last1=Brush|first1=Stephen G.|journal=Reviews of Modern Physics|volume=39|issue=4|pages=883–893|bibcode=1967RvMP...39..883B|language=en}}</ref> яка, по суті, є архітектурою РНМ, що не навчається, і складається з нейроноподібних порогових елементів. 1972 року {{нп|Шунічі Амарі|||Shun'ichi Amari}} зробив цю архітектуру адаптивною.<ref name="Amari1972">{{cite journal |last1=Amari |first1=Shun-Ichi |title=Learning patterns and pattern sequences by self-organizing nets of threshold elements|journal= IEEE Transactions |date=1972 |volume=C |issue=21 |pages=1197–1206 |language=en }}</ref><ref name="DLhistory">{{cite arXiv |eprint=2212.11279 |class=cs.NE |first=Jürgen |last=Schmidhuber |author-link=Юрген Шмідхубер |title=Annotated History of Modern AI and Deep Learning |language=en |date=2022}}</ref> Його навчання РНМ популяризував [[Джон Гопфілд]] 1982 року.<ref name="Hopfield1982">{{cite journal |last1=Hopfield |first1=J. J. |title=Neural networks and physical systems with emergent collective computational abilities |journal= Proceedings of the National Academy of Sciences|date=1982 |volume=79 |issue=8 |pages=2554–2558 |doi=10.1073/pnas.79.8.2554 |pmid=6953413 |pmc=346238 |bibcode=1982PNAS...79.2554H |doi-access=free |language=en }}</ref> РНМ стали центральними для [[розпізнавання мовлення]] та {{нп|Обробка мови|обробки мови||Language processing}}. |

||

Чарльз Тапперт пише, що [[Френк Розенблат]] розробив та дослідив усі основні складові сучасних систем глибокого навчання,<ref name="Who Is the Father of Deep Learning?">{{cite book |chapter-url=https://ieeexplore.ieee.org/document/9070967 |chapter=Who Is the Father of Deep Learning? |publisher=IEEE |doi=10.1109/CSCI49370.2019.00067 |accessdate=31 травня 2021|title=2019 International Conference on Computational Science and Computational Intelligence (CSCI) |year=2019 |last1=Tappert |first1=Charles C. |pages=343–348 |isbn=978-1-7281-5584-5 |s2cid=216043128 |language=en }}</ref> посилаючись на книгу Розенблата 1962 року,<ref name="rosenblatt1962">{{cite book|last=Rosenblatt|first=Frank|author-link=Френк Розенблат|title=Principles of Neurodynamics|year=1962|publisher=Spartan, New York|language=en}}</ref> якою було запроваджено [[багатошаровий перцептрон]] (БШП) із 3 шарами: шаром входу, прихованим шаром із випадковими вагами, що не навчалися, та шаром виходу.<ref name=" |

Чарльз Тапперт пише, що [[Френк Розенблат]] розробив та дослідив усі основні складові сучасних систем глибокого навчання,<ref name="Who Is the Father of Deep Learning?">{{cite book |chapter-url=https://ieeexplore.ieee.org/document/9070967 |chapter=Who Is the Father of Deep Learning? |publisher=IEEE |doi=10.1109/CSCI49370.2019.00067 |accessdate=31 травня 2021|title=2019 International Conference on Computational Science and Computational Intelligence (CSCI) |year=2019 |last1=Tappert |first1=Charles C. |pages=343–348 |isbn=978-1-7281-5584-5 |s2cid=216043128 |language=en }}</ref> посилаючись на книгу Розенблата 1962 року,<ref name="rosenblatt1962">{{cite book|last=Rosenblatt|first=Frank|author-link=Френк Розенблат|title=Principles of Neurodynamics|year=1962|publisher=Spartan, New York|language=en}}</ref> якою було запроваджено [[багатошаровий перцептрон]] (БШП) із 3 шарами: шаром входу, прихованим шаром із випадковими вагами, що не навчалися, та шаром виходу. Він також запропонував варіанти, включно з версією з чотирьохшаровими перцептронами, де останні два шари мають ваги, що навчаються (й отже, справжній багатошаровий перцептрон).<ref name="rosenblatt1962" />{{rp|section 16}} Крім того, термін глибоке навчання запропонувала 1986 року {{нп|Ріна Дехтер|||Rina Dechter}},<ref name="dechter1986" /> хоча історія його появи, схоже, набагато складніша.<ref>{{Cite journal |last=Fradkov |first=Alexander L. |date=2020-01-01 |title=Early History of Machine Learning |journal=IFAC-PapersOnLine |language=en |series=21st IFAC World Congress |volume=53 |issue=2 |pages=1385–1390 |doi=10.1016/j.ifacol.2020.12.1888 |s2cid=235081987 |issn=2405-8963|doi-access=free }}</ref> |

||

Перший загальний, робочий алгоритм навчання для глибоких багатошарових [[перцептрон]]ів прямого поширення керованим навчанням опублікували 1967 року [[Івахненко Олексій Григорович|Олексій Івахненко]] та [[Лапа Валентин Григорович|Валентин Лапа]].<ref name="ivak1965">{{cite book|first1=A. G. |last1=Ivakhnenko |author-link1=Івахненко Олексій Григорович |first2=V. G. |last2=Lapa |title=Cybernetics and Forecasting Techniques|url={{google books |plainurl=y |id=rGFgAAAAMAAJ}}|year=1967|publisher=American Elsevier Publishing Co.|isbn=978-0-444-00020-0|language=en}}</ref> У статті 1971 року описано глибоку мережу з восьми шарів, треновану [[Метод групового урахування аргументів|методом групового урахування аргументів]].<ref name="ivak1971">{{Cite journal|last=Ivakhnenko|first=Alexey|author-link1=Івахненко Олексій Григорович|date=1971|title=Polynomial theory of complex systems|url=http://gmdh.net/articles/history/polynomial.pdf|journal=IEEE Transactions on Systems, Man, and Cybernetics|pages=364–378|doi=10.1109/TSMC.1971.4308320|volume=SMC-1|issue=4|access-date=2019-11-05|archive-date=2017-08-29|archive-url=https://web.archive.org/web/20170829230621/http://www.gmdh.net/articles/history/polynomial.pdf|url-status=live|language=en}}</ref> |

Перший загальний, робочий алгоритм навчання для глибоких багатошарових [[перцептрон]]ів прямого поширення керованим навчанням опублікували 1967 року [[Івахненко Олексій Григорович|Олексій Івахненко]] та [[Лапа Валентин Григорович|Валентин Лапа]].<ref name="ivak1965">{{cite book|first1=A. G. |last1=Ivakhnenko |author-link1=Івахненко Олексій Григорович |first2=V. G. |last2=Lapa |title=Cybernetics and Forecasting Techniques|url={{google books |plainurl=y |id=rGFgAAAAMAAJ}}|year=1967|publisher=American Elsevier Publishing Co.|isbn=978-0-444-00020-0|language=en}}</ref> У статті 1971 року описано глибоку мережу з восьми шарів, треновану [[Метод групового урахування аргументів|методом групового урахування аргументів]].<ref name="ivak1971">{{Cite journal|last=Ivakhnenko|first=Alexey|author-link1=Івахненко Олексій Григорович|date=1971|title=Polynomial theory of complex systems|url=http://gmdh.net/articles/history/polynomial.pdf|journal=IEEE Transactions on Systems, Man, and Cybernetics|pages=364–378|doi=10.1109/TSMC.1971.4308320|volume=SMC-1|issue=4|access-date=2019-11-05|archive-date=2017-08-29|archive-url=https://web.archive.org/web/20170829230621/http://www.gmdh.net/articles/history/polynomial.pdf|url-status=live|language=en}}</ref> |

||

| Рядок 55: | Рядок 57: | ||

Ахітектури глибокого навчання для [[Згорткова нейронна мережа|згорткових нейронних мереж]] (ЗНМ, {{lang-en|convolutional neural networks, CNN}}) зі згортковими шарами та шарами зниження роздільності почалися з [[неокогнітрон]]а, запропонованого {{нп|Куніхіко Фукусіма|Куніхіко Фукусімою||Kunihiko Fukushima}} 1980 року.<ref name="FUKU1980">{{cite journal | last1 = Fukushima | first1 = K. | year = 1980 | title = Neocognitron: A self-organizing neural network model for a mechanism of pattern recognition unaffected by shift in position | journal = Biol. Cybern. | volume = 36 | issue = 4| pages = 193–202 | doi=10.1007/bf00344251 | pmid=7370364| s2cid = 206775608| language = en }}</ref> 1969 року він також запропонував [[Передавальна функція штучного нейрона|передавальну функцію]] ''[[ReLU]]'' ({{lang-en|rectified linear unit}}, випрямлений лінійний вузол).<ref name="Fukushima1969">{{cite journal |first1=K. |last1=Fukushima |title=Visual feature extraction by a multilayered network of analog threshold elements |journal=IEEE Transactions on Systems Science and Cybernetics |volume=5 |issue=4 |date=1969 |pages=322–333 |doi=10.1109/TSSC.1969.300225 |language=en}}</ref><ref name="DLhistory" /> Цей випрямляч ({{lang-en|rectifier}}) став найпопулярнішою передавальною функцією для ЗНМ та глибокого навчання в цілому.<ref>{{cite arXiv |last1=Ramachandran |first1=Prajit |last2=Barret |first2=Zoph |last3=Quoc |first3=V. Le |date=16 жовтня 2017 |title=Searching for Activation Functions |eprint=1710.05941 |class=cs.NE |language=en}}</ref> ЗНМ стали важливим інструментом [[Комп'ютерне бачення|комп'ютерного бачення]]. |

Ахітектури глибокого навчання для [[Згорткова нейронна мережа|згорткових нейронних мереж]] (ЗНМ, {{lang-en|convolutional neural networks, CNN}}) зі згортковими шарами та шарами зниження роздільності почалися з [[неокогнітрон]]а, запропонованого {{нп|Куніхіко Фукусіма|Куніхіко Фукусімою||Kunihiko Fukushima}} 1980 року.<ref name="FUKU1980">{{cite journal | last1 = Fukushima | first1 = K. | year = 1980 | title = Neocognitron: A self-organizing neural network model for a mechanism of pattern recognition unaffected by shift in position | journal = Biol. Cybern. | volume = 36 | issue = 4| pages = 193–202 | doi=10.1007/bf00344251 | pmid=7370364| s2cid = 206775608| language = en }}</ref> 1969 року він також запропонував [[Передавальна функція штучного нейрона|передавальну функцію]] ''[[ReLU]]'' ({{lang-en|rectified linear unit}}, випрямлений лінійний вузол).<ref name="Fukushima1969">{{cite journal |first1=K. |last1=Fukushima |title=Visual feature extraction by a multilayered network of analog threshold elements |journal=IEEE Transactions on Systems Science and Cybernetics |volume=5 |issue=4 |date=1969 |pages=322–333 |doi=10.1109/TSSC.1969.300225 |language=en}}</ref><ref name="DLhistory" /> Цей випрямляч ({{lang-en|rectifier}}) став найпопулярнішою передавальною функцією для ЗНМ та глибокого навчання в цілому.<ref>{{cite arXiv |last1=Ramachandran |first1=Prajit |last2=Barret |first2=Zoph |last3=Quoc |first3=V. Le |date=16 жовтня 2017 |title=Searching for Activation Functions |eprint=1710.05941 |class=cs.NE |language=en}}</ref> ЗНМ стали важливим інструментом [[Комп'ютерне бачення|комп'ютерного бачення]]. |

||

Термін ''глибоке навчання'' ({{lang-en|Deep Learning}}) у спільноті машинного навчання запровадила 1986 року {{нп|Ріна Дехтер|||Rina Dechter}},<ref name="dechter1986">{{нп|Ріна Дехтер|Rina Dechter||Rina Dechter}} (1986). Learning while searching in constraint-satisfaction problems. University of California, Computer Science Department, Cognitive Systems Laboratory.[https://www.researchgate.net/publication/221605378_Learning_While_Searching_in_Constraint-Satisfaction-Problems Online] {{Webarchive|url=https://web.archive.org/web/20160419054654/https://www.researchgate.net/publication/221605378_Learning_While_Searching_in_Constraint-Satisfaction-Problems |date=2016-04-19 }} {{ref-en}}</ref> а для [[Штучна нейронна мережа|штучних нейронних мереж]] — Ігор Айзенберг з колегами у 2000 року в контексті {{нп|Булева мережа|булевих||Boolean network}} порогових нейронів.<ref name= |

Термін ''глибоке навчання'' ({{lang-en|Deep Learning}}) у спільноті машинного навчання запровадила 1986 року {{нп|Ріна Дехтер|||Rina Dechter}},<ref name="dechter1986">{{нп|Ріна Дехтер|Rina Dechter||Rina Dechter}} (1986). Learning while searching in constraint-satisfaction problems. University of California, Computer Science Department, Cognitive Systems Laboratory.[https://www.researchgate.net/publication/221605378_Learning_While_Searching_in_Constraint-Satisfaction-Problems Online] {{Webarchive|url=https://web.archive.org/web/20160419054654/https://www.researchgate.net/publication/221605378_Learning_While_Searching_in_Constraint-Satisfaction-Problems |date=2016-04-19 }} {{ref-en}}</ref> а для [[Штучна нейронна мережа|штучних нейронних мереж]] — Ігор Айзенберг з колегами у 2000 року в контексті {{нп|Булева мережа|булевих||Boolean network}} порогових нейронів.<ref name=MV_1>{{cite book| title=Multi-Valued and Universal Binary Neurons| language=en| author1=Aizenberg, I.N.| author2=Aizenberg, N.N.| author3=Vandewalle, J.| url=https://link.springer.com/book/10.1007/978-1-4757-3115-6| publisher=Science & Business Media| date=2000| access-date=27 грудня 2023| doi=10.1007/978-1-4757-3115-6| isbn=978-0-7923-7824-2}}</ref><ref>Co-evolving recurrent neurons learn deep memory POMDPs. Proc. GECCO, Washington, D. C., pp. 1795–1802, ACM Press, New York, NY, USA, 2005. {{ref-en}}</ref> |

||

1988 року Вей Чжан зі співавт. застосували алгоритм [[Зворотне поширення|зворотного поширення]] до [[Згорткова нейронна мережа|згорткової нейронної мережі]] (спрощений неокогнітрон зі згортковими взаємозв'язками між шарами ознак зображення та останнім повноз'єднаним шаром) для розпізнавання абетки. Вони також запропонували втілення ЗНМ з оптичною обчислювальною системою.<ref name="wz1988">{{cite journal |last=Zhang |first=Wei |date=1988 |title=Shift-invariant pattern recognition neural network and its optical architecture |url=https://drive.google.com/file/d/1nN_5odSG_QVae54EsQN_qSz-0ZsX6wA0/view?usp=sharing |journal=Proceedings of Annual Conference of the Japan Society of Applied Physics |language=en}}</ref><ref name="wz1990">{{cite journal |last=Zhang |first=Wei |date=1990 |title=Parallel distributed processing model with local space-invariant interconnections and its optical architecture |url=https://drive.google.com/file/d/0B65v6Wo67Tk5ODRzZmhSR29VeDg/view?usp=sharing |journal=Applied Optics |volume=29 |issue=32 |pages=4790–7 |doi=10.1364/AO.29.004790 |pmid=20577468 |bibcode=1990ApOpt..29.4790Z |language=en}}</ref> 1989 року [[Ян ЛеКун]] зі співавт. застосували [[зворотне поширення]] до ЗНМ з метою [[Розпізнавання рукописного введення|розпізнавання рукописних поштових індексів]] у пошті. Хоч цей алгоритм і працював, тренування вимагало 3 днів.<ref name="LECUN1989">LeCun ''et al.'', "Backpropagation Applied to Handwritten Zip Code Recognition |

1988 року Вей Чжан зі співавт. застосували алгоритм [[Зворотне поширення|зворотного поширення]] до [[Згорткова нейронна мережа|згорткової нейронної мережі]] (спрощений неокогнітрон зі згортковими взаємозв'язками між шарами ознак зображення та останнім повноз'єднаним шаром) для розпізнавання абетки. Вони також запропонували втілення ЗНМ з оптичною обчислювальною системою.<ref name="wz1988">{{cite journal |last=Zhang |first=Wei |date=1988 |title=Shift-invariant pattern recognition neural network and its optical architecture |url=https://drive.google.com/file/d/1nN_5odSG_QVae54EsQN_qSz-0ZsX6wA0/view?usp=sharing |journal=Proceedings of Annual Conference of the Japan Society of Applied Physics |language=en}}</ref><ref name="wz1990">{{cite journal |last=Zhang |first=Wei |date=1990 |title=Parallel distributed processing model with local space-invariant interconnections and its optical architecture |url=https://drive.google.com/file/d/0B65v6Wo67Tk5ODRzZmhSR29VeDg/view?usp=sharing |journal=Applied Optics |volume=29 |issue=32 |pages=4790–7 |doi=10.1364/AO.29.004790 |pmid=20577468 |bibcode=1990ApOpt..29.4790Z |language=en}}</ref> 1989 року [[Ян ЛеКун]] зі співавт. застосували [[зворотне поширення]] до ЗНМ з метою [[Розпізнавання рукописного введення|розпізнавання рукописних поштових індексів]] у пошті. Хоч цей алгоритм і працював, тренування вимагало 3 днів.<ref name="LECUN1989">LeCun ''et al.'', "Backpropagation Applied to Handwritten Zip Code Recognition", ''Neural Computation'', 1, pp. 541–551, 1989. {{ref-en}}</ref> Згодом Вей Чжан зі співавт. видозмінили свою модель, видаливши останній повноз'єднаний шар, та застосувавши її для сегментування об'єктів медичних зображень 1991 року,<ref>{{cite journal |last=Zhang |first=Wei |date=1991 |title=Image processing of human corneal endothelium based on a learning network |url=https://drive.google.com/file/d/0B65v6Wo67Tk5cm5DTlNGd0NPUmM/view?usp=sharing |journal=Applied Optics |volume=30 |issue=29 |pages=4211–7 |doi=10.1364/AO.30.004211 |pmid=20706526 |bibcode=1991ApOpt..30.4211Z |language=en}}</ref> та для виявляння раку молочної залози на [[мамограма]]х 1994 року.<ref>{{cite journal |last=Zhang |first=Wei |date=1994 |title=Computerized detection of clustered microcalcifications in digital mammograms using a shift-invariant artificial neural network |url=https://drive.google.com/file/d/0B65v6Wo67Tk5Ml9qeW5nQ3poVTQ/view?usp=sharing |journal=Medical Physics |volume=21 |issue=4 |pages=517–24 |doi=10.1118/1.597177 |pmid=8058017 |bibcode=1994MedPh..21..517Z |language=en}}</ref> ''LeNet''-5 (1998), 7-рівневу ЗНМ від [[Ян ЛеКун|Яна ЛеКуна]] зі співавт.,<ref name="lecun98">{{cite journal |last=LeCun |first=Yann |author2=Léon Bottou |author3=Yoshua Bengio |author4=Patrick Haffner |title=Gradient-based learning applied to document recognition |journal=Proceedings of the IEEE |year=1998 |volume=86 |issue=11 |pages=2278–2324 |url=http://yann.lecun.com/exdb/publis/pdf/lecun-01a.pdf |access-date=7 жовтня 2016 |doi=10.1109/5.726791 |citeseerx=10.1.1.32.9552|s2cid=14542261|language=en }}</ref> що класифікує цифри, кілька банків застосували для розпізнавання рукописних чисел на чеках, оцифрованих у зображення 32×32 пікселі. |

||

У 1980-х роках [[зворотне поширення]] не працювало добре для глибокого навчання з довгими шляхами розподілу внеску. Щоби подолати цю проблему, [[Юрген Шмідхубер]] (1992) запропонував ієрархію РНМ, попередньо тренованих порівнево [[Самокероване навчання|самокерованим навчанням]].<ref name="schmidhuber1992">{{cite journal |last1=Schmidhuber |first1=Jürgen |year=1992 |title=Learning complex, extended sequences using the principle of history compression (based on TR FKI-148, 1991)|url=ftp://ftp.idsia.ch/pub/juergen/chunker.pdf |journal=Neural Computation |volume=4 |issue=2 |pages=234–242 |doi=10.1162/neco.1992.4.2.234 |s2cid=18271205 |language=en }}</ref> Вона використовує {{нп|передбачувальне кодування|||Predictive coding}} для навчання [[Подання знань|внутрішніх подань]] у кількох самоорганізованих масштабах часу. Це може істотно полегшувати наступне глибоке навчання. Цю ієрархію РНМ можливо ''скласти'' ({{lang-en|collapse}}) в єдину РНМ шляхом {{нп|Дистилювання знань|дистилювання||Knowledge distillation}} ''фрагментувальної'' ({{lang-en|chunker}}) мережі вищого рівня до ''автоматизаторної'' ({{lang-en|automatizer}}) мережі нижчого рівня.<ref name="schmidhuber1992" /><ref name="DLhistory" /> 1993 року фрагментувальник розв'язав завдання глибокого навчання, чия глибина перевищувала 1000.<ref name="schmidhuber1993">{{Cite book |url=ftp://ftp.idsia.ch/pub/juergen/habilitation.pdf |title=Habilitation Thesis |last=Schmidhuber |first=Jürgen |year=1993 |language=de |archive-url=https://web.archive.org/web/20210626185737/ftp://ftp.idsia.ch/pub/juergen/habilitation.pdf |archive-date=26 червня 2021 |url-status=dead}}</ref> |

У 1980-х роках [[зворотне поширення]] не працювало добре для глибокого навчання з довгими шляхами розподілу внеску. Щоби подолати цю проблему, [[Юрген Шмідхубер]] (1992) запропонував ієрархію РНМ, попередньо тренованих порівнево [[Самокероване навчання|самокерованим навчанням]].<ref name="schmidhuber1992">{{cite journal |last1=Schmidhuber |first1=Jürgen |year=1992 |title=Learning complex, extended sequences using the principle of history compression (based on TR FKI-148, 1991)|url=ftp://ftp.idsia.ch/pub/juergen/chunker.pdf |journal=Neural Computation |volume=4 |issue=2 |pages=234–242 |doi=10.1162/neco.1992.4.2.234 |s2cid=18271205 |language=en }}</ref> Вона використовує {{нп|передбачувальне кодування|||Predictive coding}} для навчання [[Подання знань|внутрішніх подань]] у кількох самоорганізованих масштабах часу. Це може істотно полегшувати наступне глибоке навчання. Цю ієрархію РНМ можливо ''скласти'' ({{lang-en|collapse}}) в єдину РНМ шляхом {{нп|Дистилювання знань|дистилювання||Knowledge distillation}} ''фрагментувальної'' ({{lang-en|chunker}}) мережі вищого рівня до ''автоматизаторної'' ({{lang-en|automatizer}}) мережі нижчого рівня.<ref name="schmidhuber1992" /><ref name="DLhistory" /> 1993 року фрагментувальник розв'язав завдання глибокого навчання, чия глибина перевищувала 1000.<ref name="schmidhuber1993">{{Cite book |url=ftp://ftp.idsia.ch/pub/juergen/habilitation.pdf |title=Habilitation Thesis |last=Schmidhuber |first=Jürgen |year=1993 |language=de |archive-url=https://web.archive.org/web/20210626185737/ftp://ftp.idsia.ch/pub/juergen/habilitation.pdf |archive-date=26 червня 2021 |url-status=dead}}</ref> |

||

| Рядок 65: | Рядок 67: | ||

Сучасний [[Трансформер (модель машинного навчання)|трансформер]] ({{lang-en|Transformer}}) запропонували Ашиш Васвані зі співавт. у своїй праці 2017 року «Увага — це все, що вам треба».<ref name="vaswani2017">{{cite arXiv|last8=Polosukhin|first8=Illia|last7=Kaiser|first7=Lukasz|last6=Gomez|first6=Aidan N.|last5=Jones|first5=Llion|last4=Uszkoreit|first4=Jakob|last3=Parmar|first3=Niki|last2=Shazeer|first2=Noam|last1=Vaswani|first1=Ashish|date=2017-06-12|title=Attention Is All You Need|eprint=1706.03762|class=cs.CL|language=en}}</ref> Він поєднує це з оператором [[Нормована експоненційна функція|''softmax'']] та проєкційною матрицею.<ref name="DLhistory" /> Трансформери все частіше обирають за модель для [[Обробка природної мови|обробки природної мови]].<ref name="wolf2020">{{cite book|last1=Wolf|first1=Thomas|last2=Debut|first2=Lysandre|last3=Sanh|first3=Victor|last4=Chaumond|first4=Julien|last5=Delangue|first5=Clement|last6=Moi|first6=Anthony|last7=Cistac|first7=Pierric|last8=Rault|first8=Tim|last9=Louf|first9=Remi|last10=Funtowicz|first10=Morgan|last11=Davison|first11=Joe|last12=Shleifer|first12=Sam|last13=von Platen|first13=Patrick|last14=Ma|first14=Clara|last15=Jernite|first15=Yacine|last16=Plu|first16=Julien|last17=Xu|first17=Canwen|last18=Le Scao|first18=Teven|last19=Gugger|first19=Sylvain|last20=Drame|first20=Mariama|last21=Lhoest|first21=Quentin|last22=Rush|first22=Alexander|title=Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations|chapter=Transformers: State-of-the-Art Natural Language Processing|year=2020|pages=38–45|doi=10.18653/v1/2020.emnlp-demos.6|s2cid=208117506|language=en}}</ref> Багато сучасних великих мовних моделей, таких як ''[[ChatGPT]]'', [[GPT-4|''GPT''-4]] та [[BERT (модель мови)|''BERT'']], використовують саме його. Трансформери також все частіше використовують у [[Комп'ютерне бачення|комп'ютернім баченні]].<ref>{{cite web |last1=He |first1=Cheng |title=Transformer in CV |url=https://towardsdatascience.com/transformer-in-cv-bbdb58bf335e |website=Transformer in CV |date=31 грудня 2021 |publisher=Towards Data Science |language=en}}</ref> |

Сучасний [[Трансформер (модель машинного навчання)|трансформер]] ({{lang-en|Transformer}}) запропонували Ашиш Васвані зі співавт. у своїй праці 2017 року «Увага — це все, що вам треба».<ref name="vaswani2017">{{cite arXiv|last8=Polosukhin|first8=Illia|last7=Kaiser|first7=Lukasz|last6=Gomez|first6=Aidan N.|last5=Jones|first5=Llion|last4=Uszkoreit|first4=Jakob|last3=Parmar|first3=Niki|last2=Shazeer|first2=Noam|last1=Vaswani|first1=Ashish|date=2017-06-12|title=Attention Is All You Need|eprint=1706.03762|class=cs.CL|language=en}}</ref> Він поєднує це з оператором [[Нормована експоненційна функція|''softmax'']] та проєкційною матрицею.<ref name="DLhistory" /> Трансформери все частіше обирають за модель для [[Обробка природної мови|обробки природної мови]].<ref name="wolf2020">{{cite book|last1=Wolf|first1=Thomas|last2=Debut|first2=Lysandre|last3=Sanh|first3=Victor|last4=Chaumond|first4=Julien|last5=Delangue|first5=Clement|last6=Moi|first6=Anthony|last7=Cistac|first7=Pierric|last8=Rault|first8=Tim|last9=Louf|first9=Remi|last10=Funtowicz|first10=Morgan|last11=Davison|first11=Joe|last12=Shleifer|first12=Sam|last13=von Platen|first13=Patrick|last14=Ma|first14=Clara|last15=Jernite|first15=Yacine|last16=Plu|first16=Julien|last17=Xu|first17=Canwen|last18=Le Scao|first18=Teven|last19=Gugger|first19=Sylvain|last20=Drame|first20=Mariama|last21=Lhoest|first21=Quentin|last22=Rush|first22=Alexander|title=Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations|chapter=Transformers: State-of-the-Art Natural Language Processing|year=2020|pages=38–45|doi=10.18653/v1/2020.emnlp-demos.6|s2cid=208117506|language=en}}</ref> Багато сучасних великих мовних моделей, таких як ''[[ChatGPT]]'', [[GPT-4|''GPT''-4]] та [[BERT (модель мови)|''BERT'']], використовують саме його. Трансформери також все частіше використовують у [[Комп'ютерне бачення|комп'ютернім баченні]].<ref>{{cite web |last1=He |first1=Cheng |title=Transformer in CV |url=https://towardsdatascience.com/transformer-in-cv-bbdb58bf335e |website=Transformer in CV |date=31 грудня 2021 |publisher=Towards Data Science |language=en}}</ref> |

||

1991 року [[Юрген Шмідхубер]] також опублікував змагальні нейронні мережі ({{lang-en|adversarial neural networks}}), які змагаються між собою у формі [[Антагоністична гра|антагоністичної гри]], де виграш однієї мережі є програшем іншої.<ref name="curiosity1991">{{cite conference| title = A possibility for implementing curiosity and boredom in model-building neural controllers | last1 = Schmidhuber | first1 = Jürgen | author-link = Юрген Шмідхубер | date = 1991 | publisher = MIT Press/Bradford Books| book-title = Proc. SAB'1991| pages = 222–227| language = en}}</ref><ref name="fun2010">{{cite journal|last1=Schmidhuber|first1=Jürgen|author-link=Юрген Шмідхубер|year=2010|title=Formal Theory of Creativity, Fun, and Intrinsic Motivation (1990-2010)|journal= IEEE Transactions on Autonomous Mental Development|volume=2|issue=3|pages=230–247|doi=10.1109/TAMD.2010.2056368 |s2cid=234198 |language=en }}</ref><ref name="gancurpm2020">{{Cite journal|last=Schmidhuber|first=Jürgen| author-link = Юрген Шмідхубер |date=2020|title=Generative Adversarial Networks are Special Cases of Artificial Curiosity (1990) and also Closely Related to Predictability Minimization (1991)|journal=Neural Networks |language=en|volume=127|pages=58–66|doi=10.1016/j.neunet.2020.04.008 |pmid=32334341 |arxiv=1906.04493 |s2cid=216056336 |language=en }}</ref> Перша мережа є [[Породжувальна модель|породжувальною моделлю]], яка моделює [[розподіл імовірності]] над образами на виході. Друга мережа навчається [[Градієнтний спуск|градієнтним спуском]] передбачувати реакцію середовища на ці образи. Це було названо «штучною цікавістю» ({{lang-en|"artificial curiosity"}}). 2014 року цей принцип використали у [[Породжувальна змагальна мережа|породжувальній змагальній мережі]] ({{lang-en|generative adversarial network, GAN}}) [[Ян Ґудфелоу]] зі співавт.<ref name="GANnips">{{cite conference|last1=Goodfellow|first1=Ian|last2=Pouget-Abadie|first2=Jean|last3=Mirza|first3=Mehdi|last4=Xu|first4=Bing|last5=Warde-Farley|first5=David|last6=Ozair|first6=Sherjil|last7=Courville|first7=Aaron|last8=Bengio|first8=Yoshua|year=2014|title=Generative Adversarial Networks|url=https://papers.nips.cc/paper/5423-generative-adversarial-nets.pdf|conference=Proceedings of the International Conference on Neural Information Processing Systems (NIPS 2014)|pages=2672–2680|access-date=20 серпня 2019|archive-date=22 листопада 2019|archive-url=https://web.archive.org/web/20191122034612/http://papers.nips.cc/paper/5423-generative-adversarial-nets.pdf|url-status=live|language=en}}</ref> Тут реакція навколишнього середовища дорівнює 1 або 0 залежно від того, чи належить вихід першої мережі до заданого набору. Це можливо використовувати для створення реалістичних [[дипфейк]]ів.<ref>{{Cite web|url=https://lab.witness.org/projects/synthetic-media-and-deep-fakes/|title=Prepare, Don't Panic: Synthetic Media and Deepfakes|publisher=witness.org|access-date=25 листопада 2020|archive-date=2 грудня 2020|archive-url=https://web.archive.org/web/20201202231744/https://lab.witness.org/projects/synthetic-media-and-deep-fakes/|url-status=live|language=en}}</ref> Відмінної якості зображення досягла ''{{нп|StyleGAN}}'' ''[[Nvidia]]'' (2018)<ref name="SyncedReview2018">{{Cite web |url=https://syncedreview.com/2018/12/14/gan-2-0-nvidias-hyperrealistic-face-generator/ |title=GAN 2.0: NVIDIA's Hyperrealistic Face Generator |date=14 грудня 2018 |website=SyncedReview.com|access-date=3 жовтня 2019|language=en}}</ref> на основі прогресивної породжувальної змагальної мережі ({{lang-en|Progressive GAN}}) Теро Карраса зі співавт.<ref name="progressiveGAN2017">{{ |

1991 року [[Юрген Шмідхубер]] також опублікував змагальні нейронні мережі ({{lang-en|adversarial neural networks}}), які змагаються між собою у формі [[Антагоністична гра|антагоністичної гри]], де виграш однієї мережі є програшем іншої.<ref name="curiosity1991">{{cite conference| title = A possibility for implementing curiosity and boredom in model-building neural controllers | last1 = Schmidhuber | first1 = Jürgen | author-link = Юрген Шмідхубер | date = 1991 | publisher = MIT Press/Bradford Books| book-title = Proc. SAB'1991| pages = 222–227| language = en}}</ref><ref name="fun2010">{{cite journal|last1=Schmidhuber|first1=Jürgen|author-link=Юрген Шмідхубер|year=2010|title=Formal Theory of Creativity, Fun, and Intrinsic Motivation (1990-2010)|journal= IEEE Transactions on Autonomous Mental Development|volume=2|issue=3|pages=230–247|doi=10.1109/TAMD.2010.2056368 |s2cid=234198 |language=en }}</ref><ref name="gancurpm2020">{{Cite journal|last=Schmidhuber|first=Jürgen| author-link = Юрген Шмідхубер |date=2020|title=Generative Adversarial Networks are Special Cases of Artificial Curiosity (1990) and also Closely Related to Predictability Minimization (1991)|journal=Neural Networks |language=en|volume=127|pages=58–66|doi=10.1016/j.neunet.2020.04.008 |pmid=32334341 |arxiv=1906.04493 |s2cid=216056336 |language=en }}</ref> Перша мережа є [[Породжувальна модель|породжувальною моделлю]], яка моделює [[розподіл імовірності]] над образами на виході. Друга мережа навчається [[Градієнтний спуск|градієнтним спуском]] передбачувати реакцію середовища на ці образи. Це було названо «штучною цікавістю» ({{lang-en|"artificial curiosity"}}). 2014 року цей принцип використали у [[Породжувальна змагальна мережа|породжувальній змагальній мережі]] ({{lang-en|generative adversarial network, GAN}}) [[Ян Ґудфелоу]] зі співавт.<ref name="GANnips">{{cite conference|last1=Goodfellow|first1=Ian|last2=Pouget-Abadie|first2=Jean|last3=Mirza|first3=Mehdi|last4=Xu|first4=Bing|last5=Warde-Farley|first5=David|last6=Ozair|first6=Sherjil|last7=Courville|first7=Aaron|last8=Bengio|first8=Yoshua|year=2014|title=Generative Adversarial Networks|url=https://papers.nips.cc/paper/5423-generative-adversarial-nets.pdf|conference=Proceedings of the International Conference on Neural Information Processing Systems (NIPS 2014)|pages=2672–2680|access-date=20 серпня 2019|archive-date=22 листопада 2019|archive-url=https://web.archive.org/web/20191122034612/http://papers.nips.cc/paper/5423-generative-adversarial-nets.pdf|url-status=live|language=en}}</ref> Тут реакція навколишнього середовища дорівнює 1 або 0 залежно від того, чи належить вихід першої мережі до заданого набору. Це можливо використовувати для створення реалістичних [[дипфейк]]ів.<ref>{{Cite web|url=https://lab.witness.org/projects/synthetic-media-and-deep-fakes/|title=Prepare, Don't Panic: Synthetic Media and Deepfakes|publisher=witness.org|access-date=25 листопада 2020|archive-date=2 грудня 2020|archive-url=https://web.archive.org/web/20201202231744/https://lab.witness.org/projects/synthetic-media-and-deep-fakes/|url-status=live|language=en}}</ref> Відмінної якості зображення досягла ''{{нп|StyleGAN}}'' ''[[Nvidia]]'' (2018)<ref name="SyncedReview2018">{{Cite web |url=https://syncedreview.com/2018/12/14/gan-2-0-nvidias-hyperrealistic-face-generator/ |title=GAN 2.0: NVIDIA's Hyperrealistic Face Generator |date=14 грудня 2018 |website=SyncedReview.com|access-date=3 жовтня 2019|language=en}}</ref> на основі прогресивної породжувальної змагальної мережі ({{lang-en|Progressive GAN}}) Теро Карраса зі співавт.<ref name="progressiveGAN2017">{{cite arXiv| title=Progressive Growing of GANs for Improved Quality, Stability, and Variation| last1=Karras |first1=T. |last2=Aila |first2=T. |last3=Laine |first3=S. |last4=Lehtinen |first4=J. | date=26 лютого 2018| class=cs.NE | eprint=1710.10196 |language=en}}</ref> Тут породжувач вирощується від малого до великого пірамідним чином. |

||

Дипломну працю {{нп|Зепп Хохрайтер|Зеппа Хохрайтера||Sepp Hochreiter}} (1991)<ref name="HOCH1991">S. Hochreiter., "[http://people.idsia.ch/~juergen/SeppHochreiter1991ThesisAdvisorSchmidhuber.pdf Untersuchungen zu dynamischen neuronalen Netzen] {{Webarchive|url=https://web.archive.org/web/20150306075401/http://people.idsia.ch/~juergen/SeppHochreiter1991ThesisAdvisorSchmidhuber.pdf |date=2015-03-06 }} |

Дипломну працю {{нп|Зепп Хохрайтер|Зеппа Хохрайтера||Sepp Hochreiter}} (1991)<ref name="HOCH1991">S. Hochreiter., "[http://people.idsia.ch/~juergen/SeppHochreiter1991ThesisAdvisorSchmidhuber.pdf Untersuchungen zu dynamischen neuronalen Netzen]". {{Webarchive|url=https://web.archive.org/web/20150306075401/http://people.idsia.ch/~juergen/SeppHochreiter1991ThesisAdvisorSchmidhuber.pdf |date=2015-03-06 }}. ''Diploma thesis. Institut f. Informatik, Technische Univ. Munich. Advisor: J. Schmidhuber'', 1991. {{ref-de}}</ref> його керівник [[Юрген Шмідхубер|Шмідхубер]] назвав «одним із найважливіших документів в історії машинного навчання».<ref name="DLhistory" /> Він не лише випробував [[нейронний стискач історії]],<ref name="schmidhuber1992" /> але й виявив та проаналізував [[Проблема зникання градієнту|проблему зникання градієнта]].<ref name="HOCH1991" /><ref name="HOCH2001">{{cite book|chapter-url={{google books |plainurl=y |id=NWOcMVA64aAC}}|title=A Field Guide to Dynamical Recurrent Networks|last=Hochreiter|first=S.|display-authors=etal|date=15 січня 2001|publisher=John Wiley & Sons|isbn=978-0-7803-5369-5|chapter=Gradient flow in recurrent nets: the difficulty of learning long-term dependencies|editor-last2=Kremer|editor-first2=Stefan C.|editor-first1=John F.|editor-last1=Kolen|language=en}}</ref> Для розв'язання цієї проблеми Хохрайтер запропонував рекурентні [[Залишкова нейронна мережа|залишкові]] зв'язки. Це призвело до появи методу глибокого навчання, званого [[Довга короткочасна пам'ять|довгою короткочасною пам'яттю]] (ДКЧП, {{lang-en|long short-term memory, LSTM}}), опублікованого 1997 року.<ref name=":0">{{Cite journal|last1=Hochreiter|first1=Sepp|last2=Schmidhuber|first2=Jürgen|s2cid=1915014|date=1 листопада 1997|title=Long Short-Term Memory|journal=Neural Computation|volume=9|issue=8|pages=1735–1780|doi=10.1162/neco.1997.9.8.1735|issn=0899-7667|pmid=9377276|language=en}}</ref> [[Рекурентна нейронна мережа|Рекурентні нейронні мережі]] ДКЧП можуть навчатися задач «дуже глибокого навчання»<ref name="SCHIDHUB" /> з довгими шляхами розподілу внеску, які вимагають спогадів про події, що відбулися тисячі дискретних часових кроків тому. «Стандартну ДКЧП» ({{lang-en|vanilla LSTM}}) із забувальним вентилем запропонували 1999 року {{нп|Фелікс Ґерс|||Felix Gers}}, [[Юрген Шмідхубер|Шмідхубер]] та Фред Каммінс.<ref name="lstm1999">{{Cite book |doi = 10.1049/cp:19991218|chapter = Learning to forget: Continual prediction with LSTM|title = 9th International Conference on Artificial Neural Networks: ICANN '99|volume = 1999|pages = 850–855|year = 1999|last1 = Gers|first1 = Felix| last2 = Schmidhuber|first2 = Jürgen| last3 = Cummins|first3 = Fred| isbn = 0-85296-721-7| language = en}}</ref> [[Довга короткочасна пам'ять|ДКЧП]] стала найцитованішою нейронною мережею XX століття.<ref name="DLhistory" /> 2015 року Рупеш Кумар Шрівастава, Клаус Ґрефф і Шмідхубер використали принцип [[Довга короткочасна пам'ять|ДКЧП]] для створення [[Магістралева мережа|магістралевої мережі]], [[Нейронна мережа прямого поширення|нейронної мережі прямого поширення]] з сотнями шарів, набагато глибшої за попередні.<ref name="highway2015">{{cite arXiv|last1=Srivastava|first1=Rupesh Kumar|last2=Greff|first2=Klaus|last3=Schmidhuber|first3=Jürgen|title=Highway Networks|eprint=1505.00387|date=2 травня 2015|class=cs.LG|language=en}}</ref><ref name="highway2015neurips">{{cite journal|last1=Srivastava|first1=Rupesh K|last2=Greff|first2=Klaus|last3=Schmidhuber|first3=Jürgen|title=Training Very Deep Networks|journal=Advances in Neural Information Processing Systems |date=2015|volume=28|pages=2377–2385|url=http://papers.nips.cc/paper/5850-training-very-deep-networks|publisher=Curran Associates, Inc.|language=en}}</ref> 7 місяців потому, Каймін Хе, Сян'ю Чжан; Шаоцін Рен та Цзянь Сунь виграли {{нп|Змагання ImageNet|змагання ''ImageNet''||ImageNet Competition}} 2015 із відкритовентильним або безвентильним варіантом [[Магістралева мережа|магістралевої мережі]], названим [[Залишкова нейронна мережа|за́лишковою нейронною мережею]] ({{lang-en|Residual neural network}}).<ref name="resnet2015">{{Cite conference|last1=He|first1=Kaiming|last2=Zhang|first2=Xiangyu|last3=Ren|first3=Shaoqing|last4=Sun|first4=Jian|date=2016|title=Deep Residual Learning for Image Recognition|url=https://ieeexplore.ieee.org/document/7780459|journal=2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR)|location=Las Vegas, NV, USA|publisher=IEEE|pages=770–778|arxiv=1512.03385|doi=10.1109/CVPR.2016.90|isbn=978-1-4673-8851-1|language=en}}</ref> Вона стала найцитованішою нейронною мережею XXI століття.<ref name="DLhistory" /> |

||

1994 року Андре де Карвальо разом з Майком Фейргерстом та Девідом Біссетом опублікували експериментальні результати багатошарової булевої нейронної мережі, відомої також як безвагова нейронна мережа ({{lang-en|weightless neural network}}), складеної з 3-шарового самоорганізовуваного нейромережного модуля виділяння ознак ({{lang-en|SOFT}}), з багатошаровим класифікаційним нейромережним модулем ({{lang-en|GSN}}) за ним, тренованих незалежно. Кожен шар у модулі виділяння ознак виділяв ознаки все вищої складності відносно попереднього шару.<ref>{{Cite journal |title=An integrated Boolean neural network for pattern classification |url=https://archive.org/details/sim_pattern-recognition-letters_1994-08_15_8/page/807 |journal=Pattern Recognition Letters |date=8 серпня 1994 |pages=807–813 |volume=15 |issue=8 |doi=10.1016/0167-8655(94)90009-4 |first1=Andre C. L. F. |last1=de Carvalho |first2 = Mike C. |last2=Fairhurst |first3=David |last3 = Bisset|bibcode=1994PaReL..15..807D|language=en }}</ref> |

1994 року Андре де Карвальо разом з Майком Фейргерстом та Девідом Біссетом опублікували експериментальні результати багатошарової булевої нейронної мережі, відомої також як безвагова нейронна мережа ({{lang-en|weightless neural network}}), складеної з 3-шарового самоорганізовуваного нейромережного модуля виділяння ознак ({{lang-en|SOFT}}), з багатошаровим класифікаційним нейромережним модулем ({{lang-en|GSN}}) за ним, тренованих незалежно. Кожен шар у модулі виділяння ознак виділяв ознаки все вищої складності відносно попереднього шару.<ref>{{Cite journal |title=An integrated Boolean neural network for pattern classification |url=https://archive.org/details/sim_pattern-recognition-letters_1994-08_15_8/page/807 |journal=Pattern Recognition Letters |date=8 серпня 1994 |pages=807–813 |volume=15 |issue=8 |doi=10.1016/0167-8655(94)90009-4 |first1=Andre C. L. F. |last1=de Carvalho |first2 = Mike C. |last2=Fairhurst |first3=David |last3 = Bisset|bibcode=1994PaReL..15..807D|language=en }}</ref> |

||

| Рядок 92: | Рядок 94: | ||

Вплив глибокого навчання в промисловості почався на початку 2000-х років, коли, за словами Яна ЛеКуна, ЗНМ вже обробляли приблизно від 10 % до 20 % усіх чеків, виписуваних у США.<ref name="lecun2016slides">[[Ян ЛеКун|Yann LeCun]] (2016). Slides on Deep Learning [https://indico.cern.ch/event/510372/ Online] {{Webarchive|url=https://web.archive.org/web/20160423021403/https://indico.cern.ch/event/510372/ |date=2016-04-23 }} {{ref-en}}</ref> Промислові застосування глибокого навчання для широкомасштабного розпізнавання мовлення почалися приблизно 2010 року. |

Вплив глибокого навчання в промисловості почався на початку 2000-х років, коли, за словами Яна ЛеКуна, ЗНМ вже обробляли приблизно від 10 % до 20 % усіх чеків, виписуваних у США.<ref name="lecun2016slides">[[Ян ЛеКун|Yann LeCun]] (2016). Slides on Deep Learning [https://indico.cern.ch/event/510372/ Online] {{Webarchive|url=https://web.archive.org/web/20160423021403/https://indico.cern.ch/event/510372/ |date=2016-04-23 }} {{ref-en}}</ref> Промислові застосування глибокого навчання для широкомасштабного розпізнавання мовлення почалися приблизно 2010 року. |

||

2006 року публікації [[Джефрі Гінтон|Джеффа Гінтона]], {{нп|Руслан Салахутдінов|Руслана Салахутдінова||Russ Salakhutdinov}}, Осіндеро та {{нп|Ю Хуай Тее|Тее||Yee Whye Teh}}<ref>{{Cite journal|last=Hinton|first=Geoffrey E.|date=1 жовтня 2007|title=Learning multiple layers of representation|url=http://www.cell.com/trends/cognitive-sciences/abstract/S1364-6613(07)00217-3|journal=Trends in Cognitive Sciences|volume=11|issue=10|pages=428–434|doi=10.1016/j.tics.2007.09.004|issn=1364-6613|pmid=17921042|s2cid=15066318|access-date=12 червня 2017|archive-date=11 жовтня 2013|archive-url=https://web.archive.org/web/20131011071435/http://www.cell.com/trends/cognitive-sciences/abstract/S1364-6613(07)00217-3|url-status=live|language=en}}</ref><ref name="hinton06">{{Cite journal | last1 = Hinton | first1 = G. E. | author-link1 = Джефрі Гінтон | last2 = Osindero | first2 = S. | last3 = Teh | first3 = Y. W. | doi = 10.1162/neco.2006.18.7.1527 | title = A Fast Learning Algorithm for Deep Belief Nets | journal = {{нп|Neural Computation}} | volume = 18 | issue = 7 | pages = 1527–1554 | year = 2006 | pmid = 16764513 | s2cid = 2309950 | url = http://www.cs.toronto.edu/~hinton/absps/fastnc.pdf | access-date = 2011-07-20 | archive-date = 2015-12-23 | archive-url = https://web.archive.org/web/20151223164129/http://www.cs.toronto.edu/~hinton/absps/fastnc.pdf | url-status = live | language = en }}</ref><ref name="bengio2012">{{cite arXiv |last=Bengio |first=Yoshua |author-link=Йошуа Бенжіо |eprint=1206.5533 |title=Practical recommendations for gradient-based training of deep architectures |class=cs.LG|year=2012|language=en }}</ref> показали, як багатошарову [[Нейронна мережа прямого поширення|нейронну мережу прямого поширення]] можливо ефективно попередньо тренувати шар за шаром, розглядаючи кожен шар по черзі як некеровану [[Обмежена машина Больцмана|обмежену машину Больцмана]], а потім [[Тонке налаштовування (глибоке навчання)|тонко налаштовувати]] її за допомогою керованого [[Зворотне поширення|зворотного поширення]].<ref name="HINTON2007">G. E. Hinton., "[http://www.csri.utoronto.ca/~hinton/absps/ticsdraft.pdf Learning multiple layers of representation] {{Webarchive|url=https://web.archive.org/web/20180522112408/http://www.csri.utoronto.ca/~hinton/absps/ticsdraft.pdf |date=2018-05-22 }} |

2006 року публікації [[Джефрі Гінтон|Джеффа Гінтона]], {{нп|Руслан Салахутдінов|Руслана Салахутдінова||Russ Salakhutdinov}}, Осіндеро та {{нп|Ю Хуай Тее|Тее||Yee Whye Teh}}<ref>{{Cite journal|last=Hinton|first=Geoffrey E.|date=1 жовтня 2007|title=Learning multiple layers of representation|url=http://www.cell.com/trends/cognitive-sciences/abstract/S1364-6613(07)00217-3|journal=Trends in Cognitive Sciences|volume=11|issue=10|pages=428–434|doi=10.1016/j.tics.2007.09.004|issn=1364-6613|pmid=17921042|s2cid=15066318|access-date=12 червня 2017|archive-date=11 жовтня 2013|archive-url=https://web.archive.org/web/20131011071435/http://www.cell.com/trends/cognitive-sciences/abstract/S1364-6613(07)00217-3|url-status=live|language=en}}</ref><ref name="hinton06">{{Cite journal | last1 = Hinton | first1 = G. E. | author-link1 = Джефрі Гінтон | last2 = Osindero | first2 = S. | last3 = Teh | first3 = Y. W. | doi = 10.1162/neco.2006.18.7.1527 | title = A Fast Learning Algorithm for Deep Belief Nets | journal = {{нп|Neural Computation}} | volume = 18 | issue = 7 | pages = 1527–1554 | year = 2006 | pmid = 16764513 | s2cid = 2309950 | url = http://www.cs.toronto.edu/~hinton/absps/fastnc.pdf | access-date = 2011-07-20 | archive-date = 2015-12-23 | archive-url = https://web.archive.org/web/20151223164129/http://www.cs.toronto.edu/~hinton/absps/fastnc.pdf | url-status = live | language = en }}</ref><ref name="bengio2012">{{cite arXiv |last=Bengio |first=Yoshua |author-link=Йошуа Бенжіо |eprint=1206.5533 |title=Practical recommendations for gradient-based training of deep architectures |class=cs.LG|year=2012|language=en }}</ref> показали, як багатошарову [[Нейронна мережа прямого поширення|нейронну мережу прямого поширення]] можливо ефективно попередньо тренувати шар за шаром, розглядаючи кожен шар по черзі як некеровану [[Обмежена машина Больцмана|обмежену машину Больцмана]], а потім [[Тонке налаштовування (глибоке навчання)|тонко налаштовувати]] її за допомогою керованого [[Зворотне поширення|зворотного поширення]].<ref name="HINTON2007">G. E. Hinton., "[http://www.csri.utoronto.ca/~hinton/absps/ticsdraft.pdf Learning multiple layers of representation]". {{Webarchive|url=https://web.archive.org/web/20180522112408/http://www.csri.utoronto.ca/~hinton/absps/ticsdraft.pdf |date=2018-05-22 }}. ''Trends in Cognitive Sciences'', 11, pp. 428–434, 2007. {{ref-en}}</ref> Ці праці стосувалися ''навчання'' для ''глибоких мереж переконань.'' |

||

Мотивом семінару ''NIPS'' 2009 року з глибокого навчання для розпізнавання мовлення були обмеження глибоких породжувальних моделей мовлення та можливість того, що завдяки потужнішому апаратному забезпеченню та великомасштабним наборам даних глибокі нейронні мережі (ГНМ, {{lang-en|deep neural nets, DNN}}) можуть стати практичними. Вважалося, що попереднє тренування ГНМ за допомогою породжувальних моделей глибоких мереж переконань (ГМП, {{lang-en|deep belief nets, DBN}}) дозволить подолати основні труднощі нейронних мереж. Проте було виявлено, що заміна попереднього тренування великими обсягами тренувальних даних для безпосереднього [[Зворотне поширення|зворотного поширення]] при використанні ГНМ з великими контекстнозалежними шарами виходу призводить до різко нижчих рівнів похибок, ніж у гауссової сумішевої моделі (ГСМ)/прихованої марковської моделі (ПММ), що була на рівні останніх досягнень на той час, а також ніж у передовіших систем на основі породжувальних моделей.<ref name="HintonDengYu2012">{{cite journal | last1 = Hinton | first1 = G. | last2 = Deng | first2 = L. | last3 = Yu | first3 = D. | last4 = Dahl | first4 = G. | last5 = Mohamed | first5 = A. | last6 = Jaitly | first6 = N. | last7 = Senior | first7 = A. | last8 = Vanhoucke | first8 = V. | last9 = Nguyen | first9 = P. | last10 = Sainath | first10 = T. | author10-link = Тара Сайнат | last11 = Kingsbury | first11 = B. | year = 2012 | title = Deep Neural Networks for Acoustic Modeling in Speech Recognition: The Shared Views of Four Research Groups| journal = IEEE Signal Processing Magazine | volume = 29 | issue = 6| pages = 82–97 | doi=10.1109/msp.2012.2205597 | bibcode = 2012ISPM...29...82H| s2cid = 206485943| language = en }}</ref> Природа похибок розпізнавання, породжуваних цими двома типами систем, характерно відрізнялася,<ref name="ReferenceICASSP2013" /> пропонуючи технічні прояснення щодо того, як інтегрувати глибоке навчання в наявну високоефективну систему декодування мовлення в реальному часі, розгорнуту всіма основними системами розпізнавання мовлення.<ref name="BOOK2014" /><ref name="ReferenceA">{{cite book|last2=Deng|first2=L.|date=2014|title=Automatic Speech Recognition: A Deep Learning Approach (Publisher: Springer)|url={{google books |plainurl=y |id=rUBTBQAAQBAJ}}|isbn=978-1-4471-5779-3|last1=Yu|first1=D.|language=en}}</ref><ref>{{cite web|title=Deng receives prestigious IEEE Technical Achievement Award - Microsoft Research|url=https://www.microsoft.com/en-us/research/blog/deng-receives-prestigious-ieee-technical-achievement-award/|website=Microsoft Research|date=3 грудня 2015|access-date=16 березня 2018|archive-date=16 березня 2018|archive-url=https://web.archive.org/web/20180316084821/https://www.microsoft.com/en-us/research/blog/deng-receives-prestigious-ieee-technical-achievement-award/|url-status=live|language=en}}</ref> Аналіз близько 2009—2010 років, порівнюючи ГСМ (та інші породжувальні моделі мовлення) з моделями ГНМ, стимулював перші промислові інвестиції в глибоке навчання для розпізнавання мовлення.<ref name="ReferenceICASSP2013" /> Цей аналіз було зроблено з порівнянною продуктивністю (менше 1,5 % у рівні похибок) між розрізнювальними ГНМ та породжувальними моделями.<ref name="HintonDengYu2012" /><ref name="ReferenceICASSP2013">{{cite |