Штучна нейронна мережа

Шту́чні нейро́нні мере́жі (ШНМ, англ. artificial neural networks, ANN), або конективістські системи (англ. connectionist systems) — це обчислювальні системи, натхнені біологічними нейронними мережами, що складають мозок тварин. Такі системи навчаються задач (поступально покращують свою продуктивність на них), розглядаючи приклади, загалом без спеціального програмування під задачу. Наприклад, у розпізнаванні зображень вони можуть навчатися ідентифікувати зображення, які містять котів, аналізуючи приклади зображень, мічені[en] як «кіт» і «не кіт», і використовуючи результати для ідентифікування котів в інших зображеннях. Вони роблять це без жодного апріорного знання про котів, наприклад, що вони мають хутро, хвости, вуса та котоподібні писки. Натомість, вони розвивають свій власний набір доречних характеристик з навчального матеріалу, який вони оброблюють.

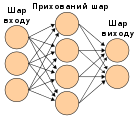

ШНМ ґрунтується на сукупності з'єднаних вузлів, що називають штучними нейронами (аналогічно до біологічних нейронів у головному мозку тварин). Кожне з'єднання (аналогічне синапсові) між штучними нейронами може передавати сигнал від одного до іншого. Штучний нейрон, що отримує сигнал, може обробляти його, й потім сигналізувати штучним нейронам, приєднаним до нього.

В поширених реалізаціях ШНМ сигнал на з'єднанні між штучними нейронами є дійсним числом, а вихід кожного штучного нейрону обчислюється нелінійною функцією суми його входів. Штучні нейрони та з'єднання зазвичай мають вагу[en], яка підлаштовується в перебігу навчання. Вага збільшує або зменшує силу сигналу на з'єднанні. Штучні нейрони можуть мати такий поріг, що сигнал надсилається лише якщо сукупний сигнал перетинає цей поріг. Штучні нейрони зазвичай організовано в шари. Різні шари можуть виконувати різні види перетворень своїх входів. Сигнали проходять від першого (входового) до останнього (виходового) шару, можливо, після проходження шарами декілька разів.

Первинною метою підходу ШНМ було розв'язання задач таким же способом, як це робив би людський мозок. З часом увага зосередилася на відповідності певним розумовим здібностям, ведучи до відхилень від біології. ШНМ використовували в ряді різноманітних задач, включно з комп'ютерним баченням, розпізнаванням мовлення, машинним перекладом, соціально-мережевим фільтруванням, грою в настільні та відеоігри, та медичним діагностуванням.

Історія

Воррен Маккалох та Волтер Піттс[en][1] (1943) створили обчислювальну модель для нейронних мереж на основі математики та алгоритмів, названою пороговою логікою. Ця модель проклала шлях до поділу досліджень нейронних мереж на два підходи. Один підхід зосереджується на біологічних процесах у мозку, тоді як інший зосереджується на застосуванні нейронних мереж до штучного інтелекту. Ця праця привела до роботи над мережами нервів та їхнього зв'язку зі скінченними автоматами.[2]

Геббове навчання

Наприкінці 1940-х років Дональд Гебб[3] створив гіпотезу навчання, засновану на механізмі нейропластичності, яка стала відомою як геббове навчання. Геббове навчання є спонтанним навчанням. Воно розвинулося в моделі довготривалого потенціювання. Дослідники почали застосовувати ці ідеї до обчислювальних моделей 1948 року в машинах Тюрінга типу B[en].

Фарлі та Кларк[en][4] (1954) вперше використали обчислювальні машини, звані тоді «калькуляторами» (англ. calculators), щоби відтворити геббову мережу. Інші нейромережеві обчислювальні машини було створено Рочестером[en], Голландом, Гебітом та Дудою (1956).[5]

Розенблат[6] (1958) створив перцептрон, алгоритм для розпізнавання образів. За допомогою математичного запису Розенблат описав схему не примітивного перцептрону, таку як схема виключного «або», яке в той час обробляти нейронними мережами було неможливо.[7]

1959 року біологічну модель, запропоновану нобелівськими лауреатами Г'юбелем та Візелем, було засновано на їхньому відкритті двох типів клітин у первинній зоровій корі: простих клітин[en] та складних клітин[en].[8]

Перші працездатні мережі з багатьма шарами було опубліковано Івахненком та Лапою 1965 року, вони стали методом групового урахування аргументів.[9][10][11]

Дослідження нейронних мереж зазнало застою після дослідження машинного навчання Мінського та Пейперта (1969),[12] які відкрили дві ключові проблеми з обчислювальними машинами, що обробляли нейронні мережі. Першою було те, що базові перцептрони були нездатні обробляти схему виключного «або». Другою було те, що комп'ютери не мали достатньої обчислювальної потужності для ефективного виконання роботи, потрібної великим нейронним мережам. Дослідження нейронних мереж уповільнилося, поки комп'ютери не досягли набагато більшої обчислювальної потужності.

Значну частину штучного інтелекту було зосереджено на оброблюваних алгоритмами високорівневих (символьних) моделях, які характеризують, наприклад, експертні системи зі знаннями, втіленими в правилах «якщо — то», поки наприкінці 1980-х років дослідження не поширилися на низькорівневе (саб-символьне) машинне навчання, що характеризується втіленням знання в параметрах пізнавальної моделі.[джерело?]

Зворотне поширення

Ключовим активатором відновлення зацікавленості нейронними мережами та навчанням був алгоритм зворотного поширення Вербоса[en] (1975), який ефективно розв'язував проблему виключного «або», і загалом прискорив навчання багатошарових мереж. Зворотне поширення розповсюджувало член похибки шарами в зворотному напрямку, змінюючи ваги в кожному вузлі.[7]

В середині 1980-х років набула популярності розподілена паралельна обробка під назвою конективізму. Румельхарт та МакКлелланд (1986) описали застосування конективізму для моделювання нейронних процесів.[13]

Метод опорних векторів та інші, значно простіші методи, такі як лінійні класифікатори, поступово наздогнали нейронні мережі за популярністю в машинному навчанні.

Попередні виклики в тренуванні глибинних нейронних мереж було успішно розв'язано за допомогою таких методів, як спонтанне попереднє тренування, в той час як доступна обчислювальна потужність зросла через застосування ГП та розподілених обчислень. Нейронні мережі було розгорнуто в великому масштабі, зокрема, в задачах розпізнавання зображень та відео. Це стало відомим як «глибинне навчання», хоча глибинне навчання не є строго синонімічним до глибинних нейронних мереж.

1992 року було представлено максимізаційне агрегування, щоби допомогти з інваріантністю відносно найменшого зсуву та терпимістю до деформації для допомоги в розпізнаванні тривимірних об'єктів.[14][15][16]

Проблема зникання градієнту впливає на багатошарові мережі прямого поширення, які використовують зворотне поширення, а також на рекурентні нейронні мережі (РНМ).[17][18] З поширенням похибок від шару до шару, вони скорочуються експоненційно з кількістю шарів, стримуючи налаштування ваг нейронів, яке ґрунтується на цих похибках, й особливо вражаючи глибинні мережі.

Щоби подолати цю проблему, Шмідгубер обрав багатошарову ієрархію мереж (1992), попередньо тренованих по одному шарові за раз за допомогою спонтанного навчання, а потім тонко налаштовуваних зворотним поширенням.[19] Бенке (2003) в таких задачах, як відбудова зображень та визначення положень облич, покладався лише на знак градієнту (еластичне зворотне поширення[en]).[20]

Хінтон та ін. (2006) запропонували навчання високорівневих представлень із застосуванням послідовних шарів двійкових або дійснозначних латентних змінних з обмеженою машиною Больцмана[21] для моделювання кожного шару. Щойно навчено достатньо багато шарів, можна застосовувати глибинну архітектуру як породжувальну модель, відтворюючи дані здійсненням вибірки моделлю донизу («спадковий прохід») від збудження ознак верхнього рівня.[22][23] 2012 року Ин та Дін створили мережу, яка вчилася розпізнавати високорівневі поняття, такі як коти, лише з перегляду немічених зображень, взятих з відео YouTube.[24]

Апаратні конструкції

Було створено обчислювальні пристрої в КМОН, як для біофізичного моделювання, так і для нейроморфних обчислень. Нанопристрої[25] для надвеликомасштабного аналізу головних компонент та згортки можуть утворити новий клас нейронних обчислень, оскільки вони є фундаментально аналоговими, а не цифровими (хоча перші втілення й можуть використовувати цифрові пристрої).[26] Чирешан з колегами (2010)[27] з групи Шмідгубера показали, що, незважаючи на проблему зникання градієнту, ГП роблять зворотне поширення придатним для багатошарових нейронних мереж прямого поширення.

Змагання

В період з 2009 по 2012 рік рекурентні нейронні мережі та глибинні нейронні мережі прямого поширення, розроблені в дослідницькій групі Шмідгубера, виграли вісім міжнародних змагань з розпізнавання образів та машинного навчання.[28][29] Наприклад, двоспрямована та багатовимірна довга короткочасна пам'ять (ДКЧП, англ. long short-term memory, LSTM)[30][31][32][33] Ґрейвса[en] та ін. виграла три змагання з розпізнаванні неперервного рукописного тексту на Міжнародній конференції з аналізу та розпізнавання документів[en] (англ. ICDAR) 2009 року без жодного попереднього знання про три мови, яких було потрібно навчитися.[32][31]

Чирешан з колегами виграли змагання з розпізнавання образів, включно зі Змаганням з розпізнавання дорожніх знаків IJCNN 2011 року,[34] Змаганням із сегментування нейронних структур у стеках електронної мікроскопії ISBI 2012 року[35] та іншими. Їхні нейронні мережі були першими, що досягли порівняної з людською, або навіть надлюдської продуктивності[36] на таких еталонах, як розпізнавання дорожніх знаків (IJCNN 2012) та задача рукописних цифр MNIST.

Дослідники показали (2010), що глибинні нейронні мережі, з'єднані з прихованою марковською моделлю з контекстно-залежними станами, які визначають шар виходу нейронної мережі, можуть докорінно знижувати похибки в задачах великословникового розпізнавання мовлення, таких як голосовий пошук.

Втілення цього підходу на основі ГП[37] виграли багато змагань з розпізнавання образів, включно зі Змаганням з розпізнавання дорожніх знаків IJCNN 2011 року,[34] Змаганням із сегментування нейронних структур в ЕМ-стеках ISBI 2012 року,[38] змаганням ImageNet[en][39] та іншими.

Глибинні, високонелінійні нейронні архітектури, подібні до неокогнітрону[40] та «стандартної архітектури бачення»,[41] натхнені простими[en] та складними клітинами[en], було попередньо треновано спонтанними методами Хінтоном.[42][22] Команда з його лабораторії виграла змагання 2012 року, спонсороване компанією Merck, для розробки програмного забезпечення для допомоги в пошуку молекул, які можуть ідентифікувати нові ліки.[43]

Згорткові мережі

Починаючи з 2011 року, передовою в мережах прямого поширення глибинного навчання була почерговість згорткових шарів та шарів максимізаційного агрегування,[37][44] увінчаних декількома повно- або частково зв'язаними шарами, за якими йде рівень остаточної класифікації. Навчання зазвичай виконується без спонтанного попереднього навчання.

Такі керовані методи глибинного навчання були першими, що досягли в певних задачах продуктивності, порівняної з людською.[36]

ШНМ змогли гарантувати інваріантність до зсуву, щоби обходитися з маленькими та великими природними об'єктами у великих загромаджених сценах, лише коли інваріантність поширилася за межі зсуву, на всі навчені ШНМ поняття, такі як розташування, тип (мітка класу об'єкта), масштаб, освітлення та інші. Це було реалізовано в еволюційних мережах (ЕМ, англ. Developmental Networks, DN),[45] чиїми втіленнями є мережі «де—що» (англ. Where-What Networks), від WWN-1 (2008)[46] до WWN-7 (2013).[47]

Моделі

(Штучна) нейронна мережа — це мережа простих елементів, званих нейронами, які отримують вхід, змінюють свій внутрішній стан (збудження) відповідно до цього входу, і виробляють вихід, залежний від входу та збудження. Мережа утворюється з'єднанням виходів певних нейронів зі входами інших нейронів з утворенням орієнтованого зваженого графу. Ваги, як і функції, що обчислюють збудження, можуть змінюватися процесом, званим навчанням, який керується правилом навчання.[48]

Складові штучної нейронної мережі

Нейрони

Нейрон з міткою , що отримує вхід від нейронів-попередників, складається з наступних складових:[48]

- збудження (англ. activation) , що залежить від дискретного параметра часу,

- можливо, порогу (англ. threshold) , що залишається незмінним, якщо його не змінить функція навчання,

- функції збудження (англ. activation function) , яка обчислює нове збудження в заданий час з , та мережевого входу , даючи в результаті відношення

- ,

- та функції виходу (англ. output function) , яка обчислює вихід з активації

- .

Функція виходу часто є просто тотожною функцією.

Нейрон входу (англ. input neuron) не має попередників, а слугує інтерфейсом входу для всієї мережі. Аналогічно, нейрон виходу (англ. output neuron) не має наступників, і відтак слугує інтерфейсом виходу для всієї мережі.

З'єднання та ваги

Мережа (англ. network) складається зі з'єднань (англ. connection), кожне з яких передає вихід нейрону до входу нейрону . В цьому сенсі є попередником (англ. predecessor) , а є наступником (англ. successor) . Кожному з'єднанню призначено вагу (англ. weight) .[48]

Функція поширення

Функція поширення (англ. propagation function) обчислює вхід до нейрону з виходів нейронів-попередників, і зазвичай має вигляд[48]

- .

Правило навчання

Правило навчання (англ. learning rule) — це правило або алгоритм, який змінює параметри нейронної мережі, щоби заданий вхід до мережі видавав придатний вихід. Цей процес навчання зазвичай полягає в зміні ваг та порогів змінних мережі.[48]

Нейронні мережі як функції

Нейромережеві моделі можна розглядати як прості математичні моделі, що визначають функцію , або розподіл над , або над та . Іноді моделі тісно пов'язують з певним правилом навчання. Поширене використання фрази «модель ШНМ» насправді є визначенням класу таких функцій (де членів цього класу отримують варіюванням параметрів, ваг з'єднань, або особливостей архітектури, таких як число нейронів або їхня зв'язність).

З математичної точки зору, нейромережеву функцію визначають як композицію інших функцій , які може бути розкладено далі на інші функції. Це може бути зручно представляти як мережеву структуру, де стрілки зображують залежність між функціями. Широко вживаним способом компонування є нелінійна зважена сума, де , де (що часто називають функцією збудження, англ. activation function[49]) є визначеною наперед функцією, такою як гіперболічний тангенс, або сигмоїдна функція, або нормована експоненційна функція, або випрямляльна функція. Важливою характеристикою функції збудження є те, що вона забезпечує плавний перехід при зміні значень входу, тобто, невелика зміна входу призводить до невеликої зміни виходу. Наведене нижче розглядає набір функцій як вектор .

Ця схема зображує такий розклад , із залежностями між змінними, показаними стрілками. Їх може бути інтерпретовано двома способами.

Перший погляд є функційним: вхід перетворювано на 3-вимірний вектор , який відтак перетворювано на 2-вимірний вектор , який нарешті перетворювано на . Цей погляд найчастіше зустрічається в контексті оптимізації.

Другий погляд є ймовірнісним: випадкова змінна залежить від випадкової змінної , яка залежить від , яка залежить від випадкової змінної . Цей погляд найчастіше зустрічається в контексті графових моделей.

Ці два погляди є здебільшого рівнозначними. В кожному з випадків, для цієї конкретної архітектури, складові окремих шарів не залежать одна від одної (наприклад, складові є незалежними одна від одної за заданого їхнього входу ). Це природно уможливлює якусь міру паралелізму в реалізації.

Такі мережі, як попередня, зазвичай називають мережами прямого поширення, оскільки їхній граф є спрямованим ациклічним графом. Мережі з циклами зазвичай називають рекурентними. Такі мережі зазвичай зображують у спосіб, показаний у верхній частині малюнка, де показано як залежну від самої себе. Проте, не показано часову залежність, що мається на увазі.

Навчання

Найбільше зацікавлення нейронними мережами викликала можливість навчання. Для заданої конкретної задачі для розв'язання та класу функцій навчання означає використання набору спостережень для знаходження , яка розв'язує цю задачу в певному оптимальному сенсі.

Це тягне за собою визначення такої функції витрат (англ. cost function) , що, для оптимального розв'язку , — тобто, жоден розв'язок не має витрат, менших за витрати оптимального розв'язку (див. математичну оптимізацію).

Функція витрат є важливим поняттям у навчанні, оскільки вона є мірою того, наскільки далеким є певний розв'язок від оптимального розв'язку задачі, яку потрібно розв'язати. Алгоритми навчання здійснюють пошук простором розв'язків, щоби знайти функцію, яка має найменші можливі витрати.

Для тих застосувань, де розв'язок залежить від даних, витрати обов'язково мусять бути функцією від спостережень, бо інакше модель не матиме зв'язку з даними. Їх часто визначають як статистику, для якої може бути зроблено лише наближення. Як простий приклад, розгляньмо задачу знаходження моделі , яка зводить до мінімуму для пар даних , що витягають з певного розподілу . В практичних ситуаціях ми матимемо лише зразків з , і, відтак, для наведеного вище прикладу ми будемо зводити до мінімуму лише . Таким чином, витрати зводяться до мінімуму над вибіркою з даних, а не над усім розподілом.

Коли , мусить застосовуватися якийсь різновид інтерактивного машинного навчання, в якому витрати знижуються з кожним побаченим зразком. І хоча інтерактивне машинне навчання часто застосовують за незмінного , найкориснішим воно є у випадку, коли цей розподіл повільно змінюється з часом. В нейромережевих методах якісь різновиди інтерактивного машинного навчання часто застосовують для скінченних наборів даних.

Обирання функції витрат

Навіть коли можливо визначити функцію витрат ad hoc, часто використовують конкретні витрати (функцію витрат), або через те, що вони мають бажані властивості (такі як опуклість), або через те, що вони природно виникають з певного формулювання задачі (наприклад, у ймовірнісному формулюванні як обернені витрати можна використовувати апостеріорну ймовірність моделі). Кінець кінцем, функція витрат залежить від задачі.

Зворотне поширення

ГНМ може бути треновано розрізнювально за допомогою стандартного алгоритму зворотного поширення (англ. backpropagation). Зворотне поширення — це метод обчислення градієнту функції втрат (видає витрати, пов'язані з заданим станом) по відношенню до ваг в ШНМ.

Основи неперервного зворотного поширення[9][50][51][52] було виведено в контексті теорії керування Келлі[en][53] 1960 року та Брайсоном[en] 1961 року[54] з використанням принципів динамічного програмування. 1962 року Дрейфус[en] опублікував простіше виведення, засноване лише на ланцюговому правилі.[55] Брайсон та Хо[en] описали його як метод багатоетапної оптимізації динамічних систем 1969 року.[56][57] 1970 року Ліннаінмаа[en] остаточно опублікував загальний метод автоматичного диференціювання (АД) дискретних зв'язних мереж вкладених диференційовних функцій.[58][59] Він відповідає сучасному баченню зворотного поширення, яке є ефективним навіть коли мережі є розрідженими.[9][50][60][61] 1973 року Дрейфус застосував зворотне поширення для пристосування параметрів контролерів пропорційно градієнтам похибок.[62] 1974 року Вербос[en] зазначив можливість застосування цього принципу до ШНМ,[63] і 1982 року він застосував метод АД Ліннаінмаа до нейронних мереж способом, який широко застосовується сьогодні.[50][64] 1986 року Румельхарт, Хінтон та Вільямс зазначили, що цей метод може породжувати корисні внутрішні представлення вхідних даних в прихованих шарах нейронних мереж.[65] 1993 року Ван став першим[9] переможцем міжнародного змагання з розпізнавання образів за допомогою зворотного поширення.[66]

Уточнення ваг зворотного поширення можливо здійснювати за допомогою стохастичного градієнтного спуску із застосуванням наступного рівняння:

де є темпом навчання, є функцією витрат (втрат), а — стохастичним членом. Вибір функції витрат залежить від таких чинників як тип навчання (кероване, спонтанне, з підкріпленням тощо) та функції збудження. Наприклад, при здійсненні керованого навчання на задачі багатокласової класифікації[en] поширеними варіантами вибору функції збудження та функції витрат є нормована експоненційна функція та функція перехресної ентропії відповідно. Нормалізовану експоненційну функцію визначають як , де представляє ймовірність класу (вихід вузла ), а та представляють загальний вхідний сигнал вузлів та одного й того ж рівня відповідно. Перехресну ентропію визначають як , де представляє цільову ймовірність для вузла виходу , а є виходом ймовірності для після застосування функції збудження.[67]

Це можливо використовувати для виведення обмежувальних коробок об'єкта у вигляді двійкової маски. Їх також використовують для багатомасштабної регресії для підвищення точності визначення положення. Регресія на основі ГНМ може навчатися ознак, що схоплюють геометричну інформацію, на додачу до того, що вони слугують добрим класифікатором. Вони усувають вимогу явного моделювання частин та їхніх взаємозв'язків. Це допомагає розширити розмаїття об'єктів, яких можна навчитися. Модель складається з декількох шарів, кожен з яких має випрямляч як функцію збудження для нелінійного перетворення. Деякі шари є згортковими, тоді як деякі є повнозв'язними. Кожен згортковий шар має додаткове максимізаційне агрегування. Мережу тренують для зведення до мінімуму похибки L2 для передбачування маски, що пробігає весь тренувальний набір, що містить обмежувальні коробки, представлені як маски.

До альтернатив зворотному поширенню належать машини екстремального навчання,[68] «безпоширні» (англ. «No-prop») мережі,[69] тренування без пошуку з вертанням,[70] «безвагові» (англ. weightless) мережі[71][72] та не-конективістські нейронні мережі[en].

Парадигми навчання

Існує три основні парадигми навчання, кожна з яких відповідає певній навчальній задачі. Ними є кероване навчання, спонтанне навчання та навчання з підкріпленням.

Кероване навчання

Кероване навчання (англ. supervised learning) використовує набір прикладів пар , і має на меті пошук функції в дозволеному класі функцій, яка відповідає цим прикладам. Іншими словами, ми хочемо вивести відображення, на яке натякають ці дані; функцію витрат пов'язано з невідповідністю між нашим відображенням та даними, і вона неявно містить апріорне знання про предметну область.[73]

Широко вживаними витратами є середньоквадратична похибка, яка намагається звести до мінімуму усереднену квадратичну похибку між виходом мережі, , та цільовим значення над усіма прикладами пар. Зведення до мінімуму цих витрат за допомогою градієнтного спуску для класу нейронних мереж, званого багатошаровими перцептронами (БШП), дає алгоритм зворотного поширення для тренування нейронних мереж.

Задачами, що вписуються до парадигми керованого навчання, є розпізнавання образів (відоме також як класифікація) та регресія (відома також як наближення функцій). Парадигма керованого навчання є застосовною також і до послідовнісних даних (наприклад, до розпізнавання писання вручну, мовлення та жестів). Його можна розглядати як навчання з «учителем» у вигляді функції, яка забезпечує постійний зворотний зв'язок стосовно якості отриманих досі розв'язків.

Спонтанне навчання

У спонтанному навчанні (англ. unsupervised learning) даються якісь дані та функція витрат для зведення до мінімуму, якою може бути будь-яка функція від даних та виходу мережі .

Функція витрат залежить від задачі (предметної області моделі) та наявних апріорних припущень (неявних властивостей моделі, її параметрів, та спостережуваних змінних).

Як тривіальний приклад, розгляньмо модель , де є сталою, а витрати . Зведення до мінімуму цих витрат дає значення , яке дорівнює середньому значенню даних. Функція витрат може бути набагато складнішою. Її вигляд залежить від застосування: наприклад, у стисненні її може бути пов'язано зі взаємною інформацією між та , тоді як у статистичному моделюванні її може бути пов'язано з апостеріорною ймовірністю моделі за заданих даних (зауважте, що в обох цих прикладах ці величини зводитимуться до максимуму, а не до мінімуму).

Задачі, що вписуються до парадигми спонтанного навчання, є загалом задачами оцінювання; до застосувань належать кластерування, оцінювання статистичних розподілів, стиснення та фільтрування.

Навчання з підкріпленням

У навчанні з підкріпленням (англ. reinforcement learning) дані зазвичай не надаються, а породжуються взаємодією агента з середовищем. В кожен момент часу агент виконує дію , а середовище породжує спостереження та миттєві витрати відповідно до якоїсь (зазвичай невідомої) динаміки. Метою є визначити таку стратегію (англ. policy) вибору дій, яка зводить до мінімуму якусь міру довготривалих витрат, наприклад, очікувані сукупні витрати. Динаміка середовища та довготривалі витрати для кожної зі стратегій є зазвичай невідомими, але їх може бути оцінено.

Формальніше, середовище моделюють як марковський процес вирішування (МПВ) зі станами та діями з наступними розподілами ймовірності: розподілом миттєвих витрат , розподілом спостережень та переходом , тоді як стратегію визначають як умовний розподіл над діями за заданих спостережень. Взята разом, ця двійка відтак утворює марковський ланцюг (МЛ). Метою є визначити таку стратегію (тобто, МЛ), що зводить витрати до мінімуму.

ШНМ часто використовують у навчанні з підкріпленням як частину загального алгоритму.[74][75] Динамічне програмування було зв'язано з ШНМ (давши нейродинамічне програмування) Берцекасом[en] та Цициклісом[en][76] і застосовано до багатовимірних нелінійних задач, таких як присутні в маршрутизувані транспорту[en],[77] природокористуванні[78][79] та медицині,[80] через здатність ШНМ пом'якшувати втрати точності навіть при зниженні щільності ґратки дискретизації для чисельного наближення розв'язків первинних задач керування.

Задачами, які вписуються до парадигми навчання з підкріпленням, є задачі керування, ігри та інші задачі послідовного ухвалювання рішень.

Алгоритм збіжного рекурсивного навчання

Алгоритм збіжного рекурсивного навчання (англ. convergent recursive learning algorithm) — метод навчання, розроблений спеціально для нейронних мереж артикуляційних контролерів мозочкової моделі[en] (АКММ, англ. cerebellar model articulation controller, CMAC). 2004 року було представлено рекурсивний алгоритм найменших квадратів для інтерактивного тренування нейронної мережі АКММ[en].[81] Цей алгоритм може збігатися за один крок та уточнювати всі ваги за один крок із будь-якими новими вхідними даними. Початково він мав обчислювальну складність O(N3). На основі QR-розкладу цей рекурсивний алгоритм навчання було спрощено до O(N).[82]

Алгоритми навчання

Тренування нейронної мережі по суті означає вибирання однієї моделі з множини дозволених моделей (або, в баєсовій системі, визначення розподілу над множиною дозволених моделей), що зводить витрати до мінімуму. Доступні численні алгоритми для тренування нейромережевих моделей; більшість із них можна розглядати як безпосереднє застосування теорії оптимізації та статистичного оцінювання.

Більшість використовують градієнтний спуск якогось вигляду, застосовуючи зворотне поширення для обчислення фактичних градієнтів. Це здійснюється просто взяттям похідної від функції витрат по відношенню до параметрів мережі, з наступною зміною цих параметрів у пов'язаному з градієнтом[en] напрямку. Алгоритми тренування зворотним поширенням поділяються на три категорії:

- найшвидший спуск (зі змінним темпом навчання та імпульсом, еластичним зворотним поширенням[en]);

- квазі-ньютонові (Бройден — Флетчер — Гольдфарб — Шанно, однокрокова січна);

- Левенберг — Марквардт та спряжені градієнти (уточнення Флетчера — Рівза, уточнення Поляка — Ріб'єра, перезапуск Павелла — Біла, масштабований спряжений градієнт).[83]

Іншими методами для тренування нейронних мереж є еволюційні методи,[84] генно-експресійне програмування[en],[85] імітування відпалювання,[86] очікування-максимізація, непараметричні методи[en] та метод рою часток.[87]

Варіанти

Метод групового урахування аргументів

Метод групового урахування аргументів (МГУА, англ. Group Method of Data Handling, GMDH)[88] демонструє повністю автоматичну структурну та параметричну оптимізацію моделей. Функціями збудження вузлів є поліноми Колмогорова — Габора, що дозволяють додавання та множення. Він використовує глибинний багатошаровий перцептрон прямого поширення з вісьмома шарами.[89] Він є мережею керованого навчання, що росте шар за шаром, де кожен з шарів треновано регресійним аналізом. Непотрібні елементи виявляються застосуванням затверджувального набору та обрізаються шляхом регуляризації. Розмір та глибина отримуваної в результаті мережі залежить від задачі.[90]

Згорткові нейронні мережі

Згорткова нейронна мережа (ЗНМ, англ. convolutional neural network, CNN) — це клас глибинних мереж прямого поширення, складених з одного чи більше згорткових шарів, із повноз'єднаними шарами (що відповідають шарам звичайних ШНМ) на верхівці. Він використовує зв'язані ваги та шари агрегування. Зокрема, за згортковою архітектурою Фукусіми[91] часто зорганізовують максимізаційне агрегування.[15] Ця архітектура дозволяє ЗНМ отримувати користь від двовимірної структури вхідних даних.

ЗНМ є зручними для обробки візуальних та інших двовимірних даних.[92][93] Вони показали чудові результати в застосуваннях як для зображень, так і для мовлення. Їх може бути треновано стандартним зворотним поширенням. ЗНМ є простішими для тренування за інші звичайні глибинні нейронні мережі прямого поширення, і мають набагато менше параметрів, що треба оцінювати.[94] До прикладів застосування в комп'ютерному баченні належить DeepDream.[95]

Довга короткочасна пам'ять

Мережі довгої короткочасної пам'яті (ДКЧП, англ. long short-term memory, LSTM) — це РНМ, які уникають проблеми зникання градієнту.[96] ДКЧП зазвичай доповнювано рекурентними вентилями, які називають забувальними (англ. forget gates).[97] Мережі ДКЧП запобігають зниканню та вибуханню зворотно поширюваних похибок.[17] Натомість, похибки можуть плинути в зворотному напрямку необмеженим числом віртуальних шарів розгорнутої в просторі ДКЧП. Таким чином, ДКЧП може вчитися задач „дуже глибокого навчання“ (англ. "very deep learning"),[9] що потребують спогадів про події, які сталися тисячі або навіть мільйони дискретних кроків часу тому. Можливо виводити проблемно-орієнтовані ДКЧП-подібні архітектури.[98] ДКЧП може мати справу з тривалими затримками та сигналами, які містять суміш низько- та високочастотних складових.

Стопки РНМ ДКЧП,[99] треновані нейромережевою часовою класифікацією (НЧК, англ. Connectionist Temporal Classification, CTC),[100] можуть знаходити матрицю ваг РНМ, яка зводить до максимуму ймовірність послідовностей міток у тренувальному наборі для відповідних заданих вхідних послідовностей. НЧК досягає як вирівнювання, так і розпізнавання.

2003 року ДКЧП почала ставати конкурентноздатною в порівнянні з традиційними розпізнавачами мовлення.[101] 2007 року, в поєднанні з НЧК, досягла перших добрих результатів на даних мовлення.[102] 2009 року ДКЧП, тренована НЧК, стала першою РНМ, яка перемогла в змаганнях із розпізнавання образів, коли вона виграла кілька змагань із неперервного рукописного розпізнавання.[9][32] 2014 року Baidu використала ДКЧП на основі НЧК, щоби перевершити еталон розпізнавання мовлення Switchboard Hub5'00, без традиційних методів обробки мовлення.[103] ДКЧП також поліпшила велико-словникове розпізнавання мовлення,[104][105] синтез мовлення з тексту,[106] для Google Android,[50][107] і фото-реалістичні голови, що розмовляють.[108] 2015 року розпізнавання мовлення Google зазнало 49-відсоткового покращення завдяки ДКЧП, тренованій НЧК.[109]

ДКЧП набула популярності в обробці природної мови. На відміну від попередніх моделей на основі ПММ та подібних концепцій, ДКЧП може навчатися розпізнавання контекстно-чутливих мов[en].[110] ДКЧП поліпшила машинний переклад,[111] моделювання мов[112] та багатомовну обробку мов.[113] ДКЧП у поєднанні з ЗНМ поліпшила автоматичний опис зображень.[114]

Глибинне резервуарне обчислення

Глибинне резервуарне обчислення (англ. Deep Reservoir Computing) та глибинні мережі з відлунням стану (англ. Deep Echo State Networks, deepESN)[115][116] забезпечують систему для ефективного тренування моделей для ієрархічної обробки часових даних, в той же час уможливлюючи дослідження властивої ролі шаруватого компонування РНМ.

Глибинні мережі переконань

Глибинна мережа переконань (ГМП, англ. deep belief network, DBN) — це ймовірнісна породжувальна модель, складена з декількох шарів прихованих вузлів. Її можна розглядати як композицію простих модулів навчання, що складають кожен з шарів.[117]

ГМП можливо використовувати для породжувального попереднього тренування ГНМ шляхом використання навчених ваг ГМП як початкових ваг ГНМ. Ці ваги потім може налаштовувати зворотне поширення або інші розрізнювальні алгоритми. Це є особливо корисним, коли тренувальні дані є обмеженими, оскільки ваги з погано заданими початковими значеннями можуть значно заважати продуктивності моделі. Ці попередньо натреновані ваги перебувають в області простору ваг, що є ближчою до оптимальних ваг, ніж якби їх було обрано випадково. Це уможливлює як поліпшене моделювання, так і швидшу збіжність фази тонкого налаштування.[118]

Нейронні мережі зберігання та вибірки великої пам'яті

Нейронні мережі зберігання та вибірки великої пам'яті (англ. large memory storage and retrieval, LAMSTAR)[119][120] є швидкими нейронними мережами глибинного навчання з багатьма шарами, які можуть використовувати багато фільтрів одночасно. Ці фільтри можуть бути нелінійними, стохастичними, логічними, не стаціонарними та навіть не аналітичними. Вони є біологічно натхненними, і навчаються безперервно.

Нейронна мережа LAMSTAR може слугувати динамічною нейронною мережею в просторовій, часовій області визначення, та в обох. Її швидкість забезпечується геббовими вагами з'єднань,[121] що об'єднують різні та, як правило, несхожі фільтри (функції попередньої обробки) у її численні шари, і для динамічного ранжування значимості різних шарів та функцій по відношенню до заданої задачі для навчання. Це грубо імітує біологічне навчання, що об'єднує різні попередні обробники (зави́тку, сітківку тощо), кори (слухову[en], зорову тощо) та різні їхні області. Її здатність до глибинного навчання додатково підсилюється використанням пригнічування, кореляції та її здатністю впоруватися з неповними даними, або „втраченими“ нейронами чи шарами навіть посеред завдання. Через свої ваги з'єднань вона є повністю прозорою. Ці ваги з'єднань також уможливлюють динамічне визначення нововведення й надмірності, та слугують ранжуванню по відношенню до завдання шарів, фільтрів та окремих нейронів.

LAMSTAR застосовували в багатьох областях, включно з медичними[122][123][124] та фінансовими прогнозуваннями,[125] адаптивним фільтруванням зашумленого мовлення в невідомому шумі,[126] розпізнаванням нерухомих зображень,[127] розпізнаванням відеозображень,[128] безпекою програмного забезпечення[129] та адаптивним керуванням нелінійними системами.[130] LAMSTAR мала значно вищу швидкість навчання та дещо нижчий рівень похибок, ніж ЗНМ на основі фільтрів на випрямлячі та максимізаційному агрегуванні, у 20 порівняльних дослідженнях.[131]

Ці застосування показують занурення в аспекти даних, що є прихованими від мереж поверхневого навчання та людських чуттів, як у випадках передбачення настання подій апное уві сні,[123] електрокардіограми плоду при записі з електродів, розташованих на поверхні шкіри живота матері в ранній період вагітності,[124] фінансового прогнозування[119] та сліпого фільтрування зашумленого мовлення.[126]

LAMSTAR було запропоновано 1996 року (A U.S. Patent 5 920 852 A), і розвинуто далі Ґраупе та Кордилевським у 1997—2002 роках.[132][133][134] Видозмінену версію, відому як LAMSTAR 2, було розроблено Шнайдером та Ґраупе 2008 року.[135][136]

Складені (знешумлювальні) автокодувальники

Ідею автокодувальника продиктовано поняттям доброго представлення. Наприклад, для класифікатора добре представлення може бути визначено як таке, що дає ефективніший класифікатор.

Кодувальник (англ. encoder) — це детерміністське відображення , що перетворює вхідний вектор x на приховане представлення y, де , є ваговою матрицею, а b є вектором зсуву (англ. offset, bias). Декодувальник (англ. decoder) відображає приховане представлення y назад на відтворюваний вхід z через . Весь процес автокодування є порівнянням цього відтвореного входу з оригінальним, і намаганням мінімізувати цю похибку, щоби зробити відтворене значення якомога ближчим до оригінального.

В складених знешумлювальних автокодувальниках (англ. stacked denoising auto encoders) частково спотворений вихід очищується (знешумлюється, англ. de-noised). Цю ідею було представлено 2010 року Венсаном та ін.[137] разом з особливим підходом до доброго представлення, добре представлення є таким, що може бути надійно отримано зі спотвореного входу, і буде корисним для відновлення відповідного чистого входу. Неявними в цьому визначенні є наступні ідеї:

- Представлення вищого рівня є відносно стабільними й стійкими до спотворень входу;

- Необхідно виділяти ознаки, що є корисними для представлення розподілу входу.

Алгоритм починається зі стохастичного відображення на через , це є спотворювальним кроком. Потім спотворений вхід проходить основним процесом автокодування, і відображується на приховане представлення . З цього прихованого представлення ми можемо відтворити . На останній стадії з метою отримання z якомога ближче до неспотвореного входу виконується алгоритм мінімізації. Похибка відтворення може бути або перехресно-ентропійною втратою з афінно-сигмоїдним декодувальником, або квадратично-похибковою втратою з афінним декодувальником.[137]

Для отримання глибинної архітектури автокодувальники накладають.[138] Щойно кодувальної функції першого знешумлювального автокодувальника навчено, й використано її для знеспотворення входу (спотвореного входу), то може бути треновано другий рівень.[137]

Щойно складений автокодувальник натреновано, його вихід може бути використано як вхід до алгоритму керованого навчання, такого як класифікатор методом опорних векторів або багатокласова логістична регресія.[137]

Глибинні складальні мережі

Глибинна складальна мережа (ГСМ, англ. deep stacking network, DSN)[139] (глибинна опукла мережа, англ. deep convex network) ґрунтується на ієрархії блоків спрощених нейромережевих модулів. Її було представлено 2011 року Деном та Доном.[140] Вона формулює навчання як задачу опуклої оптимізації з розв'язком замкненого вигляду, підкреслюючи подібність цього механізму до складеного узагальнення (англ. stacked generalization).[141] Кожен блок ГСМ є простим модулем, який легко тренувати сам по собі керованим чином без зворотного поширення для всіх блоків.[142]

Кожен блок складається зі спрощеного багатошарового перцептрону (БШП) з єдиним прихованим шаром. Прихований шар h має логістичні сигмоїдні вузли, а шар виходу має лінійні вузли. З'єднання між цими шарами представлено ваговою матрицею U; з'єднання з вхідного до прихованого шару мають вагову матрицю W. Цільові вектори t утворюють стовпчики матриці T, а вектори вхідних даних x утворюють стовпчики матриці X. Матрицею прихованих вузлів є . Модулі тренуються по черзі, тож ваги нижчого рівня W на кожному етапі є відомими. Функція виконує поелементну логістичну сигмоїдну дію. Кожен із блоків оцінює один і той самий клас кінцевих міток y, і його оцінка поєднується з первинним входом X, утворюючи розширений вхід для наступного блоку. Таким чином, вхід до першого блоку містить лише первинні дані, тоді як до входів блоків нижче за течією додається також і вихід попередніх блоків. Тоді навчання вагової матриці U вищого рівня за заданих ваг в мережі може бути сформульовано як задачу опуклої оптимізації:

що має розв'язок замкненого вигляду.

На відміну від інших глибинних архітектур, таких як ГМП, метою є не відкриття представлення в перетворених ознаках. Структура ієрархії цього типу архітектури робить паралельне тренування прямолінійним, як задачу оптимізації в пакетному режимі. В чисто розрізнювальних задачах ГСМ працюють краще за звичайні ГМП.[139]

Тензорні глибинні складальні мережі

Ця архітектура є розширенням глибинних складальних мереж (ГСМ). Вона пропонує два важливі поліпшення: вона використовує інформацію вищого порядку з коваріаційних статистик, і перетворює неопуклу задачу нижчого рівня на опуклу підзадачу вищого рівня.[143] ТГСМ використовують коваріаційні статистики у білінійному відображенні з кожного з двох окремих наборів прихованих вузлів одного й того ж рівня на передбачення, через тензор третього порядку.

Хоча розпаралелювання та масштабованість і не розглядаються серйозно в звичайних ГНМ,[144][145][146] все навчання ГСМ і ТГСМ здійснюється в пакетному режимі, щоби уможливлювати розпаралелювання.[140][139] Розпаралелювання дозволяє масштабувати цю конструкцію на більші (глибші) архітектури та набори даних.

Основна архітектура є придатною для різнопланових задач, таких як класифікація та регресія.

Піково-пластинові обмежені машини Больцмана

Потреба в глибинному навчанні з дійснозначними входами, як у ґаусових обмежених машинах Больцмана, привела до піково-пластинових ОМБ (ппОМБ, англ. spike and slab Restricted Boltzmann machine, ssRBM), які моделюють безперервнозначні входи строго двійковими[en] латентними змінними.[147] Подібно до базових ОМБ та її варіантів, піково-пластинова ОМБ є двочастковим графом, але, як у ҐОМБ, видимі вузли (входи) є дійснозначними. Відмінність є в прихованому шарі, де кожен прихований вузол має змінну двійкового піку (англ. spike) та змінну дійснозначної пластини (англ. slab). Пік є дискретною масою ймовірності на нулі, тоді як пластина є густиною ймовірності над безперервною областю визначення;[148] їхня суміш формує апріорне.[149]

Розширення ппОМБ, що називається µ-ппОМБ, забезпечує додаткові моделювальні потужності, використовуючи додаткові члени в енергетичній функції. Один із цих членів дає моделі можливість формувати умовний розподіл пікових змінних знеособленням пластинових змінних за заданого спостереження.

Змішані ієрархічно-глибинні моделі

Змішані ієрархічно-глибинні моделі (англ. compound hierarchical-deep models, compound HD models) компонують глибинні мережі з непараметричними баєсовими моделями. Ознак можливо навчатися із застосуванням таких глибинних архітектур як ГМП,[150] ГМБ,[151] глибинні автокодувальники,[152] згорткові варіанти,[153][154] ппОМБ,[148] мережі глибинного кодування,[155] ГМП з розрідженим навчанням ознак,[156] РНМ,[157] умовні ГМП,[158] знешумлювальні автокодувальники.[159] Це забезпечує краще представлення, уможливлюючи швидше навчання та точнішу класифікацію із даними високої розмірності. Проте ці архітектури є слабкими в навчанні нововведених класів на кількох прикладах, оскільки всі вузли мережі залучено до представлення входу (розподілене представлення), і мусить бути приладжувано разом (високий ступінь свободи). Обмеження ступеню свободи знижує кількість параметрів для навчання, допомагаючи навчанню нових класів з кількох прикладів. Ієрархічні баєсові (ІБ) моделі (англ. Hierarchical Bayesian (HB) models) забезпечують навчання з кількох прикладів, наприклад,[160][161][162][163][164] для комп'ютерного бачення, статистики та когнітивної науки.

Змішані ІГ-архітектури мають на меті поєднання характеристик як ІБ, так і глибинних мереж. Змішана архітектура ІПД-ГМБ є ієрархічним процесом Діріхле[en] (ІПД) як ієрархічною моделлю, об'єднаною з архітектурою ГМБ. Вона є повністю породжувальною моделлю, узагальнюваною з абстрактних понять, що течуть крізь шари цієї моделі, яка є здатною синтезувати нові приклади нововведених класів, що виглядають «досить» природними. Навчання всіх рівнів відбувається спільно, зведенням до максимуму функції внеску логарифмічної ймовірності.[165]

У ГМБ з трьома прихованими шарами ймовірністю видимого входу ν є

де є набором прихованих вузлів, а є параметрами моделі, що представляють умови симетричної взаємодії видимі-приховані та приховані-приховані.

Навчена модель ГМБ є неорієнтованою моделлю, що визначає спільний розподіл . Одним із шляхів вираження того, чого було навчено, є умовна модель та апріорний член .

Тут представляє умовну модель ГМБ, що можливо розглядати як двошарову ГМБ, але з умовами зсуву, що задаються станами :

Глибинні передбачувальні кодувальні мережі

Глибинна передбачувальна кодувальна мережа (ГПКМ, англ. Deep predictive coding network, DPCN) — це передбачувальна схема кодування, що використовує спадну інформацію для емпіричного підлаштовування апріорних, необхідних для процедури висхідного висновування, засобами глибинної локально з'єднаної породжувальної моделі. Це працює шляхом виділяння розріджених ознак зі спостережень, що змінюються в часі, із застосуванням лінійної динамічної моделі. Потім для навчання інваріантних представлень ознак застосовується стратегія агрегування (англ. pooling). Ці блоки компонуються, щоби сформувати глибинну архітектуру, і тренуються жадібним пошаровим спонтанним навчанням. Шари утворюють щось на зразок марковського ланцюга, такого, що стани на будь-якому шарі залежать лише від наступного та попереднього шарів.

ГПКМ передбачують представлення шару, використовуючи спадний підхід із застосуванням інформації з вищого шару та часових залежностей від попередніх станів.[166]

ГПКМ можливо розширювати таким чином, щоби утворювати згорткову мережу.[166]

Мережі з окремими структурами пам'яті

Поєднання зовнішньої пам'яті з ШНМ бере свій початок у ранніх дослідженнях розподілених представлень[167] та самоорганізаційних відображень Кохонена. Наприклад, у розрідженій розподіленій пам'яті[en] та ієрархічній часовій пам'яті зразки, закодовані нейронними мережами, використовуються як адреси для асоціативної пам'яті, з «нейронами», що по суті слугують шифраторами та дешифраторами адреси. Проте, ранні контролери таких типів пам'яті не були диференційовними.

Диференційовні структури пам'яті, пов'язані з ДКЧП

Окрім довгої короткочасної пам'яті (ДКЧП), диференційовну пам'ять до рекурентних функцій також додали й інші підходи. Наприклад:

- Диференційовні дії проштовхування та виштовхування для мереж альтернативної пам'яті, що називаються нейронними стековими машинами (англ. neural stack machines)[168][169]

- Мережі пам'яті, в яких зовнішнє диференційовне сховище керівної мережі знаходиться у швидких вагах іншої мережі[170]

- Забувальні вентилі ДКЧП[171]

- Автореферентні РНМ з особливими вузлами виходу для адресування та швидкого маніпулювання власними вагами РНМ на диференційовний манір (внутрішнє сховище)[172][173]

- Навчання перетворення з необмеженою пам'яттю[174]

Нейронні машини Тюрінга

Нейронні машини Тюрінга (англ. Neural Turing machines)[175] спаровують мережі ДКЧП із зовнішніми ресурсами пам'яті, з якими вони можуть взаємодіяти за допомогою процесів уваги (англ. attentional processes). Ця зв'язана система є аналогічною машині Тюрінга, але є диференційовною з краю в край, що дозволяє їй дієво навчатися градієнтним спуском. Попередні результати показують, що нейронні машини Тюрінга можуть виводити з прикладів входу та виходу прості алгоритми, такі як копіювання, впорядкування та асоціативне пригадування.

Диференційовні нейронні комп'ютери[en] (англ. Differentiable neural computers, DNC) — це розширення нейронних машин Тюрінга. На задачах обробки послідовностей вони перевершили нейронні машини Тюрінга, системи довгої короткочасної пам'яті та мережі з пам'яттю.[176][177][178][179][180]

Семантичне гешування

Підходи, які представляють попередній досвід безпосередньо, і використовують схожий досвід для формування локальної моделі, часто називають методами найближчого сусіда[en] або k-найближчих сусідів.[181] В семантичному гешуванні (англ. semantic hashing) є корисним глибинне навчання,[182] де з великого набору документів отримується глибинна графова модель векторів кількостей слів.[183] Документи відображуються на комірки пам'яті таким чином, що семантично схожі документи розташовуються за близькими адресами. Потім документи, схожі на документ із запиту, можливо знаходити шляхом простого доступу до всіх адрес, що відрізняються від адреси документа із запиту лише кількома бітами. На відміну від розрідженої розподіленої пам'яті[en], що оперує 1000-бітними адресами, семантичне гешування працює на 32- або 64-бітних адресах, що зустрічаються в традиційній комп'ютерній архітектурі.

Мережі з пам'яттю

Мережі з пам'яттю (англ. memory networks)[184][185] є іншим розширенням нейронних мереж, що включає довготривалу пам'ять[en]. Довготривала пам'ять може читатися або записуватися з метою використання її для передбачення. Ці моделі застосовувалися в контексті питально-відповідальних систем (англ. question answering, QA), де довготривала пам'ять ефективно діє як (динамічна) база знань, а вихід є текстовою відповіддю.[186]

Вказівникові мережі

Глибинні мережі може бути потенційно поліпшено поглибленням та скороченням параметрів, за збереження здатності до навчання. В той час як тренування надзвичайно глибоких (наприклад, завглибшки мільйон шарів) нейронних мереж може бути непрактичним, ЦП-подібні архітектури, такі як вказівникові мережі (англ. pointer networks)[187] та нейронні машини з довільним доступом (англ. neural random-access machines),[188] долають це обмеження завдяки застосуванню зовнішньої пам'яті з довільним доступом та інших складових, що зазвичай належать до комп'ютерної архітектури, таких як регістри, АЛП та вказівники. Такі системи працюють на векторах розподілів імовірностей, що зберігаються в комірках пам'яті та регістрах. Таким чином, ця модель є повністю диференційовною і тренується з краю в край. Ключовою характеристикою цих моделей є те, що їхня глибина, розмір їхньої короткочасної пам'яті та число параметрів можливо змінювати незалежно — на відміну від моделей на кшталт ДКЧП, чиє число параметрів зростає квадратично з розміром пам'яті.

Кодувально-декодувальні мережі

Кодувально-декодувальні системи (англ. encoder–decoder frameworks) ґрунтуються на нейронних мережах, що відображують високоструктурований вхід на високоструктурований вихід. Цей підхід виник у контексті машинного перекладу,[189][190][191] де вхід та вихід є писаними реченнями двома природними мовами. В тій праці РНМ або ЗНМ ДКЧП використовувалася як кодувальник для отримання зведення про вхідне речення, і це зведення декодувалося умовною РНМ-моделлю мови для продукування перекладу.[192] Для цих систем є спільними будівельні блоки: вентильні (англ. gated) РНМ та ЗНМ, і треновані механізми уваги.

Багатошарова ядрова машина

Багатошарові ядрові машини (БЯМ, англ. Multilayer Kernel Machine, MKM) — це спосіб навчання високо нелінійних функцій за допомогою ітеративного застосування слабко нелінійних ядер. Вони використовують ядровий метод головних компонент[en] (ЯМГК, англ. kernel principal component analysis, KPCA)[193] як метод для спонтанного жадібного пошарового передтренувального кроку архітектури глибинного навчання.[194]

-й шар навчається представлення попереднього шару , виділяючи головних компонент (ГК, англ. principal component, PC) проекції, яку шар виводить в область визначення ознак під дією ядра. Заради зниження в кожному шарі розмірності уточненого представлення пропонується керована стратегія для вибору найінформативніших ознак серед виділених ЯМГК. Цей процес є таким:

- вишикувати ознак відповідно до їхньої взаємної інформації з мітками класів;

- для різних значень K та обчислити рівень похибки класифікації методом K-найближчих сусідів (К-НС, англ. K-nearest neighbor, K-NN), використовуючи лише ознак, найінформативніших на затверджувальному наборі;

- значення , з яким класифікатор досяг найнижчого рівня похибки, визначає число ознак для збереження.

Метод ЯМГК як будівельні блоки для БЯМ супроводжують деякі недоліки.

Для розуміння усного мовлення було розроблено простіший спосіб застосування ядрових машин для глибинного навчання.[195] Головна ідея полягає у використанні ядрової машини для наближення поверхневої нейронної мережі з нескінченним числом прихованих вузлів, і подальшому застосуванні складання для зрощування виходу цієї ядрової машини та сирого входу при побудові наступного, вищого рівня ядрової машини. Число рівнів у цій глибинній опуклій мережі є гіперпараметром системи в цілому, який повинен визначатися перехресною перевіркою.

Використання

Використання ШНМ вимагає розуміння їхніх характеристик.

- Вибір моделі: Це залежить від представлення даних та застосування. Надмірно складні моделі уповільнюють навчання.

- Алгоритм навчання: Існують численні компроміси між алгоритмами навчання. Майже кожен алгоритм працюватиме добре з правильними гіперпараметрами[en] для тренування на певному наборі даних. Проте, обрання та налаштування алгоритму для тренування на небачених даних вимагає значного експериментування.

- Робастність: Якщо модель, функція витрат та алгоритм навчання обрано належним чином, то отримувана в результаті ШНМ може стати робастною.

Можливості ШНМ підпадають під наступні широкі категорії:[джерело?]

- Наближення функцій, або регресійний аналіз, включно з передбачуванням часових рядів, наближенням пристосованості[en] та моделюванням.

- Класифікація, включно з розпізнаванням образів та послідовностей, виявленням нововведень та послідовним ухвалюванням рішень.

- Обробка даних, включно з фільтруванням, кластеруванням, сліпим відокремлюванням сигналу[en] та стисненням.

- Робототехніка, включно зі скеровуванням маніпуляторів та протезів.

- Автоматичне керування, включно з числовим програмним керуванням.

Застосування

Через свою здатність відтворювати та моделювати нелінійні процеси, ШНМ знайшли застосування в широкому діапазоні дисциплін.

До областей застосування належать ідентифікація систем[en] та керування (керування транспортними засобами, передбачування траєкторії,[196] автоматизація виробничих процесів, природокористування), квантова хімія,[197] гра в ігри та ухвалювання рішень (короткі нарди, шахи, покер), розпізнавання образів (радарні системи, ідентифікація облич[en], класифікація сигналів,[198] розпізнавання об'єктів та ін.), розпізнавання послідовностей (жестів, мовлення, рукописного тексту), медична діагностика, фінанси[199] (наприклад, автоматизовані системи торгівлі[en]), добування даних, унаочнення, машинний переклад, соціально-мережеве фільтрування[200] та фільтрування спаму електронної пошти[en].

ШНМ застосовували в діагностуванні раку, включно з раком легені,[201] простати, колоректальним раком,[202] а також щоби відрізняти лінії ракових клітин, сильно схильні до розповсюдження, від менш схильних до розповсюдження ліній, із застосуванням лише інформації про форму клітин.[203][204]

ШНМ також використовували для побудови чорноскринькових моделей в геонауках: гідрологія,[205][206] моделювання океану та прибережна інженерія[en],[207][208] та геоморфологія[209] є лише деякими з прикладів такого роду.

Нейронаука

Теоретична на обчислювальна нейронаука займається теоретичним аналізом та обчислювальним моделюванням біологічних нейронних систем. Оскільки нейронні системи намагаються відображувати пізнавальні процеси та поведінку, ця область є тісно пов'язаною з пізнавальним та поведінковим моделюванням.

Щоби досягти розуміння цього, нейробіологи намагаються зв'язати спостережувані біологічні процеси (дані), біологічно правдоподібні механізми нейронної обробки та навчання (моделі біологічних нейронних мереж) та теорію (теорію статистичного навчання та теорію інформації).

Дослідження мозку неодноразово приводили до нових підходів на основі ШНМ, таких як використання з'єднань для з'єднування нейронів у різних шарах, а не суміжних нейронів в одному шарі. Інше дослідження розвідувало використання декількох типів сигналу, або тоншого контролю, ніж булеві змінні (увімкнено/вимкнено). Динамічні нейронні мережі можуть динамічно утворювати нові з'єднання, та навіть нові нейронні вузли, в той же час деактивуючи інші.[210]

Типи моделей

Використовується багато типів моделей, визначених на різних рівнях абстрагування, та з моделюванням різних аспектів нейронних систем. Вони сягають від моделей короткотермінової поведінки окремих нейронів,[211] моделей того, як динаміка компонувань нейронних схем постає із взаємодії між окремими нейронами, і, нарешті, до моделей того, як може поставати поведінка з абстрактних нейронних модулів, які представляють цілі підсистеми. До них належать моделі короткотермінової та довготермінової пластичності, нейронних систем та їхнього відношення до навчанням та пам'яті від окремого нейрону й до рівня системи.

Теоретичні властивості

Обчислювальна сила

Як доведено теоремою Цибенка, багатошаровий перцептрон є універсальним наближувачем функцій. Проте, це доведення не є конструктивним відносно числа потрібних нейронів, топології мережі, ваг та параметрів навчання.

Особлива рекурентна архітектура з раціальнозначними вагами (на противагу до повноточнісних дійснозначних ваг) має повну силу універсальної машини Тюрінга,[212] використовуючи скінченне число нейронів та стандартні лінійні з'єднання. Крім того, використання ірраціональних значень для ваг дає в результаті машину з надтюринговою силою.[213]

Місткість

Властивість «місткості» (англ. "capacity") моделі грубо відповідає її здатності моделювати будь-яку задану функцію. Вона пов'язана з обсягом інформації, яку може бути збережено в мережі, та з поняттям складності.[джерело?]

Збіжність

Моделі можуть не збігатися послідовно на єдиному розв'язку, по-перше, через можливість існування багатьох локальних мінімумів, залежно від функції витрат та моделі. По-друге, вживаний метод оптимізації може не гарантувати збіжності, якщо він починається далеко від будь-якого локального мінімуму. По-третє, для достатньо великих даних або параметрів, деякі методи стають непрактичними. Проте, для тренування нейронної мережі АКММ[en] було представлено рекурсивний алгоритм найменших квадратів, і для цього алгоритму може бути гарантовано збіжність за один крок.[81]

Узагальнення та статистика

Застосування, чиєю метою є створення системи, яка добре узагальнюється до небачених зразків, стикаються з можливістю перетренування. Воно виникає в закручених або надмірно визначених системах, коли місткість мережі значно перевершує потребу в вільних параметрах. Існує два підходи, як впоруватися з перетренуванням. Першим є використовувати перехресне затверджування та подібні методи, щоби перевіряти на наявність перетренування та оптимально обирати гіперпараметри для зведення похибки узагальнення до мінімуму. Другим є використовувати якийсь із видів регуляризації. Це поняття виникає в імовірнісній (баєсовій) системі, де регуляризацію можливо виконувати шляхом обирання більшої апріорної ймовірності над простішими моделями, але також і в теорії статистичного навчання, де метою є зводити до мінімуму дві величини: «емпіричний ризик» та «структурний ризик», що грубо відповідають похибці над тренувальним набором та передбаченій похибці в небачених даних через перенавчання.

Керовані нейронні мережі, які використовують як функцію втрат середньоквадратичну похибку (СКП), для визначення довіри до тренованої моделі можуть використовувати формальні статистичні методи. СКП на затверджувальному наборі можливо використовувати для оцінювання дисперсії. Це значення потім можливо використовувати для обчислення довірчого інтервалу виходу мережі, виходячи з нормального розподілу. Здійснений таким чином аналіз довіри є статистично чинним, поки розподіл імовірності виходу залишається незмінним, і не вноситься змін до мережі.

Призначаючи нормовану експоненційну функцію, узагальнення логістичної функції, як функцію збудження шарові виходу нейронної мережі (або нормалізовану експоненційну складову в нейронній мережі на основі складових) для категорійних цільових змінних, виходи можна інтерпретувати як апостеріорні ймовірності. Це є дуже корисним у класифікації, бо дає міру впевненості в класифікаціях.

Нормалізованою експоненційною функцією збудження є:

Критика

Питання тренування

Поширеною критикою нейронних мереж, зокрема в робототехніці, є те, що для функціювання в реальному світі вони вимагають забагато тренування.[джерело?] До потенційних розв'язань належить випадкове переставляння тренувальних зразків, застосування алгоритму чисельної оптимізації, який не вимагає завеликих кроків при зміні з'єднань мережі слідом за зразком, та групування зразків до так званих міні-пакетів. Поліпшення дієвості навчання та здатності до збіжності для нейронних мереж завжди було областю постійних досліджень. Наприклад, завдяки введенню для нейронної мережі АКММ[en] алгоритму рекурсивних найменших квадратів, процесові навчання, щоби збігтися, потрібен лише один крок.[81]

Теоретичні питання

Жодна нейронна мережа не розв'язала таких обчислювально складних задач, як задача про вісім ферзів, задача комівояжера чи задача розкладання великих цілих чисел.

Фундаментальна перешкода полягає в тім, що вони не відображують роботу справжніх нейронів. Зворотне поширення є критичною частиною більшості штучних нейронних мереж, тоді як в біологічних нейронних мережах такого механізму не існує.[214] Як інформацію кодовано справжніми нейронами — не відомо. Сенсо́рні нейрони[en] генерують потенціал дії частіше, коли сенсор активовано, а м'язові клітини натягуються сильніше, коли пов'язані з ними мотонейрони частіше отримують потенціал дії.[215] Крім цієї справи передавання інформації від сенсорного нейрону до мотонейрону, про принципи обробки інформації біологічною нейронною мережею не відомо майже нічого.

Мотиви, що стоять за ШНМ, полягають не обов'язково в точному відтворенні нейронної функціональності, а в використанні біологічних нейронних мереж як натхнення. Тож головною претензією ШНМ є те, що вона втілює якийсь новий та потужний загальний принцип обробки інформації. На жаль, ці загальні принципи не є чітко визначеними. Часто претендують на те, що вони виникають із самої мережі. Це дозволяє простій статистичній асоціації (основній функції штучних нейронних мереж) бути описуваною як навчання або розпізнавання. Олександр Дьюдні[en] зауважив, що, в результаті, штучні нейронні мережі мають «риси чогось дармового, чогось наділеного особливою аурою ледарства та виразної відсутності зацікавлення хоч би тим, наскільки добрими ці комп'ютерні системи є. Жодного втручання людської руки (та розуму), розв'язки знаходяться мов чарівною силою, і ніхто, схоже, так нічого й не навчився».[216]

Біологічні мізки використовують як поверхневі, так і глибинні схеми, як про це каже анатомія мозку,[217] демонструючи велику різноманітність інваріантності. Венг[218] стверджував, що мозок самоз'єднується великою мірою відповідно до статистики сигналів, і, відтак, послідовний каскад не здатен вловлювати всі важливі статистичні залежності.

Апаратні питання

Великі та ефективні обчислювальні нейронні мережі вимагають значних обчислювальних ресурсів.[219] В той час як мозок має апаратне забезпечення, ідеально пристосоване для задачі обробки сигналів графом нейронів, імітування навіть спрощеного нейрону на архітектурі фон Неймана може змушувати розробника нейронної мережі заповнювати багато мільйонів рядків бази даних для його з'єднань, що може вимагати споживання незмірної кількості пам'яті та дискового простору. Крім того, розробникові часто потрібно передавати сигнали багатьма цими з'єднаннями та пов'язаними з ними нейронами, і цій задачі часто мусить відповідати величезна обчислювальна потужність та час ЦП.

Шмідгубер зауважує, що реанімацію нейронних мереж у двадцять першому сторіччі великою мірою обумовлено досягненнями в апаратному забезпеченні: з 1991 до 2015 року обчислювальна потужність, особливо забезпечувана ГПЗП (на ГП), зросла приблизно в мільйон разів, зробивши стандартний алгоритм зворотного поширення придатним для тренування мереж, які є на декілька шарів глибшими, ніж раніше.[220] Застосування паралельних ГП може скорочувати тривалості тренування з місяців до днів.[219]

Нейроморфна інженерія розв'язує цю апаратну складність безпосередньо, конструюючи не-фон-нейманові мікросхеми для безпосереднього втілення нейронних мереж у схемах. Ще одна мікросхема, оптимізована для обробки нейронних мереж, зветься тензорним процесором, або ТП (англ. Tensor Processing Unit, TPU).[221]

Практичні контрприклади до критики

Аргументами проти позиції Дьюдні є те, що нейронні мережі успішно застосовувалися для розв'язання багатьох складних і різнотипних задач, починаючи від автономних літальних апаратів,[222] і до виявлення шахрайств із кредитними картками та опанування гри Ґо.

Технічний письменник Роджер Бріджмен прокоментував це так:

Нейронні мережі, наприклад, знаходяться в обоймі не лише тому, що їх було піднесено до високих небес (що не було?), але також і тому, що ви можете створити успішну мережу без розуміння того, як вона працює: жмут чисел, що охоплює її поведінку, за всією ймовірністю буде «непрозорою, нечитабельною таблицею... нічого не вартою, як науковий ресурс». Незважаючи на його рішучу заяву, що наука не є технологією, Дьюдні тут, здається, ганьбить нейронні мережі як погану науку, тоді як більшість із тих, хто їх розробляє, просто намагаються бути добрими інженерами. Нечитабельна таблиця, яку може читати корисна машина, все одно буде вельми варта того, щоби її мати.Оригінальний текст (англ.)Neural networks, for instance, are in the dock not only because they have been hyped to high heaven, (what hasn't?) but also because you could create a successful net without understanding how it worked: the bunch of numbers that captures its behaviour would in all probability be "an opaque, unreadable table...valueless as a scientific resource". In spite of his emphatic declaration that science is not technology, Dewdney seems here to pillory neural nets as bad science when most of those devising them are just trying to be good engineers. An unreadable table that a useful machine could read would still be well worth having.— Роджер Бріджмен, Roger Bridgman's defence of neural networks[223]

Незважаючи на те, що аналізувати, чого навчилася штучна нейронна мережа, дійсно складно, робити це набагато простіше, ніж аналізувати, чого навчилася нейронна мережа біологічна. Крім того, дослідники, які беруть участь в пошуку алгоритмів навчання для нейронних мереж, поступово розкривають загальні принципи, що дозволяють машині, що вчиться, бути успішною. Наприклад, локальне й нелокальне навчання, та поверхнева й глибинна архітектура.[224]

Гібридні підходи

Прибічники гібридних моделей (що поєднують нейронні мережі та символьні підходи) стверджують, що така суміш може схоплювати механізми людського розуму краще.[225][226]

Типи

Детальніші відомості з цієї теми ви можете знайти в статті Типи штучних нейронних мереж.

Штучні нейронні мережі мають багато різновидів. Найпростіші, статичні, типи мають одну або більше статичних складових, включно з числом вузлів, числом шарів, вагами вузлів та топологією. Динамічні типи дозволяють одній або більше з них змінюватися в процесі навчання. Останні є набагато складнішими, але можуть скорочувати періоди навчання та давати кращі результати. Деякі типи дозволяють/вимагають, щоби навчання було «керованим» оператором, тоді як інші діють незалежно. Деякі типи працюють виключно в апаратному забезпеченні, тоді як інші є чисто програмними, і працюють на комп'ютерах загального призначення.

За типом вхідної інформації

- Аналогові нейронні мережі (використовують інформацію у формі дійсних чисел);

- Двійкові нейронні мережі (оперують з інформацією, представленою в двійковому вигляді).

За характером налаштування синапсів

- Мережі з фіксованими зв'язками (вагові коефіцієнти нейронної мережі вибираються відразу, виходячи з умов завдання, при цьому: dW / dt = 0 , де W — вагові коефіцієнти мережі);

- Мережі з динамічними зв'язками (для них в процесі навчання відбувається налаштування синаптичних зв'язків, тобто dW / dt ≠ 0, де W — вагові коефіцієнти мережі).

За представленнями

Якщо обчислювальна мережа має представляти елементи з якоїсь множини і кожному елементу відповідає якийсь вузол мережі, таке представлення називається локальним представленням. Його просто зрозуміти і реалізувати. Проте іноді представляти елементи множини вигідніше певним шаблоном активності, розподіленої на багатьох елементах мережі. Таке представлення називають розподіленим. Використання такого представлення може збільшити ефективність мережі.[227]

Галерея

-

Одношарова штучна нейронна мережа прямого поширення. Стрілки, що виходять з , для наочності опущено. Є p входів до цієї мережі, й q виходів. У цій системі значення q-того виходу обчислюватиметься як

-

Двошарова штучна нейронна мережа прямого поширення.

-

Штучна нейронна мережа.

-

Граф залежностей ШНМ.

-

Одношарова штучна нейронна мережа прямого поширення з 4 входами, 6 прихованими вузлами, та 2 виходами. Для заданого стану положення та напряму виводить значення керування для коліс.

-

Двошарова штучна нейронна мережа прямого поширення з 8 входами, 2x8 прихованими вузлами, та 2 виходами. Для заданого стану положення, напряму та інших змінних середовища, видає значення керування для маневрових двигунів.

Див. також

- 20Q

- Автокодувальник

- ADALINE

- Адаптивне табулювання на місці[en]

- Артикуляційний контролер мозочкової моделі[en] (АКММ, англ. CMAC)

- Асоціативна пам'ять

- Біокібернетика

- Біологічно натхнені обчислення[en]

- Генетичне програмування

- Генетичний алгоритм

- Генно-експресійне програмування[en]

- Глибинне навчання

- Encog[en]

- Звикання

- Згорткова нейронна мережа (ЗНМ, англ. CNN)

- Ієрархічна часова пам'ять

- Катастрофічна інтерференція[en]

- Когнітивна архітектура[en]

- Когнітивна наука

- Конективістська експертна система[en]

- Конектоміка[en]

- Культивована нейронна мережа[en]

- Мережа радіально-базисних функцій

- Метод групового урахування аргументів

- Мікросхема Ni1000[en]

- Моделі нейронного обчислення[en]

- Нейроеволюція

- Нейронаука

- Нейронна мережа з потенціалом дії[en]

- Нейронна мережа з часовою затримкою (англ. TDNN)

- Нейронний газ

- Нейронний машинний переклад

- Нелінійна ідентифікація систем[en]

- Нервове кодування

- Нечітка логіка

- Оптична нейронна мережа

- Конекціонізм

- Поняття машинного навчання[en]

- Програмне забезпечення нейронних мереж[en]

- Проект Blue Brain

- Процеси паралельного задоволення обмежень[en] (англ. PCSP)

- Рекурентні нейронні мережі

- Роботи BEAM[en]

- Самоорганізаційне відображення

- Систолічний масив

- Тензорно-добуткова мережа[en]

- Теорія адаптивного резонансу[en]

- Цифровий морфогенез[en]

- Штучне життя

Примітки

- ↑ McCulloch, Warren; Walter Pitts (1943). A Logical Calculus of Ideas Immanent in Nervous Activity. Bulletin of Mathematical Biophysics. 5 (4): 115—133. doi:10.1007/BF02478259. (англ.)

- ↑ Kleene, S.C. (1956). Representation of Events in Nerve Nets and Finite Automata. Annals of Mathematics Studies (англ.). № 34. Princeton University Press. с. 3—41. Процитовано 17 червня 2017. (англ.)

- ↑ Hebb, Donald (1949). The Organization of Behavior. New York: Wiley. ISBN 978-1-135-63190-1. (англ.)

- ↑ Farley, B.G.; W.A. Clark (1954). Simulation of Self-Organizing Systems by Digital Computer. IRE Transactions on Information Theory. 4 (4): 76—84. doi:10.1109/TIT.1954.1057468. (англ.)

- ↑ Rochester, N.; J.H. Holland; L.H. Habit; W.L. Duda (1956). Tests on a cell assembly theory of the action of the brain, using a large digital computer. IRE Transactions on Information Theory. 2 (3): 80—93. doi:10.1109/TIT.1956.1056810. (англ.)

- ↑ Rosenblatt, F. (1958). The Perceptron: A Probabilistic Model For Information Storage And Organization In The Brain. Psychological Review. 65 (6): 386—408. CiteSeerX 10.1.1.588.3775. doi:10.1037/h0042519. PMID 13602029. (англ.)

- ↑ а б Werbos, P.J. (1975). Beyond Regression: New Tools for Prediction and Analysis in the Behavioral Sciences. (англ.)

- ↑ David H. Hubel and Torsten N. Wiesel (2005). Brain and visual perception: the story of a 25-year collaboration. Oxford University Press US. с. 106. ISBN 978-0-19-517618-6. (англ.)

- ↑ а б в г д е Schmidhuber, J. (2015). Deep Learning in Neural Networks: An Overview. Neural Networks. 61: 85—117. arXiv:1404.7828. doi:10.1016/j.neunet.2014.09.003. PMID 25462637. (англ.)

- ↑ Ivakhnenko, A. G. (1973). Cybernetic Predicting Devices. CCM Information Corporation. (англ.)

- ↑ Ivakhnenko, A. G.; Grigorʹevich Lapa, Valentin (1967). Cybernetics and forecasting techniques. American Elsevier Pub. Co. (англ.)

- ↑ Minsky, Marvin; Papert, Seymour (1969). Perceptrons: An Introduction to Computational Geometry. MIT Press. ISBN 0-262-63022-2. (англ.)

- ↑ Rumelhart, D.E; McClelland, James (1986). Parallel Distributed Processing: Explorations in the Microstructure of Cognition. Cambridge: MIT Press. ISBN 978-0-262-63110-5. (англ.)

- ↑ J. Weng, N. Ahuja and T. S. Huang, "Cresceptron: a self-organizing neural network which grows adaptively, " Proc. International Joint Conference on Neural Networks, Baltimore, Maryland, vol I, pp. 576—581, June, 1992. (англ.)

- ↑ а б J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation of 3-D objects from 2-D images, " Proc. 4th International Conf. Computer Vision, Berlin, Germany, pp. 121—128, May, 1993. (англ.)

- ↑ J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation using the Cresceptron, " International Journal of Computer Vision, vol. 25, no. 2, pp. 105—139, Nov. 1997. (англ.)

- ↑ а б S. Hochreiter., "Untersuchungen zu dynamischen neuronalen Netzen, " Diploma thesis. Institut f. Informatik, Technische Univ. Munich. Advisor: J. Schmidhuber, 1991. (нім.)

- ↑ Hochreiter, S. та ін. (15 січня 2001). Gradient flow in recurrent nets: the difficulty of learning long-term dependencies. У Kolen, John F.; Kremer, Stefan C. (ред.). A Field Guide to Dynamical Recurrent Networks. John Wiley & Sons. ISBN 978-0-7803-5369-5.

{{cite book}}: Явне використання «та ін.» у:|last2=(довідка) (англ.) - ↑ J. Schmidhuber., "Learning complex, extended sequences using the principle of history compression, " Neural Computation, 4, pp. 234—242, 1992. (англ.)

- ↑ Sven Behnke (2003). Hierarchical Neural Networks for Image Interpretation (PDF). Lecture Notes in Computer Science. Т. 2766. Springer. (англ.)

- ↑ Smolensky, P. (1986). Information processing in dynamical systems: Foundations of harmony theory.. У D. E. Rumelhart, J. L. McClelland, & the PDP Research Group (ред.). Parallel Distributed Processing: Explorations in the Microstructure of Cognition. Т. 1. с. 194—281.

- ↑ а б Hinton, G. E.; Osindero, S.; Teh, Y. (2006). A fast learning algorithm for deep belief nets (PDF). Neural Computation[en]. 18 (7): 1527—1554. doi:10.1162/neco.2006.18.7.1527. PMID 16764513. (англ.)

- ↑ Hinton, G. (2009). Deep belief networks. Scholarpedia. 4 (5): 5947. Bibcode:2009SchpJ...4.5947H. doi:10.4249/scholarpedia.5947.

{{cite journal}}: Обслуговування CS1: Сторінки із непозначеним DOI з безкоштовним доступом (посилання) (англ.) - ↑ Ng, Andrew; Dean, Jeff (2012). Building High-level Features Using Large Scale Unsupervised Learning. arXiv:1112.6209 [cs.LG]. (англ.)

- ↑ Yang, J. J.; Pickett, M. D.; Li, X. M.; Ohlberg, D. A. A.; Stewart, D. R.; Williams, R. S. (2008). Memristive switching mechanism for metal/oxide/metal nanodevices. Nat. Nanotechnol. 3 (7): 429—433. doi:10.1038/nnano.2008.160. (англ.)

- ↑ Strukov, D. B.; Snider, G. S.; Stewart, D. R.; Williams, R. S. (2008). The missing memristor found. Nature. 453 (7191): 80—83. Bibcode:2008Natur.453...80S. doi:10.1038/nature06932. PMID 18451858. (англ.)

- ↑ Cireşan, Dan Claudiu; Meier, Ueli; Gambardella, Luca Maria; Schmidhuber, Jürgen (21 вересня 2010). Deep, Big, Simple Neural Nets for Handwritten Digit Recognition. Neural Computation. 22 (12): 3207—3220. doi:10.1162/neco_a_00052. ISSN 0899-7667. (англ.)

- ↑ 2012 Kurzweil AI Interview [Архівовано 31 серпня 2018 у Wayback Machine.] with Jürgen Schmidhuber on the eight competitions won by his Deep Learning team 2009—2012 (англ.)

- ↑ How bio-inspired deep learning keeps winning competitions | KurzweilAI. www.kurzweilai.net (амер.). Архів оригіналу за 31 серпня 2018. Процитовано 16 червня 2017. (англ.)

- ↑ Graves, Alex; and Schmidhuber, Jürgen; Offline Handwriting Recognition with Multidimensional Recurrent Neural Networks, in Bengio, Yoshua; Schuurmans, Dale; Lafferty, John; Williams, Chris K. I.; and Culotta, Aron (eds.), Advances in Neural Information Processing Systems 22 (NIPS'22), 7–10 December 2009, Vancouver, BC, Neural Information Processing Systems (NIPS) Foundation, 2009, pp. 545—552. (англ.)

- ↑ а б Graves, A.; Liwicki, M.; Fernandez, S.; Bertolami, R.; Bunke, H.; Schmidhuber, J. (2009). A Novel Connectionist System for Improved Unconstrained Handwriting Recognition (PDF). IEEE Transactions on Pattern Analysis and Machine Intelligence. 31 (5): 855—868. doi:10.1109/tpami.2008.137. (англ.)

- ↑ а б в Graves, Alex; Schmidhuber, Jürgen (2009). Bengio, Yoshua; Schuurmans, Dale; Lafferty, John; Williams, Chris editor-K. I.; Culotta, Aron (ред.). Offline Handwriting Recognition with Multidimensional Recurrent Neural Networks. Neural Information Processing Systems (NIPS) Foundation: 545—552. (англ.)

- ↑ Graves, A.; Liwicki, M.; Fernández, S.; Bertolami, R.; Bunke, H.; Schmidhuber, J. (May 2009). A Novel Connectionist System for Unconstrained Handwriting Recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence. 31 (5): 855—868. doi:10.1109/tpami.2008.137. ISSN 0162-8828. (англ.)

- ↑ а б Cireşan, Dan; Meier, Ueli; Masci, Jonathan; Schmidhuber, Jürgen (August 2012). Multi-column deep neural network for traffic sign classification. Neural Networks. Selected Papers from IJCNN 2011. 32: 333—338. doi:10.1016/j.neunet.2012.02.023. (англ.)

- ↑ Ciresan, Dan; Giusti, Alessandro; Gambardella, Luca M.; Schmidhuber, Juergen (2012). Pereira, F.; Burges, C. J. C.; Bottou, L.; Weinberger, K. Q. (ред.). Advances in Neural Information Processing Systems 25 (PDF). Curran Associates, Inc. с. 2843—2851. (англ.)

- ↑ а б Ciresan, Dan; Meier, U.; Schmidhuber, J. (June 2012). Multi-column deep neural networks for image classification. 2012 IEEE Conference on Computer Vision and Pattern Recognition: 3642—3649. doi:10.1109/cvpr.2012.6248110. ISBN 978-1-4673-1228-8. (англ.)